本文轉自機器之能,原文地址

作者簡介:童超,創新奇智產品總監,負責產品規劃及管理工作。畢業於喬治華盛頓大學,獲得MBA學位,並於香港科技大學獲得理學碩士學位。

最近AI倫理科學家Timnit Gebru被大佬Jeff Dean炒魷魚的事情搞的沸沸揚揚,兩人幾番論戰也沒有明確的結論。但從與朋友的交談中,讓大家更感興趣的不是這件事情的是非因果,而是Gebru的職位:AI倫理科學家,這是個什麼角色,作用是什麼?AI又與「倫理」有何聯繫……而有「倫理」的AI又需要是什麼樣子?

為何AI會與倫理這個社會科學產生交集

AI是一門自然科學,倫理又是比較純粹的社會科學,有一些研究背景的同學就會發現,當兩者發生交集的時候,我們面對的很有可能是一個哲學問題了……我們這裡不討論讓人糾結和燒腦的哲學邏輯,只涉及AI為何會產生這樣與傳統技術不同的問題。

「不確定」的本質讓AI的決策天生隱含爭議

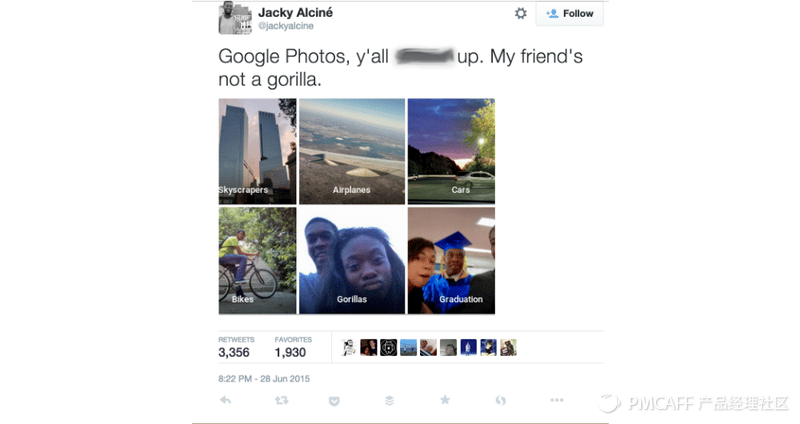

我們打開AI演算法(機器學習)的盒子,會發現任何AI模型的輸出結果都可以分解為一連串的小數 – 概率,比如AI的結果輸出某人信用卡的交易是一筆盜刷,實際上模型輸出的結果是P(盜刷 | 也許是個條件概率) = 0.971。這樣的決策輸出,顯然與我們普適接受的「鐵證如山」、「鐵一般的事實」有不小的出入,這種天生帶來的不確定性會讓AI參與甚至決定一些重要的決定時收到質疑,甚至爭議。那麼,當我們利用AI的能力時,如何可以明晰或者接受這種不確定性,就顯得尤為重要。更為關鍵的是,理解並接受這種不確定性不僅僅是技術問題,更是一個需要完整、全面思考的認知問題。一個備受爭議的例子,強如Google,還是會犯下如此嚴重的錯誤:把我們的黑人朋友識別為大猩猩……Google因為這樣的錯誤,又需要多少公關資源來彌補這樣的「不確定」輸出?

AI的出現轉換了決策主體,必然帶來倫理的挑戰

當我們放開雙手雙腳,把自己交給一個L4的自動駕駛車輛時,顯然在道路上的車輛決策主體發生了轉移:從司機轉移到了車輛,或者更具體的 – AI。與此同時,我們更應該意識到,決策主體的轉移會帶來責任的轉移,無論是車輛安全、道路安全還是行人安全,AI將負擔起或者應當成為這種責任主體。我們假設,在高速路上,正在無人駕駛的車輛出現了事故,撞擊了行人或者一頭鹿,那麼誰來負這個最終的責任?車輛的生產商是否需要負責?研發AI的企業是否需要負責?為AI採集和標註數據的個人需要負責?毫無疑問,如果我們把這樣的一個系統邏輯延伸到任何行業尤其是與人類關鍵行為相關的場景時,AI的這種快速革新替代帶來的是倫理和立法的重新審視,保證我們安全無憂地與AI相處。

號外 – 關於美國政府對Trustworthy AI的行政命令

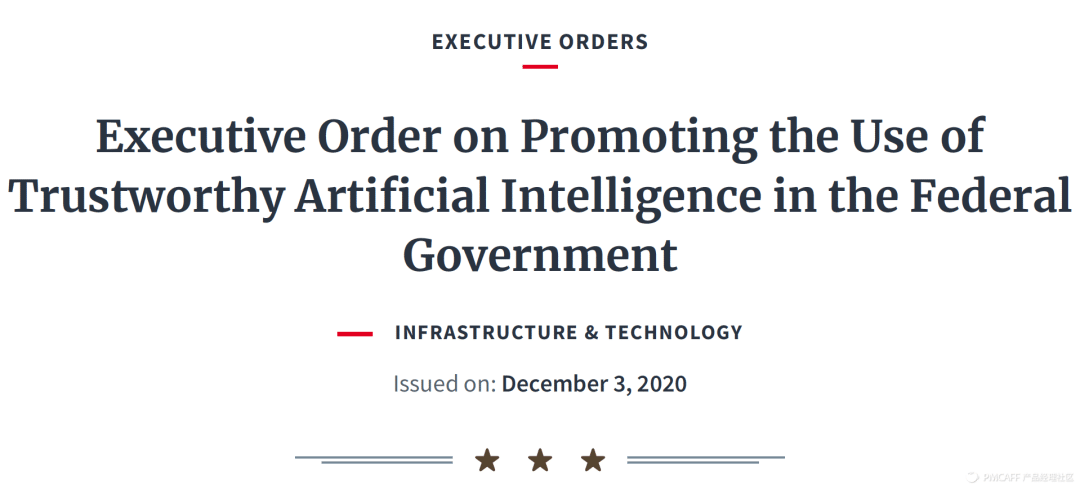

就在12月3日,白宮發布了針對AI應用的行政命令(行政命令的定義請各位自行補課)

《Executive Order on Promoting the Use of Trustworthy Artificial Intelligence in the Federal Government》

總結來講,白宮要求與美國政府預算相關的所有AI應用都要保證遵循以下的原則:

(1) Lawful and respectful of Nation’s value – 服務國家利益

(2) Purposeful and performance-driven – 實用優先

(3) Accurate, reliable and effective – 性能優異

(4) Safe, secure and resilient – 安全保障

(5) Understandable – 用戶尤其是SME(Subject Matter Expert)可以理解

(6) Responsible and traceable – AI的權責體系分明

(7) Regularly monitored – AI全程可追蹤

(8) Transparent – 面向監管的100%透明

(9) Accountable – 組織圍繞AI的體系保障

以上的原則,全部都對AI的設計、建設和運營提出了完全新層次的要求,不僅要可用,好用,更要敢用,放心用,公平的用。能夠明確的是,正在發生的科技大戰中,美國已經在布局更完整的AI體系了。

可信的AI系統組成

在這裡,我們用一個典型的AI流程來觀察一個可信的AI系統都需要包含什麼元素,用接下來的幾個小節來分別展開具體的內容。

可信的AI系統 – 從數據開始

說到Timnit Gebru,我們不妨從她的一篇論文開始探索如何建立一個可信的、AI可用的數據資源,也可以解釋AI倫理科學家的一部分工作。以下的結構一部分參考了Gebru的論文《Datasheets for Datasets》,具體內容不再標註:

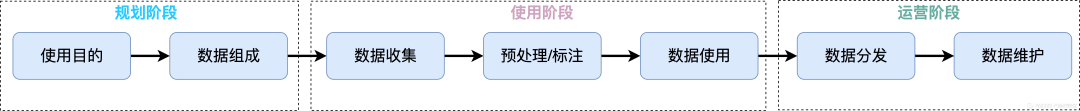

數據對於機器學習可以類比糧食對人類的重要程度。當我們啟動AI項目時,第一步必然是要釐清涉及的數據資源,為我們需要的數據集建立完整的生命周期的檔案,能夠幫助參與到AI項目的所有人(包含數據工程師、演算法工程師、業務專家)對於這個最重要資產有全面和一致的認識。在這裡,我們使用一種靜態(同樣是這個方式的現有局限)的方式做出記錄,通過一系列的問題引導出需要的信息,逐步形成一份數據集的數據表(Datasheet)。從數據的使用流程上來看,需要覆蓋的是:

(1)規劃階段:在使用數據集之前,需要對數據使用的目的以及數據的組成做出明確的解釋,保證後續使用數據的人能夠對數據的創建目的有最直接的理解,並且提升完整的AI流程的「透明」程度

使用目的:

- 數據集創建的目的,是否有具體需要完成的任務?用一段話來描述這個任務;

- 創建數據集的負責人是誰,負責人代表的或者所在的部分或者組織是哪裡?

- 數據集的提供者或者資源提供方是誰?

數據組成:

- 組成數據集的實體是什麼?圖片、文件、自然人信息或者幾種實體類型的組合?羅列出所有的實體類型;

- 數據集中,不同類型的實體數量有多少?

- 建立的數據集包含能夠獲取的最多的、最完整的記錄?還是從完整記錄中抽取的一部分數據集,抽取的方式如何?

- 數據集的一條原始數據組成示例;

- 數據及是否存在一些標註(Label)或者目標變數?

- 每條記錄中是否有缺失的欄位或者信息?缺失的原因是什麼?

- 數據集的記錄之間是否存在某些顯著的聯繫?比如社交網路的連接?

- 是否有對數據集切分策略的建議?如何切分training, validation, test的比例和方法;

- 數據集中是否存在一些記錄錯誤、固有雜訊或者冗餘信息等;

- 數據集的組成是否是獨立的?如果依靠外部來源組成數據,那麼外部的來源是什麼,外部數據的輸入是否持續,是否有獲取的風險?

- 數據集的組成是否存在涉密的信息?若有,請列出涉密的欄位及描述;

- 數據集是否包含個人信息?如有,請列出與個人相關的信息描述;

- 數據集是否包含一些關於人口的統計信息,例如年齡,性別等?

- 數據集是否有可能通過任何的方法識別定位到個人,如若干信息的組合?

- 數據集是否報其他的一些敏感信息,比如涉及國家安全、企業營收等?

(2)使用階段:數據的使用階段,清晰翔實的數據信息可以顯著地減少數據工程師和演算法工程師冷啟動的時間,提升團隊內部和團隊之間的溝通效率。

數據收集:

- 數據集的每一條記錄收集的途徑,直接從業務系統或者從其他數據集間接計算獲得?

- 數據集的每一條記錄收集的方式,是通過感測器、軟體系統、API還是人工錄入?這些方式是否可以驗證有效性和安全性;

- 如果數據集來源於原始數據的抽樣(Sampling),抽樣的策略是什麼?

- 數據集收集過程的參與者是誰?這些人員是如何獲取報酬的?

- 數據集獲取的時間周期是什麼?

- 數據集的收集過程是否受到過機構或者組織的審查和驗證?

- 如果數據集涉及到個人,還需要回到如下的問題(如果沒有則可跳過):

- 獲取個人數據的方式是從當事人直接授權,還是從第三方渠道獲取?獲取的渠道是什麼;

- 如果是從個人直接獲取,當事人是否知曉並同意數據會被收集並被模型使用;

- 如果當事人同意,是否有機制保障他(她)隨時可以撤銷這種授權?

- 是否有對於這種使用個人數據的AI模型做出對個人影響程度的分析?

預處理/標註:

- 數據集使用的任何預處理或者標註的技術,如缺失值處理、特徵抽取、數據分桶等;

- 在預處理之後,原始數據集是否也同步保存?

- 預處理或者標註的過程是否使用到了一些軟體或者工具?工具的名稱是什麼;

數據使用:

- 數據集是否已經被用到了其他的AI任務中?如有,羅列任務並作出描述;

- 數據集的使用過程相關的論文或者系統的列表;

- 這個數據集是否可能會被用到其他的任務中?

- 數據集組成或者預處理階段的記錄是否會影響使用階段,具體來講會對建模造成對一些特定團隊或者個人的不公平待遇?

- 數據集是否有不應該被使用的任務中?

(3)運營階段:這個階段是數據集通過分析或者建模之後直接面向用戶或者場景提供服務能力,持續地更新和追蹤數據集,能夠及時管理數據和模型的效果和性能,也保證應用的可信程度。

數據分發:

- 數據集是否會被授權分發至第三方,授權方是誰?

- 數據集分發的方式是什麼,tarball, GitHub, API還是其他?

- 數據集分發的時間?

- 數據集分發是否會涉及知識產權或者使用條款與協議?

- 數據集分發時,原始數據的收集是否會有連帶的知識產權責任?

- 數據集分發時,是否有專家或者負責人來監督分發過程及對分發的結果負責?

數據維護:

- 負責數據集維護的負責人是誰?負責人的聯繫方式?

- 數據集是否存在勘誤表,如何訪問?

- 數據集是否會更新,更新的內容是什麼?

- 如果涉及到個人數據的使用,是否有數據使用的期限或其他限制?

- 數據集是否存在版本?新老版本的管理方式是如何的,老版本的數據集是否還需繼續維護?

- 涉及到數據集的更新/維護,數據集的貢獻者貢獻機制是什麼?

一個完整的例子可以參考論文中的樣例

以上的問題儘可能詳細,保證我們在觀察和使用數據時,都可以從技術、業務、商業、法律、倫理多個維度來分析數據在完整的AI流程中的可信度。

可信的AI系統 – 模型的「黑盒子」

對於AI的信任程度,除了對原始數據的考察之外,更讓人捉摸不透的是那些看起來神秘且複雜的機器學習模型,如果無法理解或者接受這些模型,由模型輸出的結果必然也會收到質疑。這樣的問題在一些與社會資源相關的公共問題上尤為明顯,例如就業、醫療、金融服務、執法等。在美國有這樣的一個例子,一些地方法院法官開始利用AI模型進行嫌疑犯量刑的刑期預測,我們暫不展開討論這個應用的正義性,假設從法律和道德上可以接受,那麼能夠讓法官放心使用的一個核心考量就是他們是否能夠理解AI模型,能夠認為AI做出的判斷與他們的邏輯相符。

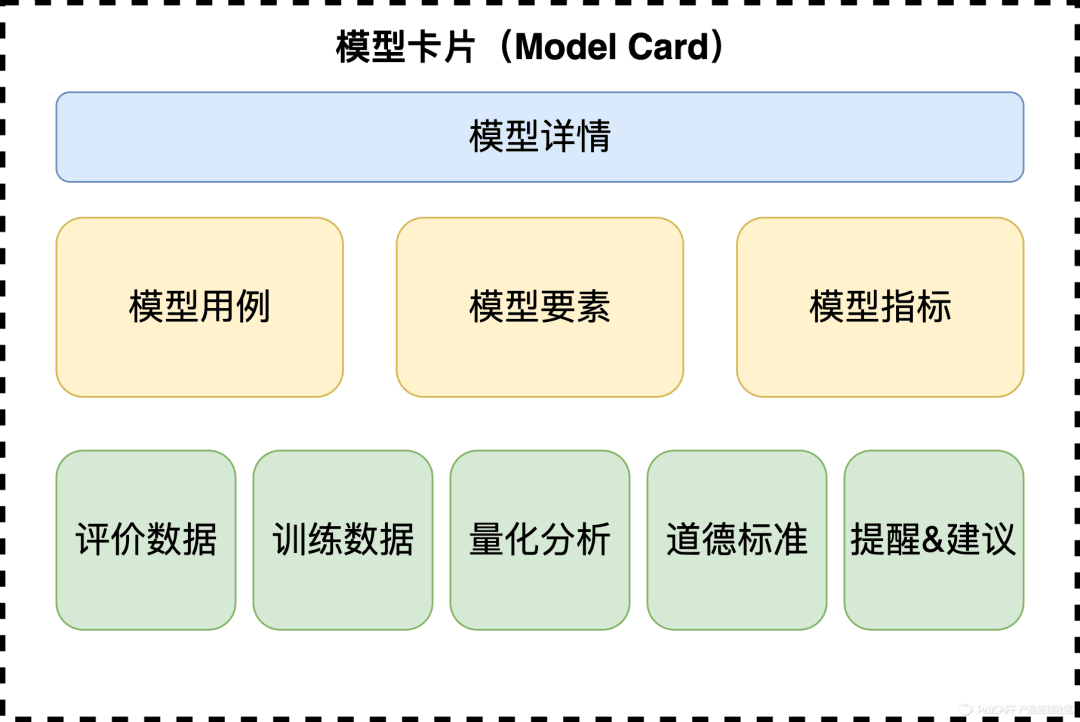

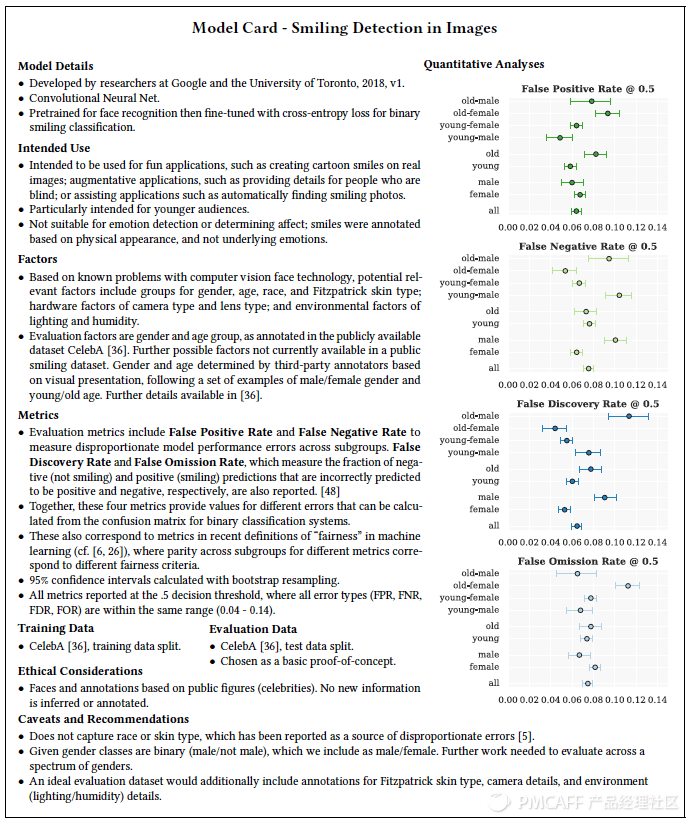

在這裡,我又會提到Gebru,在研究中,她的Google團隊以及多倫多大學的學者共同提出了一種類似於Datasheets的方法 – Model Cards(模型卡片)。模型卡片是一個附在幾個發布的機器學習模型的1-2頁的記錄描述,用於向相應的讀者解釋模型的多維度信息,以求打開AI模型的「黑盒子」。

一個模型卡片可以分為以下的幾個元素:

模型詳情:

- 模型開發者(組織):負責的自然人或者團隊;

- 模型發布日期:模型發布上線的日期及時間;

- 模型版本:模型發布時的版本編號;

- 模型類型:是傳統機器學習模型,深度模型等等;

- 模型參考或者復現的論文,或者借鑒的開源工具及來源;

- 模型引用的規範;

- 模型的使用許可;

- 關於模型的反饋方式(聯繫方式);

模型用例:

- 模型應用的用戶用例,或者場景描述,例如用在信用卡實時的交易反欺詐;

- 模型應用面向的用戶(群體);

- 模型應用的限制或者禁用的用例,例如不能被用作何種群體的人臉識別;

模型要素:

- 模型適用的群體描述:尤其是涉及到自然人的模型,清晰地定義適用的群體,以及在不同群體之間的模型表現及差異;

- 模型適用的外部設備或系統描述:如一些CV的場景,不同的攝像頭型號都可能會引起模型表現的差異;

- 模型適用的外部環境描述:同樣的,在CV場景下,不同的光照條件、環境溫濕度都可能造成模型效果的漂移甚至錯誤;

- 其他「靜默」要素:除了上述要素之外,還有可能隱藏在表面之下的要素會影響模型的效果;

- 評價要素:一些評價指標的設計是否會影響模型考察的全面性?

模型指標:

- 模型選擇的指標有哪一些?選擇這一些指標的原因是什麼?

- 指標閾值,調整一些關鍵指標默認閾值的原因是什麼?

- 應對不確定性和可變性的方式方法是什麼?

評價數據:

- 用於評價的數據集描述及選擇這一部分數據集的原因;

- 這一部分數據集是否經過預處理?預處理的方式是什麼?

訓練數據:

- 可以參考上方Datasheets的內容進行引用或者精簡複述至此;

量化分析:

- 回溯到模型要素的框架內,對於不同要素之內的分析要做到量化結果輸出,並列印到模型卡片內;

- 在不同的模型要素之間,輸出量化的分析結果輸出;

倫理考量:

- 在開發的過程當中,是否用到了隱私數據?

- 模型是否會被應用到一些對於人類很關鍵的事務中,例如安全、醫療等;

- 模型的使用是否存在一些風險和對於一些人群的傷害?

- 在模型開發的過程中,有否執行一些降低風險的方法;

- 在模型用例的羅列中,是否存在一些有爭議的用例?

提醒&建議:

- 羅列出以上還未包含但很重要的模型的相關信息;

給出一個例子:

模型卡片的輸出延續了針對數據的Datasheets的方法,通過一系列的問題形成一個可以執行的思維框架,連接不同的AI利益相關人共同提升AI的透明度和可信度。在我看來,這也是目前為止AI的倫理研究給出的最接地氣的方案,推進很難,但這個功課對於任何一個成熟的AI應用來講,遲早都是要補上的課。

可信的AI系統 – 人機協作

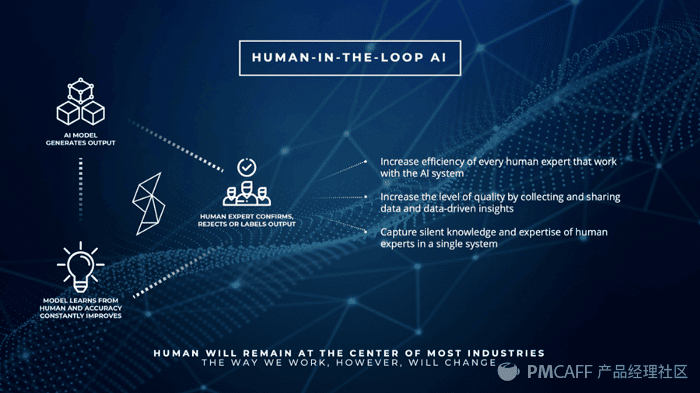

AI的技術視角從來都是以「無人化」、「自動化」作為追求的目標,這顯然也是我們希望AI能夠實現的目標,但從解決問題的產品或者社會視角來看,AI的應用更好的方式一定是人機協作或者人機協同,缺少了AI的人力,就是回到之前的生活,缺乏了一些效率,人類的工作要更枯燥乏味一些;但是缺少了人的AI,則很有可能面對的是失敗、濫用甚至叛亂。

在人與AI的協作當中,形成的完整循環(Human-in-the-loop AI)讓這兩種思考對象形成合力,更快、更準確地解決共同的問題。

從HILP的角度來看,創造一個可信的AI我們同樣要試著回答自己這幾個問題:

(1)人與AI是否有共同要解決的任務,我們在設計和開發階段是否能夠保證這兩方的利益相同?

(2)人是否能夠從數據開始在每一個環節都可以參與到AI的輸入和輸出,保證人的隨時介入與信息輸入?

(3)AI的設計能否及時甚至實時響應人的正確建議和調整方向,優化演算法目標?

(4)人是否可以及時從這個人機協作的系統中及時抽取前所未見的洞察或者知識納入自己的知識體系?

實現一個人機協作的AI系統是不容易的,但有了這樣的人機協同,可信這樣的一個結果呈現就可以融入到人機協作的每一次操作與建議中,變成一種過程變數,信任也會形成累積效應,降低了「可信」的門檻和周期。

可信的AI系統 – 第三方認證

自從產生信用這個詞開始,信用都一定需要一個機構進行背書,大到國家,小到專家認證,才能夠支撐信用體系的運行和延續。那麼從AI的應用開始,如果要建設一個可信的系統,建設方就一定需要一個第三方的背書,來從外部驗證信用,並且AI的消費者或者使用方也可以最快速度得到這一份信用的確認。從現在來看,可能會有幾種方式:

(1)GDPR(General Data Protection Regulation):從GDPR來看,這是適用企業需要無條件遵守的,並不是一個資格證書。但是符合GDPR的認證或者認可,目前還沒有統一的方式,我們可以通過ISO體系的一些認證和專家的指導來只限符合GDPR框架的「認證」;

(2)CCPA(California Consumer Privacy Act):從2018年開始執行,加州的要求與GDPR性質相同,我們也無法直接進行認證,而是需要類似的方法按照CCPA的要求尋找已經存在的認證方式;

(3)等保認證:我們國家公安部頒布的信息系統安全等級保護認證,這應該是國內企業最直接可以得到的權威認證;

(4)ISO體系認證;

(5)各行業的行業公約或者協議:比如銀行業的巴塞爾公約等;

Reference

1、《Datasheets for Datasets》, Timnit Gebru, Jamie Morgenstern, Briana Vecchione, Jennifer Wortman Vaughan, Hanna Wallach, Hal Daumé III, Kate Crawford

2、《model cards for model reporting》, Margaret Mitchell, Simone Wu, Andrew Zaldivar, Parker Barnes, Lucy Vasserman, Ben Hutchinson, Elena Spitzer, Inioluwa Deborah Raji, Timnit Gebru

3、《Executive Order on Promoting the Use of Trustworthy Artificial Intelligence in the Federal Government》

4、《GDPR Regulations》

5、《CCPA Fact Sheet》

6、https://www.partnershiponai.org/

1 Comment

Very good information. Lucky me I ran across your blog by accident (stumbleupon).

I’ve saved as a favorite for later!