大型預訓練語言模型無疑是自然語言處理(NLP)最新研究進展的主要趨勢。

雖然很多AI專家都認同安娜羅傑斯的說法,即用更多的數據和計算能力獲得最先進的結果並不是研究新聞,但其他NLP意見領袖也看到了當前趨勢中的一些積極時刻。例如,DeepMind的研究科學家Sebastian Ruder 指出,這些大語言框架有助於我們看到當前範式的基本局限。

由於變形金剛佔據了NLP排行榜,因此通常很難遵循修正案的內容,從而使新的大語言模型能夠設置出另一種最先進的結果。為了幫助您及時了解最新的NLP突破,我們總結了研究論文,其中包括GLUE基準的當前領導者:來自卡內基梅隆大學的XLNet,來自百度的ERNIE 2.0和來自Facebook AI的RoBERTa。

如果這些可訪問的AI研究分析和摘要對您有用,您可以訂閱以下我們的常規行業更新。

如果你想跳過,我們推薦的論文如下:

大語言框架

1. XLNET:用於語言理解的廣義自回歸預訓練,由ZHILIN YANG,ZIHANG DAI,YIMING YANG,JAIME CARBONELL,RUSLAN SALAKHUTDINOV,QUOC V. LE

原始摘要

憑藉對雙向上下文進行建模的能力,基於自動回歸語言建模的預訓練方法可以實現基於BERT的預訓練的去噪自動編碼實現更好的性能。然而,依賴於使用掩碼破壞輸入,BERT忽略了屏蔽位置之間的依賴性並且受到預訓練 – 微調差異的影響。根據這些優點和缺點,我們提出了XLNet,一種廣義自回歸預訓練方法,它(1)通過最大化分解階的所有排列的預期可能性來學習雙向上下文,並且(2)由於其自回歸,克服了BERT的局限性。公式。此外,XLNet將最先進的自回歸模型Transformer-XL的創意整合到預訓練中。根據經驗,XLNet在20項任務上優於BERT,

我們的總結

來自卡內基梅隆大學和谷歌的研究人員開發了一種新的模型XLNet,用於自然語言處理(NLP)任務,如閱讀理解,文本分類,情感分析等。XLNet是一種通用的自回歸預訓練方法,它利用了自回歸語言建模(例如,Transformer-XL)和自動編碼(例如BERT)的優點,同時避免了它們的限制。實驗證明,新模型優於BERT和Transformer-XL,並在18個NLP任務上實現了最先進的性能。

本文的核心思想是什麼?

- XLNet結合了BERT的雙向功能和Transformer-XL的自回歸技術:

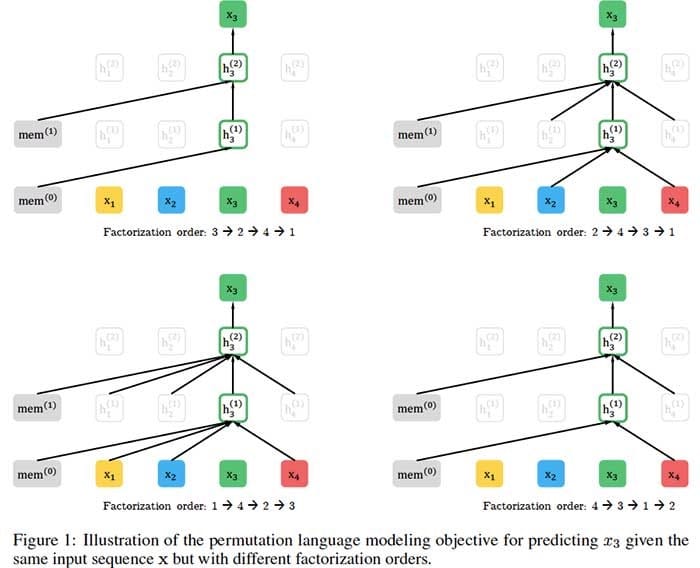

- 與BERT一樣,XLNet使用雙向上下文,這意味着它會查看給定令牌之前和之後的單詞以預測它應該是什麼。為此,XLNet針對分解順序的所有可能排列最大化序列的預期對數似然。

- 作為一種自回歸語言模型,XLNet不依賴於數據損壞,因此避免了由於屏蔽導致的BERT限制 – 即,預跟蹤 – 微調差異以及未屏蔽的令牌彼此獨立的假設。

- 為了進一步改進預訓練的架構設計,XLNet集成了Transformer-XL的片段重現機制和相對編碼方案。

什麼是關鍵成就?

- XLnet在20項任務上的表現優於BERT,通常大幅提升。

- 新模型在18個NLP任務上實現了最先進的性能,包括問答,自然語言推理,情感分析和文檔排名。

AI社區的想法是什麼?

- “國王死了。吾皇萬歲。BERT的統治可能即將結束。XLNet是CMU和谷歌人的新模型,在20項任務上勝過BERT。“ – Deepmind的研究科學家Sebastian Ruder。

- “XLNet可能會成為任何NLP從業者的重要工具…… [它]是NLP最新的尖端技術。” – Keita Kurita,卡內基梅隆大學。

未來的研究領域是什麼?

- 將XLNet擴展到新的領域,例如計算機視覺和強化學習。

什麼是可能的商業應用?

- XLNet可以幫助企業解決各種NLP問題,包括:

- 聊天機器人一線客戶支持或回答產品查詢;

- 基於客戶評論和社交媒體評估品牌知名度和認知度的情緒分析;

- 在文件庫或在線等搜索相關信息

你在哪裡可以得到實現代碼?

- 作者發布了XLNet的官方Tensorflow實現。

- GitHub上也提供了PyTorch模型的實現。

2. ERNIE 2.0:語言理解的持續預培訓框架,由YU SUN,SHUOHUAN WANG,YUKUN LI,SHIKUN FENG,HAO TIAN,WU WU,HAIFENG WANG

原始摘要

最近,預訓練模型在各種語言理解任務中取得了最新成果,這表明大型語料庫的預訓練可能在自然語言處理中起着至關重要的作用。目前的預訓練程序通常側重於通過幾個簡單的任務來訓練模型,以掌握單詞或句子的共現。然而,除了共存之外,訓練語料庫中還存在其他有價值的詞彙,句法和語義信息,如命名實體,語義接近和語篇關係等。為了最大限度地提取來自訓練語料庫的詞彙,句法和語義信息,我們提出了一個名為ERNIE 2.0的連續預訓練框架,該框架通過持續的多任務學習來逐步建立和學習預訓練任務。實驗結果表明,ERNIE 2.0在16項任務上優於BERT和XLNet,包括GLUE基準上的英語任務和中文的幾項常見任務。源代碼和預先訓練的模型已發佈於https://github.com/PaddlePaddle/ERNIE。

我們的總結

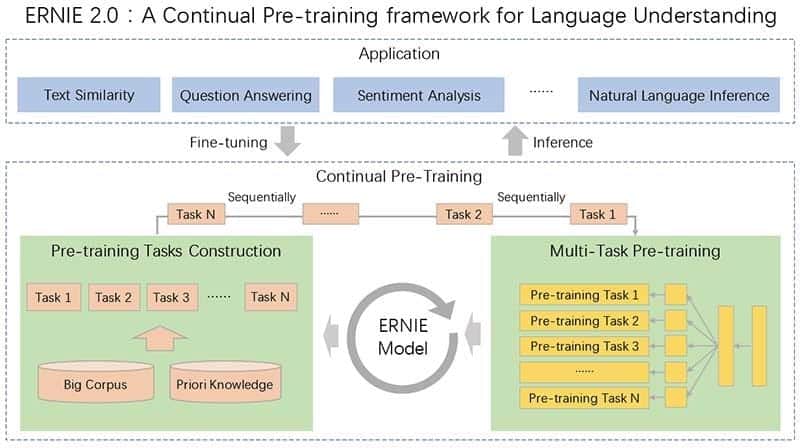

大多數最先進的自然語言處理模型分析了預訓練中句子中單詞的共現。但是,句子中包含的附加信息包括句子順序和接近度,命名實體和語義相似性,模型沒有捕獲。在百度研究者(通過創建一個連續預訓練框架ERNIE 2.0解決此問題Ë nhanced ř epresentation至K Ñ owledge 我 nt下ëgration),通過多任務學習不斷引入和培訓定製任務。因此,該模型可以跨任務編碼詞法,句法和語義信息,而不會忘記以前訓練過的參數。ERNIE 2.0在英語GLUE基準測試中優於BERT和XLNet,為中文處理設定了新的技術水平。

本文的核心思想是什麼?

- 現有的自然語言處理模型主要通過利用單詞或句子的共現信息來解決單詞級和句級推理任務,而不能掌握訓練語料庫中包含的其他有價值的信息。

- 為了充分學習文本中包含的詞彙,句法和語義信息,百度研究團隊引入了一個連續的預訓練框架ERNIE 2.0,其中通過多任務學習逐步引入和學習預訓練任務:

- 可以隨時自由引入不同的自定義任務。

- 這些任務共享相同的編碼網絡,並通過多任務學習進行培訓。

- 當新任務到達時,框架遞增地訓練分布式表示而不忘記先前訓練的參數。

什麼是關鍵成就?

- 根據論文中報道的實驗,ERNIE 2.0在英語GLUE基準測試中優於BERT和XLNet:

- 與BERT的得分80.5相比,平均得分為83.6。

- 在八個單獨的任務類別中的七個中,它比XLNet表現更好。

- ERNIE 2.0還為眾多中國NLP任務設定了最先進的性能水平。

AI社區的想法是什麼?

- ERNIE 2.0是關於GitHub的熱門論文。

未來的研究領域是什麼?

- 在持續的預訓練框架中引入更多和更多樣化的預訓練任務,以進一步提高模型的性能。

什麼是可能的商業應用?

- 與其他大型預訓練語言框架一樣,ERNIE 2.0可以幫助企業完成各種NLP任務,包括聊天機器人,情緒分析,信息檢索等。

你在哪裡可以得到實現代碼?

- 本研究中使用的源代碼和預訓練模型可 在GitHub上獲得。

3. ROBERTA:一種穩健優化的BERT預訓練方法,由YINHAN LIU,MYLE OTT,NAMAN GOYAL,杜景飛,MANDAR JOSHI,DANQI CHEN,OMER LEVY,MIKE LEWIS,LUKE ZETTLEMOYER,VESELIN STOYANOV

原始摘要

語言模型預訓練帶來了顯着的性能提升,但不同方法之間的仔細比較具有挑戰性。培訓計算成本很高,通常在不同大小的私有數據集上完成,正如我們將要展示的,超參數選擇對最終結果有重大影響。我們提出了BERT預訓練的複製研究(Devlin等,2019),該研究仔細測量了許多關鍵超參數和訓練數據大小的影響。我們發現BERT顯着不足,並且可以匹配或超過其後發布的每個模型的性能。我們最好的模型在GLUE,RACE和SQuAD上實現了最先進的結果。這些結果突出了之前被忽視的設計選擇的重要性,並提出了有關最近報告的改進的來源的問題。我們發布我們的模型和代碼。

我們的總結

由於引入了預訓練方法,自然語言處理模型取得了顯着進步,但是訓練的計算費用使得複製和微調參數變得困難。在這項研究中,Facebook AI和華盛頓大學的研究人員分析了谷歌的變換器雙向編碼器表示(BERT)模型的培訓,並確定了培訓程序的幾個變化,以提高其性能。具體而言,研究人員使用新的更大的數據集進行訓練,在更多迭代中訓練模型,並刪除了下一個序列預測訓練目標。由此產生的優化模型RoBERTa(穩健優化的BERT方法)與GLUE基準上最近推出的XLNet模型的得分相匹配。

本文的核心思想是什麼?

- Facebook人工智能研究團隊發現BERT非常重要,並建議改進其訓練方法,稱為RoBERTa:

- 更多數據:160GB的文本,而不是最初用於訓練BERT的16GB數據集。

- 更長的培訓:將迭代次數從100K增加到300K再增加到500K。

- 較大的批次:原始BERT基礎模型中的8K而不是256。

- 具有50K子字單元的較大字節級BPE詞彙表,而不是大小為30K的字符級BPE詞彙表。

- 從訓練過程中刪除下一個序列預測目標。

- 動態地改變應用於訓練數據的掩蔽模式。

什麼是關鍵成就?

- RoBERTa在通用語言理解評估(GLUE)基準測試的所有單個任務中優於BERT。

- 新模型與GLUE基準測試中最近推出的XLNet模型相匹配,並在九個單獨任務中的四個中設置了最新的技術水平。

未來的研究領域是什麼?

- 結合更複雜的多任務微調程序。

什麼是可能的商業應用?

- 像RoBERTa這樣的大型預訓練語言框架可以在業務環境中用於各種下游任務,包括對話系統,問答,文檔分類等。

你在哪裡可以得到實現代碼?

- 本研究中使用的模型和代碼可 在GitHub上獲得。

本文轉自TOPBOTS,原文地址

Comments