雖然卷積神經網絡(CNN)和遞歸神經網絡(RNN)因其在計算機視覺(CV)和自然語言處理(NLP)中的應用而變得越來越重要,而強化學習(RL)作為計算神經科學的框架模型決策過程似乎被低估了。此外,似乎很少有資源詳細說明RL如何應用於不同的行業。儘管對RL的弱點提出了批評,但鑒於其在協助決策方面的巨大潛力,RL在企業研究領域絕不應該被忽視。正如Deepmind的研究主管Koray Kavukcuoglu在一次會議上所說的那樣,“如果我們在這裡工作的目標之一是人工智能,那麼它就是核心。強化學習是學習順序決策任務的一個非常通用的框架。另一方面,深度學習當然是我們必須學習表示的最佳算法集。到目前為止,這兩種不同模型的組合是最好的答案,我們在學習非常好的狀態表示方面非常具有挑戰性的任務,這些任務不僅僅是解決玩具領域,而且實際上是解決具有挑戰性的現實世界問題。“

因此,本文旨在1)研究現實世界中RL應用的廣度和深度; 2)從不同方面看RL; 3)說服決策者和研究人員加大研究力度。

本文的其餘部分組織如下。第一節是一般性介紹。第二節介紹了RL在不同領域的應用,以及如何應用RL的簡要說明。第三節總結了應用RL所需要的東西。第四部分是來自其他學科的直覺,第五部分是關於RL如何在將來有用。第六節是結論。

強化學習簡介

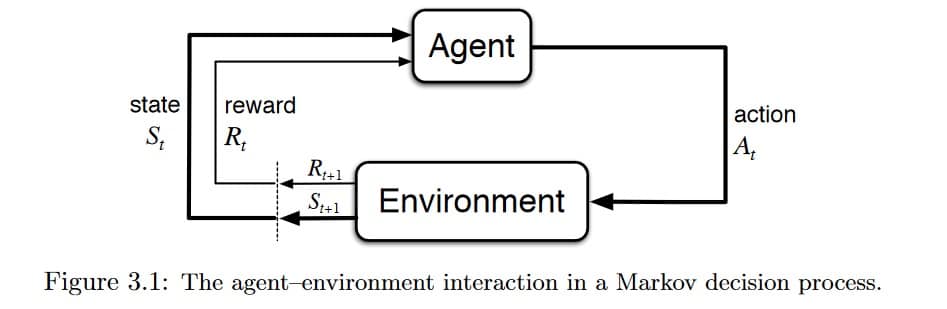

RL,被稱為機器學習中的半監督學習模型,是一種允許代理採取行動並與環境交互以最大化總獎勵的技術。RL通常被建模為馬爾可夫決策過程(MDP)。

想象一下,在您的家中(環境)為嬰兒提供電視遙控器。簡單來說,嬰兒(代理人)將首先觀察並構建他/她自己的環境(狀態)表示。然後好奇的寶寶將採取某些行動,如擊中遙控器(動作)並觀察電視如何響應(下一個狀態)。由於沒有回應的電視很乏味,寶寶不喜歡它(接受負面獎勵)並且會採取較少的行動來導致這樣的結果(更新政策),反之亦然。嬰兒將重複該過程,直到他/她找到他/她滿意的政策(在不同情況下該做什麼)(最大化(打折)總獎勵)。

RL的研究是建立一個解決問題的數學框架。例如,為了找到一個好的策略,我們可以使用基於價值的方法(如Q-learning)來衡量一個特定狀態下的行為有多好,或者使用基於策略的方法來直接找出在不同狀態下要採取的行動,而不知道有多好行動是。

然而,我們在現實世界中面臨的問題可能以許多不同的方式極其複雜,因此典型的RL算法無法解決。例如,在GO的遊戲中,狀態空間非常大,在撲克遊戲中無法完全觀察到環境,並且在現實世界中有許多代理彼此交互。研究人員發明了通過使用深度神經網絡來模擬所需策略,價值函數甚至過渡模型來解決一些問題的方法,因此稱為深度強化學習。本文不區分RL和Deep RL。

有很多關於RL在線和有興趣的讀者可以訪問好東西的真棒-RL,argmin和dennybritz。

強化學習的應用

本部分是為一般讀者編寫的。同時,對於具有RL知識的讀者來說,它將具有更大的價值。

計算機集群中的資源管理

設計用於將有限資源分配給不同任務的算法具有挑戰性,並且需要人工生成的啟發式算法。文章“深度強化學習的資源管理” [2]展示了如何使用RL自動學習分配和安排計算機資源到等待工作,目的是最小化平均工作減速。

國家空間被制定為當前的資源分配和就業資源概況。對於動作空間,他們使用技巧允許代理在每個時間步驟選擇多個動作。獎勵是系統中所有作業的(-1 /作業持續時間)的總和。然後,他們將REINFORCE算法和基線值結合起來計算政策梯度,並找到最佳政策參數,這些參數給出了最小化目標的行動概率分布。單擊此處查看Github上的代碼。

交通燈控制

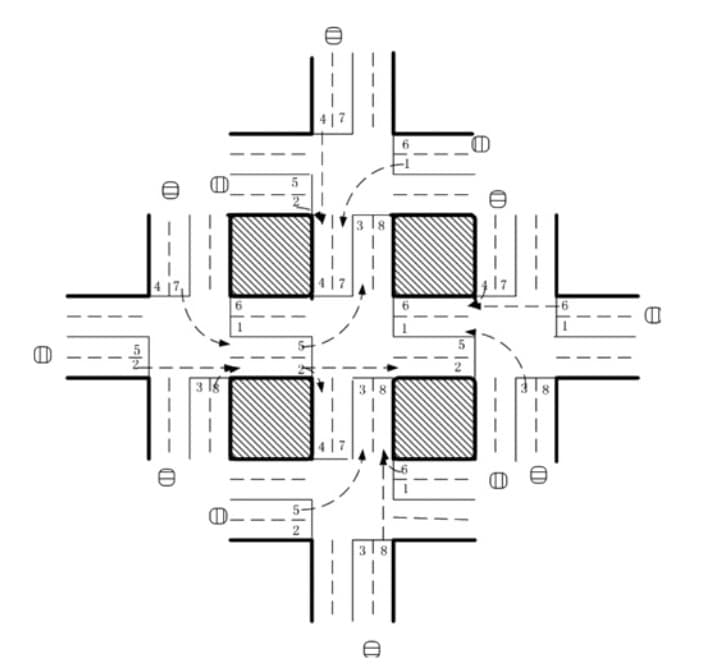

在論文“基於強化學習的網絡交通信號控制多智能體系統” [3]中,研究人員試圖設計一種交通燈控制器來解決擁堵問題。雖然僅在模擬環境中進行了測試,但它們的方法比傳統方法顯示出更好的結果,並闡明了多智能體RL在設計交通系統中的潛在用途。

在五個交叉口的交通網絡中放置了五個代理,在中央交叉口有一個RL代理來控制交通信號。該狀態被定義為八維向量,每個元素代表每個通道的相對交通流量。代理可以使用八種選擇,每種選擇代表相位組合,並且獎勵函數被定義為與先前時間步長相比的延遲減少。作者使用DQN來學習{state,action}對的Q值。

機器人

在機器人技術中應用RL有很多工作要做。有關機器人技術中RL的調查,讀者可參考[10]。特別是,[11]訓練機器人學習將原始視頻圖像映射到機器人動作的策略。RGB圖像被饋送到CNN並且輸出是電機轉矩。RL組件是引導策略搜索,用於生成來自其自身狀態分布的訓練數據。

Web系統配置

Web系統中有超過100個可配置參數,調整參數的過程需要熟練的操作員和大量的跟蹤和錯誤測試。文章“在線Web系統自動配置的強化學習方法” [5]展示了該領域中第一次嘗試如何在基於VM的動態環境中對多層Web系統中的參數進行自動重新配置。

重新配置過程可以表示為有限MDP。狀態空間是系統配置,每個參數的動作空間是{增加,減少,保持},獎勵被定義為給定的目標響應時間和測量的響應時間之間的差異。作者使用無模型Q學習算法來完成任務。

儘管作者使用了一些其他技術,如策略初始化來彌補問題的大狀態空間和計算複雜性,而不是RL和神經網絡的潛在組合,但相信這一開創性工作為該領域的未來研究鋪平了道路。 。

化學

RL也可用於優化化學反應。[4]表明他們的模型優於最先進的算法,並在“利用深度強化學習優化化學反應”一文中推廣到不同的潛在機制。

結合LSTM對政策函數進行建模,RL代理使用以{S,A,P,R}為特徵的馬爾可夫決策過程(MDP)優化化學反應,其中S是一組實驗條件(如溫度,pH,等等,A是設置所有可能改變實驗條件的動作,P是從當前實驗條件到下一個條件的轉移概率,R是作為狀態函數的獎勵。

該應用程序非常適合演示RL如何在相對穩定的環境中減少耗時和反覆試驗的工作。

個性化建議

以前的新聞推薦工作面臨著一些挑戰,包括新聞動態的快速變化,用戶容易感到厭倦,點擊率不能反映用戶的保留率。關傑等。已經在新聞推薦系統中將RL應用於題為“DRN:新增推薦的深度強化學習框架”的論文中,以解決這些問題[1]。

在實踐中,他們構建了四類特徵,即A)用戶特徵和B)上下文特徵作為環境的狀態特徵,以及C)用戶新聞特徵和D)新聞特徵作為動作特徵。將四個特徵輸入到深度Q網絡(DQN)以計算Q值。根據Q值選擇推薦新聞列表,用戶點擊新聞是RL代理收到的獎勵的一部分。

作者還採用其他技術來解決其他具有挑戰性的問題,包括記憶重放,生存模型,決鬥強盜梯度下降等。請參閱論文了解詳情。

招標和廣告

阿里巴巴集團的研究人員發表了一篇論文“在展示廣告中實現多代理強化學習的實時招標” [6]並聲稱他們的基於分布式集群的多智能體代理解決方案(DCMAB)取得了很好的成果,因此他們計划進行在淘寶平台上進行現場測試。

實施細節留待用戶調查。一般來說,淘寶廣告平台是商家出價以便向顧客展示廣告的地方。這可能是一個多代理問題,因為商家互相競價,他們的行為是相互關聯的。在本文中,商家和客戶被聚集到不同的組中以降低計算複雜性。代理商的狀態空間表示代理商的成本收入狀態,行動空間是投標(連續),獎勵是客戶集群造成的收入。

其他問題,包括不同獎勵設置(自利與協調)對代理商收入的影響,也在本文中進行了研究。

遊戲

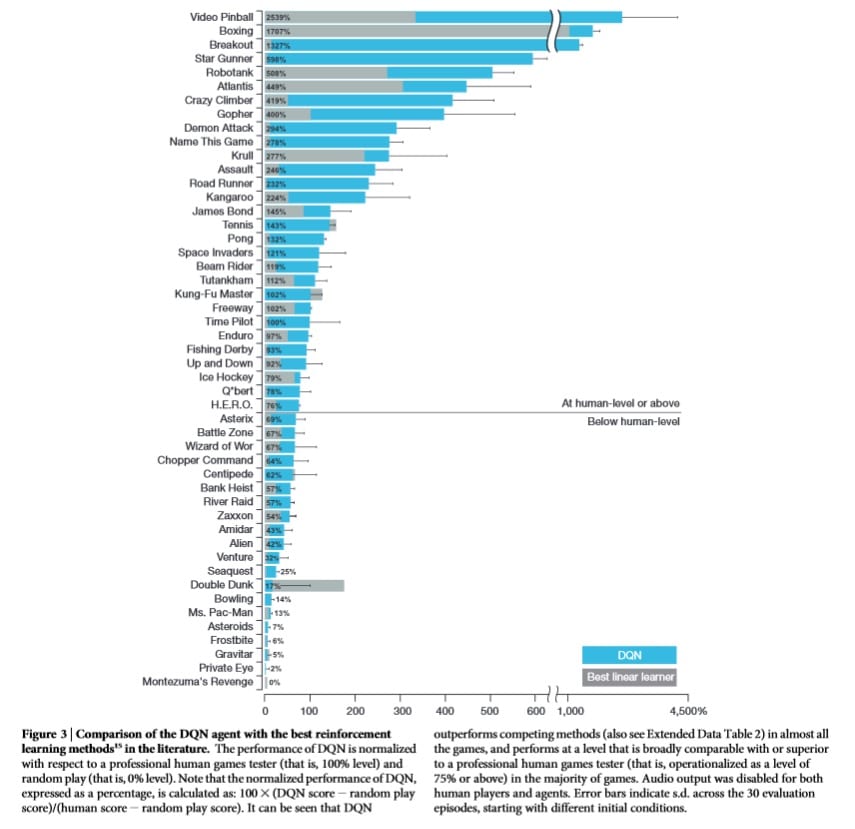

RL現在如此知名,因為它是用於解決不同遊戲並有時實現超人類表現的主流算法。

最着名的一個必須是AlphaGo [12]和AlphaGo Zero [13]。AlphaGo受到無數人類遊戲的訓練,通過在其政策網絡中使用價值網絡和蒙特卡羅樹搜索(MCTS),已經實現了超人類的表現。然而,研究人員後來回想起並嘗試了一種更純粹的RL方法 – 從頭開始訓練它。研究人員讓新的代理商AlphaGo Zero與自己一起玩,最終以100-0擊敗AlphaGo。

深度學習

最近可以看到越來越多的嘗試結合RL和其他深度學習架構,它們顯示出令人印象深刻的結果。

RL中最有影響力的工作之一是Deepmind將CNN與RL相結合的開創性工作[7]。通過這樣做,代理人能夠通過高維感覺“看到”環境,然後學習與之交互。

RL和RNN是人們用來嘗試新想法的另一種組合。RNN是一種具有“記憶”的神經網絡。當與RL結合使用時,RNN賦予代理記憶事物的能力。例如,[8]將LSTM與RL結合起來創建深度循環Q網絡(DRQN)以播放Atari 2600遊戲。[4]也使用RNN和RL來解決化學反應優化問題。

Deepmind展示了[9]如何使用生成模型和RL來生成程序。在模型中,受過對側訓練的代理使用信號作為獎勵來改善動作,而不是像在GAN訓練中那樣將梯度傳播到輸入空間。

在將RL應用於您的問題之前您需要了解的內容

在應用RL之前需要做幾件事:

- 理解你的問題:你不一定需要在你的問題中使用RL,有時你也不能使用RL。在決定使用RL之前,您可能想要檢查您的問題是否具有以下某些特徵:a)反覆試驗(可以通過接收來自環境的反饋來學習如何做得更好); b)延遲獎勵; c)可以建模為MDP; d)你的問題是一個控制問題。

- 模擬環境:在RL算法工作之前需要大量迭代。我相信你不希望看到RL代理人在高速公路上的自動駕駛汽車中嘗試不同的事情,對吧?因此,需要能夠正確反映現實世界的模擬環境。

- MDP:您的世界需要將您的問題制定為MDP。你需要設計狀態空間,動作空間,獎勵功能等。您的代理人將在限制條件下完成獎勵。如果您以不同的方式設計內容,則可能無法獲得所需的結果。

- 算法:您可以選擇不同的RL算法和問題。您想直接找出政策還是想學習價值功能?您想要無模型還是基於模型?您是否需要結合其他類型的深層神經網絡或方法來解決您的問題?

為了保持客觀公正,你也會被告知RL的缺點,這裡有一篇很棒的帖子。

來自其他學科的直覺

RL與心理學,生物學和神經科學有着非常密切的關係。如果你考慮一下,RL代理所做的只是反覆試驗:它根據從環境中獲得的回報來了解它的行為有多好或多壞。這正是人類學會做出決定的方式。此外,探索和開發問題,信用分配問題,環境建模嘗試也是我們日常生活中所面臨的問題。

經濟學理論也可以闡明RL。特別是,可以從博弈論的角度理解多智能體強化學習(MARL)的分析,博弈論是約翰納什開發的一個研究領域,用於理解系統中代理人的相互作用。除了博弈論,MARL,部分可觀察馬爾可夫決策過程(POMDP)也可用於理解其他經濟主題,如市場結構(例如壟斷,寡頭壟斷等),外部性和信息不對稱。

強化學習可能在未來實現什麼

RL仍有很多問題,不能輕易使用。然而,只要更多努力解決問題,RL將在以下方面具有影響力和影響力:

- 協助人類:也許說RL有朝一日可以演變成人工智能(AGI)太過分了,但RL肯定有可能協助和與人合作。想象一下機器人或虛擬助手與您一起工作並將您的行動納入考慮範圍,以便採取行動以實現共同目標。不是很棒嗎?

- 了解不同策略的後果:生活是如此驚人,因為時間不會回歸,事情只會發生一次。然而,如果我採取不同的行動,有時候我們想知道事情會有什麼不同(至少在短期內)?或者,如果教練採用另一種策略,克羅地亞是否有更大的機會贏得2018年世界盃?當然,要實現這一目標,我們需要對環境,轉換函數等進行完美建模,並分析代理之間的交互,這在目前似乎是不可能的。

結論

本文僅展示了各行業中強化學習應用的一些示例。它們不應該限制您的RL用例,並且一如既往,您應該使用第一原則來理解RL的性質和您的問題。

如果您是公司的決策者,我希望這篇文章足以說服您重新思考您的業務,看看是否可以使用RL。如果你是一名研究員,我希望你會同意我的看法,雖然RL仍然有不同的缺點,但這也意味着它有很大的潛力可以改善,並有很多研究機會。

你的想法是什麼?你能想到RL可以解決的任何問題嗎?

Comments