從神經科學的角度來看,嘗試閱讀本文是一項複雜的任務。目前,您可能受到電子郵件,新聞,我們手機上的通知的轟炸,平時煩人的同事打擾以及其他使您的大腦向多個方向旋轉的干擾。為了閱讀這篇小文章或執行許多其他認知任務,您需要集中精力,需要關注。

注意是一種認知技能,對知識的形成至關重要。然而,數百年來,注意力的動態一直是神經科學家們的一個謎,而就在最近,我們已經取得了重大突破,有助於解釋注意力的工作原理。在深度學習程序的背景下,建立注意力動態似乎是顯而易見的一步,以提高模型的知識並使模型適應不同的場景。將注意力機制構建到深度學習系統中是一個非常活躍的新興研究領域。幾個月前,Google Brain小組的研究人員發表了一篇論文,詳細介紹了可用於模擬深度神經網絡中注意力的一些關鍵模型。

注意如何工作?

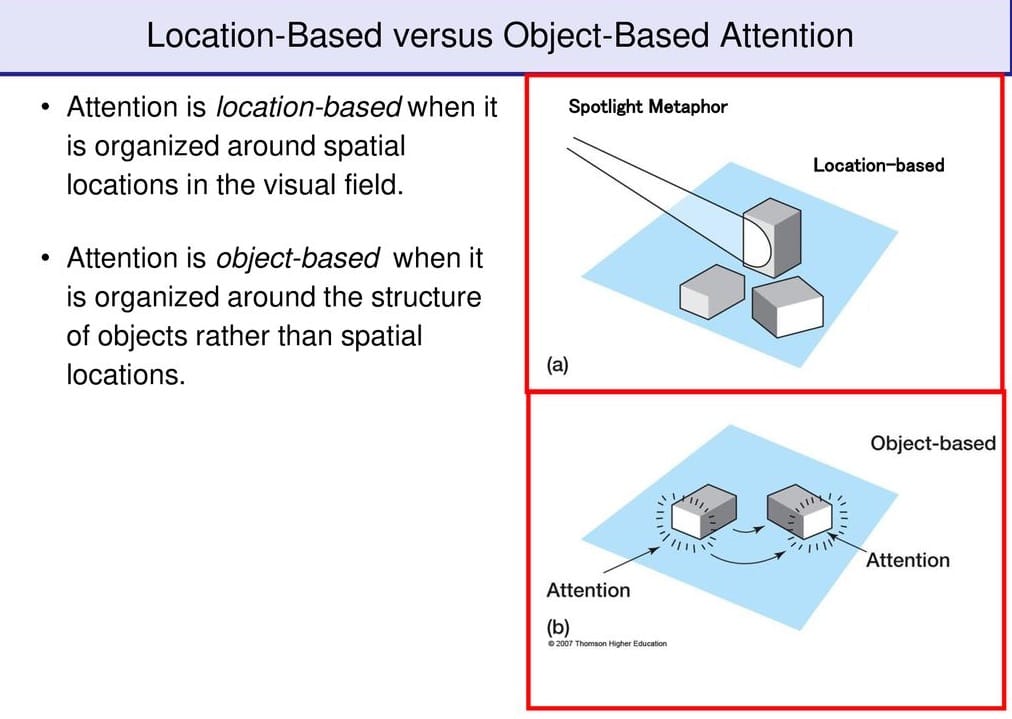

為了理解深度學習系統中的注意力,研究一下這種認知現象在人腦中是如何發生的可能是有用的。從神經科學的角度來看,注意力是大腦選擇性地專註於環境的一方面而忽略其他事物的能力。當前的研究確定了兩種主要的注意力類型,它們都與大腦的不同區域有關。基於對象的注意力通常是指大腦專註於特定對象的能力,例如本文中某個部分的圖片。基於空間的注意力主要與對特定位置的關注有關。兩種注意力都與深度學習模型相關。儘管基於對象的注意力可以用於諸如圖像識別或機器翻譯之類的系統中,但空間注意力與諸如自動駕駛汽車之類的深度強化學習場景相關。

深度神經網絡中的注意界面

當涉及深度學習系統時,為了模擬不同類型的注意力,已經創建了不同的技術。Google的研究論文集中在與循環神經網絡(RNN)相關的四個基本模型上。為什麼要使用RNN?好吧,RNN是一種網絡,主要用於處理順序數據並獲得更高級的知識。結果,RNN通常被用作改進其他神經網絡模型(例如卷積神經網絡(CNN)或生成接口)的工作的第二步。在RNN中建立注意力機制可以幫助提高對不同深度神經模型的了解。Google Brain小組確定了以下四種將注意力吸引到RNN模型中的技術:

· 神經圖靈機:最簡單的注意力接口,神經圖靈機(非關稅措施)添加的存儲器的結構與傳統RNNs。使用內存結構可以使ATM指定“注意力分布”部分,該部分描述模型應關注的區域。去年,我發布了NTM概述,探討了其一些基本概念。NTM的實現可以在許多流行的深度學習框架中找到,例如TensorFlow和Theano。

· 注意接口:注意接口使用RNN模型來關注另一個神經網絡的特定部分。可以在使用CNN-RNN雙工的圖像識別模型中找到該技術的經典示例。在這種體系結構中,RNN將專註於CNN生成的圖像的特定部分,以對其進行改進並提高知識的質量。

· 自適應計算時間:這是一種嶄新的技術,允許RNN在每個時間步長執行多個計算步驟。這與注意力有什麼關係?很簡單,標準RNN在每個步驟中執行相同的計算量。自適應計算時間技術使用注意力分布模型來確定每次運行的步驟數,從而可以將更多的重點放在模型的特定部分上。

· 神經編程器:神經編程器是深度學習領域一個引人入勝的新領域,專註於學習創建程序以解決特定任務。實際上,它學會了生成此類程序而無需正確程序的示例。它發現了如何生成程序作為完成某些任務的一種手段。從概念上講,神經程序員技術試圖彌合神經網絡與傳統編程技術之間的鴻溝,而傳統編程技術可用於開發深度學習模型中的注意力機制。

注意是人腦最複雜的認知能力之一。在神經網絡中模擬注意力機制可以為深度學習的未來打開新的令人着迷的可能性。

本文轉自towardsdatascience,原文地址

Comments