本文转载自公众号 人工智能学家,原文地址

我准备写一篇预测未来一年的AI芯片,以及英伟达如何应对挑战的文章,但我很快意识到,文章要比我预期的要长得多。由于有很多内容要介绍,我决定把文章分为3个部分。

第1部分:简介,以及分析想要挑战英伟达的大公司:英特尔、AMD、谷歌、赛灵思、苹果、高通。

第2部分:创业公司与中国公司,以及他们可能扮演的角色。第3部分:英伟达抵御潜在竞争对手的策略。

第3部分:英伟达抵御潜在竞争对手的策略。

1、简介

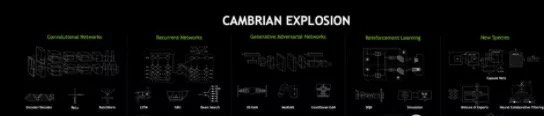

在过去五年中,英伟达将其数据中心业务发展成为一个价值数十亿美元的巨头,却从未遇到过一个像样的竞争对手。这是一个惊人的事实,在我的记忆中,这在当今的科技世界是无与伦比的。这种快速增长的动力主要来自对人工智能(AI)和高性能计算(HPC)的快速GPU芯片的需求。英伟达首席执行官Jensen Huang喜欢谈论深度学习领域的“寒武纪大爆发”,特别指的是神经网络算法创新的快速步伐。我们将在第3部分中讨论这对英伟达的意义,但我选择借用这个概念作为本系列的标题。我们正处于全球许多大型和小型公司的专业AI芯片爆发的门口。三年前,芯片初创企业几乎不可能获得风险投资。而现在,有数十家资金充足的挑战者在为人工智能构建芯片。

去年,英伟达和IBM 达到了计算的顶峰,他们宣布为世界上最快的超级计算机——美国能源部橡树岭国家实验室(ORNL)的Summit超级计算机(约95%的性能归功于英伟达的Volta GPU)提供动力。尽管这是一项令人难以置信的成就,但许多人开始怀疑,对于英伟达来说,整个童话故事能否持续下去。

根据最新的季度报告,英伟达数据中心收入同比增长58%至7.92亿美元,占公司总收入的近25%。在过去4个季度中,这一数字总计为28.6亿美元。如果该公司能保持这种增长,到2019年,数据中心的收入将达到45亿美元。这听起来像天堂,或者至少是地球上的天堂,对吧?

毫无疑问,英伟达在其强大的可扩展架构愿景的推动下,打造出了卓越的产品。英伟达现在拥有一个由软件、大学、初创企业和合作伙伴组成的强大和自我维持的生态系统,这些伙伴使它成为自己创建的新世界的主人。虽然有些人会认为,这一生态系统创造了一条不可逾越的护城河,但乌云现在正出现在地平线上。潜在的威胁来自英特尔、谷歌、AMD以及数十家美国和中国的初创企业,它们都被炙手可热的人工智能所吸引。

到目前为止,在我看来,竞争主要是小打小闹。竞争对手已经发布了几十项声明,但我非常确信,除了谷歌之外,没有一家公司实际上从英伟达的金库中获得了任何收入。让我们看看目前的竞争格局,看看2019年将会是什么样子。

大型挑战者

尽管统计有40多家初创公司进入了这一领域,但让我们现实一点:只有少数公司才能真正在这个市场上取得成功(比如收入超过10亿美元)。在深度神经网络的训练方面,考虑到英伟达的产品、安装基础和无处不在的生态系统的强大,英伟达很难被击败。然而,目前规模相当小的推理市场最终将超过训练市场的总收入。与训练不同,推理不是单一的市场。它由云端和边缘的大量数据类型和相关的优化深度学习算法组成,每种算法都具有特定的性能、功耗和延迟要求。此外,在推理市场中没有巨无霸,即使在英伟达声称拥有领导地位的汽车市场也是如此。由于这些原因,推理是大多数新进入者主要或最先关注的领域。让我们看看那些正在争夺席位的大公司。

谷歌

最早证明专用芯片(称为ASIC,或特定于应用的集成电路)可以对抗更可编程、更通用的用于深度学习的GPU的公司之一是谷歌。巧合的是,谷歌可能是英伟达最大的客户之一。正如我之前所述,谷歌现在已经发布了四款“Tensor Processing Units”(TPU),这些芯片和电路板可以加速云中的深度学习训练和推理处理,最近还用于边缘云。谷歌的TPU用于训练和处理深度神经网络的性能相当可靠,每块芯片每秒可提供多达45万亿次操作(TOPS)。相比之下,英伟达的Volta最高可达125 TOPS。谷歌最初的两个TPU实际上是供内部使用和吹嘘的,但Google现在将它们作为一种服务提供给其在Google Compute Cloud上的云客户。

尽管TPU无疑对谷歌的人工智能举措起到了推动作用,但它们服务于谷歌内部使用案例(当然,这是一个相当大的市场)之外的市场却是有意受到限制的。TPU只能用于训练和运行谷歌TensorFlow AI框架; 你不能用它来训练或运行用Apache MxNet或PyTorch构建的AI(这两个是Facebook和微软支持的快速增长的AI框架)。它们也不能用于GPU占主导地位的非AI HPC应用。此外,你不能购买TPU用于企业或政府数据中心和服务器中的内部计算。但谷歌并不介意这一切,因为它认为TPU和TensorFlow对其人工智能的整体领导地位具有战略意义。针对硬件进行优化的软件和针对软件进行优化的硬件可以构建强大而持久的平台。

TPU的更直接的影响可能是验证ASIC概念可以作为GPU的替代方案,至少对潜在的投资者来说是这样。一家深度学习芯片初创公司的首席执行官和我分享了这样的经历:在谷歌宣布其TPU之后,风险资本开始自由流动。他随后筹集到了数亿美元。

谷歌一直善于从英伟达在GPU技术大会(通常是在3月份)上发布的可预测的声明中抢得一些风头,我不会惊讶于看到谷歌今年再次亮相,或许会带来一款性能数据引人注目的7纳米TPU产品。

亚马逊网络服务公司(Amazon Web Services)也不甘落后,公司去年秋天宣布,它也正在构建一个用于推理处理的定制ASIC。然而,该芯片仍在开发中,公司没有分享任何有关设计或可用性的细节。

英特尔

这变得有点复杂了,因为英特尔是大公司,同时在做很多工作,虽然英特尔打算在“2019年末”与Nervana芯片竞争人工智能训练和推理,但它意识到,推理将成为一个更大的市场,并有非常强大的影响力。除了Xeon CPU(最近更新后,推理性能得到显着提升)之外,英特尔还收购了MobileEye和Movidius,分别用于汽车和嵌入式推理处理。我看过这两种设备的演示,它们确实令人印象深刻。英特尔还投资了一个名为DB2OpenVino的Run-Anywhere软件栈,它允许开发人员在任何地方进行训练,然后在一切英特尔处理器上进行优化和运行,非常令人惊艳。

在拉斯维加斯举行的CES会议上,英特尔透露,它正在与Facebook就Nervana神经网络处理器(NNP-I)的推理版本密切合作,这令人惊讶,因为许多人预测Facebook正在开发自己的推理加速器。

与此同时,英特尔副总裁兼人工智能产品总经理Naveen Rao在Twitter上分享说,NNP-I将是一个SOC(片上系统),在英特尔10纳米晶圆厂制造,并将包括IceLake x86核心。Rao表示,这将是英特尔未来的一个共同主题,可能是指未来用于台式机和笔记本电脑的X86/GPU芯片,类似于AMD的APU。

在训练方面,英特尔最初的计划是在收购Nervana一年后的2017年发布一款名为“Lake Crest”Nervana NNP的产品。然后它拖到了2018年……最终,公司决定重新开始。这不太可能是因为Nervana完成的第一部分不好,相反,英特尔意识到,该器件的性能不足以大幅超过英伟达和它添加到Volta和后续GPU中的TensorCores。我想,当英伟达公布它在7nm工艺上制造的任何令人惊艳的新产品时,我们将再次看到相同剧本的上演,但这有些想太远了。

高通和苹果

为了完整起见,我将这两家公司包括在内,因为它们都专注于在手机(以及高通的物联网设备和自动驾驶汽车)上提供令人印象深刻的人工智能能力。当然,苹果专注于iPhone的A系列CPU和支持手机AI的IOS操作系统。随着手机成为语音和图像处理领域的人工智能推理的主导平台,这两家公司拥有大量可以用来确立领导地位的IP(尽管华为也在大力推动人工智能,我们将在第2部分介绍)。

AMD

在过去的三年里,AMD一直在努力让它的AI的软件工作室正常运转。我2015年在那里工作时,如果不启动Windows,你甚至不能在Linux服务器上运行它的GPU。从那时起,公司已经取得了长足的进步,ROCm软件和编译器简化了从CUDA的迁移,MlOpen(不要与OpenML混淆)加速了芯片上的数学库。然而,目前AMD的GPU仍然至少比英伟达V100的AI版本落后一代,而且V100已经接近两年的历史了。AMD如何在7 nm上与英伟达 TensorCores竞争仍有待观察。

赛灵思

毫无疑问,可编程逻辑器件(FPGA)的领先供应商赛灵思在2018年的表现非常出色。除了宣布7nm的下一代架构外,它还在微软、百度、亚马逊、阿里巴巴、戴姆勒奔驰等公司的设计中取得了重大胜利。在人工智能推理处理中,FPGA比ASIC有明显的优势,因为它们可以为手头的特定工作动态地重新配置。当底层技术正在快速变化时,这一点非常重要,就像人工智能的情况一样。例如,微软展示了它的FPGA(现在来自赛灵思和英特尔)如何在深度神经网络中对特定层使用1位、3位或几乎任何精度的数学计算。这可能就像呆子一样,但这可以大大加快处理速度并减少延迟,同时使用更少的功率。此外,即将推出的赛灵思7nm芯片称为Versal,它具有AI和DSP引擎,可加速特定应用程序的处理,同时具有可适配的逻辑阵列。Versal将在今年的某个时候开始发货,我认为它可能会改变推理处理的游戏规则。

2、初创公司

这是关于人工智能芯片市场状况,以及2019年将会发生什么的三篇文章中的第二篇。今年将是新芯片和基准之战的盛宴,领头的是我在第一篇博客中提到的大公司(英特尔、谷歌、AMD、赛灵思、苹果、高通),此外,还有数十家硅谷初创公司和中国独角兽的估值超过10亿美元。在这一节中,我将介绍西方和中国最著名的初创公司,或者至少是呼声最高的初创公司,中国政府正致力于打造本土的人工智能芯片产业。我们将从Wave开始,它似乎是第一个将芯片用于训练的公司。

Wave Computing

Wave Computing经历了一个多事的2018年,它推出了第一个数据流处理单元,收购了MIPS,创建了MIPS Open,并将它的第一个早期系统交付给了一些幸运的客户。虽然Wave架构有一些非常有趣的特性,我将在这里深入探讨,但是我们正在等待大规模实际工作负载的客户体验信息。

Wave不是连接到服务器的加速器;它是用于图形计算的独立处理器。这种方法有优点也有缺点。从好的方面来说,Wave不会受到GPU等加速器中存在的内存瓶颈的影响。从消极的方面来看,安装Wave设备将是一次叉车式升级,需要完全替换传统的X86服务器,并且会成为所有服务器制造商的竞争对手。

我不期待Wave在单个节点上提供优于英伟达的结果,但是它的架构设计得很好,而且公司已经表示,它应该很快就能得到客户的结果。请继续关注!

图1:Wave出货的系统是根据从上图展示的4节点“DPU”板构建的。

Graphcore

Graphcore是一家资金雄厚(投资3.1亿美元,目前估值为17亿美元)的英国独角兽创业公司,拥有世界一流的团队。它正在构建一种新颖的图形处理器架构,其内存与其逻辑位于同一芯片上,这将使实际应用具有更高的性能。这个团队在很长一段时间里一直在挑逗它将要发布的新产品。去年4月,它“几乎准备好上市”,而该公司去年12月的最新信息表明,它将很快开始生产。它的投资者名单颇为引人注目,其中包括红杉资本、宝马、微软、博世和戴尔科技。

我已经了解了Graphcore的架构,它看起来相当引人注目,从边缘器件扩展到用于数据中心的训练和推理的“Colossus”双芯片封装。在最近的NeurIPS活动上,Graphcore展示了它的RackScale IPU Pod,它在一个有32个服务器的机架上提供了超过16 petaflp的性能。虽然Graphcore经常声称它的性能将是同类最佳GPU的100倍以上,但我的计算结果与此不同。

Graphcore表示,一个4“Colossus”GC2(8芯片)服务器提供500 TFlops(每秒万亿次运算)的混合精度性能。单个英伟达V100可提供125 TFlops,因此从理论上讲,4个V100应提供相同的性能。与往常一样,问题在于细节,只有对代码进行重构以执行TensorCore执行的4×4矩阵乘法时,V100峰值性能才可用,Graphcore架构巧妙地避免了这一限制。更不用说V100价格昂贵,且耗电量高达300瓦。此外,Graphcore支持片上互连和“处理器内存”(片上存储器)方法,这可能会带来超出TFlops基准测试所暗示的优秀应用性能。在一些神经网络中,如生成性对抗网络(GAN),内存是瓶颈。

再次强调,我们将不得不等待真实的用户用实际应用结果来评估此架构。尽管如此,Graphcore的投资者名单、专家名册和超高的估值告诉我,这可能是一个好东西。

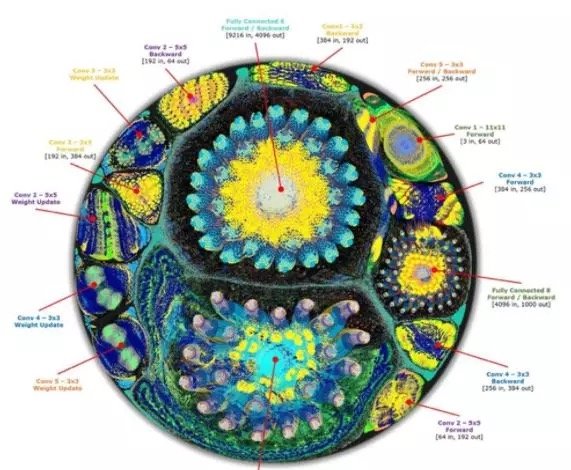

图2:GraphCore展示了处理ImageNet数据集的这张非常酷的图片。这种可视化可以帮助开发人员了解他们的训练处理消耗了处理周期中的哪些部分。

Habana Labs

去年9月,以色列初创公司Habana Labs在第一届人工智能硬件峰会上宣布,它已准备好推出第一款用于推理的芯片,并以创纪录的性能运行卷积神经网络进行图像处理,这令许多人感到意外。结果显示,在Resnet50图像分类数据库中,该处理器每秒分类15,000张图像,比英伟达的T4高出约50%,功耗仅为100瓦。2018年12月,Habana Labs的最新一轮融资由英特尔风险投资(Intel Venture Capital)领投,WRV Capital、Bessemer Venture Partners和Battery Ventures跟投,该公司的融资也由此前的4500万美元增加了7500万美元。最近的资金将部分用于其名为“Gaudi”的第二款芯片的流片,该芯片将专注于训练市场,据称可扩展到1000多个处理器。在这个竞争激烈的领域,Habana Labs表现出很多希望。

其他初创公司

我知道世界上有40多家公司在制造用于人工智能训练和推理的芯片。 我发现大多数公司都在做简单的FMA(浮点乘法累加)和混合精度数学(8位整数,16位和32位浮点数),我对此并不惊讶。这种方法相对容易构建,也会得到一些容易摘到的果实,但与英伟达、英特尔等大公司以及少数几家开发酷炫架构的初创公司(如Wave和GraphCore)相比,这无法提供持久的架构优势。以下是几家引起我注意的公司:

Groq:由从事TPU工作的前Google员工创立,有统治世界的雄心。Tenstorrent:加拿大前AMD员工创立,目前仍处于保密阶段。我只能说其CEO的愿景和架构给我留下了深刻的印象。

ThinCi:印度公司,专注于边缘器件和自动驾驶汽车,与三星和Denso建立了合作伙伴关系。

Cerebras:由包括Andrew Feldman在内的前SeaMicro(AMD子公司)员工领导,目前仍处于深度“隐身”模式。

Mythic:一家采用独特方法进行边缘推理处理的创业公司,类似于非易失性存储器上的模拟处理;应该在2019年推出芯片。

中国公司

中国一直在努力寻找一条摆脱对美国半导体依赖的道路,而人工智能加速器可能提供它一直寻求的出口。中国中央政府制定了2030年建设万亿美元人工智能产业的目标,自2012年以来,投资者已经向初创公司投入了超过40亿美元。美国国会称这是一场人工智能军备竞赛,由于中国企业和研究机构在推动创新方面较少考虑阻碍西方进步的隐私和伦理问题,美国科技行业可能会落后。

Cambricon(寒武纪科技)和SenseTime(商汤科技)可能是最值得关注的中国人工智能公司,但边缘AI领域Horizon Robotics这样的公司值得关注。此外,请密切关注像百度、华为、腾讯和阿里巴巴这样的大型互联网公司,它们都在人工智能软件和硬件方面进行了大量投资。

寒武纪科技是一家估值25亿美元的中国独角兽公司,已经发布了第三代人工智能芯片。该公司声称,在低功耗条件下,它可以比英伟达V100提供大约30%的性能优势。寒武纪科技还向客户销售IP,并为华为麒麟970移动芯片组提供人工智能硬件。

商汤科技或许是估值最高的人工智能初创公司,它最出名的是在中国各地推广智能监控摄像头。这些摄像头的数量超过1.75亿台,其中包括其他公司生产的摄像头。商汤科技在香港成立,最近一轮融资数额达6亿美元,由阿里巴巴领投。据多家媒体报道,这家初创公司目前的估值为45亿美元。商汤科技与阿里巴巴、高通、本田、甚至英伟达等大公司建立了战略合作伙伴关系。该公司现在拥有一台超级计算机,运行大约8000个(可能是英伟达提供的)GPU,并计划再建造5台超级计算机来处理数百万个摄像头采集的面部识别数据。

3、英伟达

既然我已经震惊了所有持有英伟达股票的人,并把希望带给了那些花很多钱购买英伟达GPU的人,那么让我们现实地看看英伟达如何在一个竞争激烈得多的市场中保持其领导地位。我们需要分别研究训练和推理市场。

来自Nervana的历史课

首先,让我们看看英特尔在Nervana方面的经验。在被英特尔收购之前,Nervana声称它的表现将比GPU至少高出10倍。然后,在通往胜利的路上发生了一件有趣的事情:英伟达的TensorCores让每个人都感到惊讶,它强于Pascal不是2倍,而是5倍。接着,英伟达又在NVSwitch上加倍努力,构建出了性能惊人的8 GPU DGX-2服务器(售价40万美元,相当昂贵),击败了大部分(或许全部)竞争对手。与此同时,英伟达的CuDNN库和驱动程序的性能几乎翻了一番。它还构建了GPU云,使得使用GPU就像单击和下载优化的软件堆栈容器一样简单,可以用于大约30个深度学习和科学工作负载。因此,正如我在之前的文章中所分享的那样,英特尔承诺的10倍性能优势消失了,而承诺在2019年末推出一款Nervana新芯片现在不得不回到设计阶段。基本上,英伟达证明了,在一个虚拟车库中,有着坚实履历和技术储备的1万多名工程师可以胜过50名聪明的工程师。任何人都不应该感到惊讶,对吧?

给一万名工程师一个大沙盒

现在,快到三年到2019年。再一次,竞争对手声称他们的芯片有10倍甚至100倍的性能优势,而这一切都还在开发中。英伟达仍拥有一万名工程师队伍,并与全球顶尖的研究人员和终端用户保持着技术合作关系。现在,他们都在为英伟达的下一代7nm芯片献技,在我看来,这基本上将使该公司的产品从“带AI的GPU芯片”转变为“带GPU的AI芯片”。

英伟达工程师需要为公司的下一代产品添加多少额外的逻辑区域?虽然下面的分析很简单,但它可以有效地构建对这个关键问题的答案。

让我们从第一款貌似具有出色性能的ASIC开始,即谷歌TPU。我看到分析说每个谷歌TPU芯片大约是2-2.5B个晶体管。Volta V100在12nm制造工艺中拥有大约21B晶体管。它是台积电可以制造的最大芯片。随着英伟达从12nm迁移到7nm,芯片可以包含大约1.96(1.4×1.4)倍的晶体管。因此,从理论上讲,如果英伟达不添加任何图形逻辑(当然不太可能),它将会有另外200亿个晶体管可以使用,大约是整个Google TPU逻辑量的十倍。假设我的逻辑部分占去2倍。在这种情况下,英伟达工程师仍然有5倍的逻辑可用于新AI功能。现在,所有这一切都假设英伟达将全力追求性能,而不去降低成本或电力。不过,在训练市场上,这正是用户所需要的:缩短训练时间。关于英伟达可能提供什么,有很多想法,包括处理器内存和更多版本的tensorcore。

我的观点是,英伟达毫无疑问拥有足够的专业知识和可用的芯片空间来进行创新,就像它在tensorcore上所做的那样。我和许多有趣的AI芯片初创公司谈过,但我最尊敬的那些公司告诉我,他们没有低估英伟达,也不认为他们被困在GPU的思维模式中。英伟达DLA和Xavier,一个ASIC和一个SOC,分别证明了英伟达可以创建各种各样的加速器,而不仅仅是GPU。因此,这些初创公司的CEO中有许多人决定不采用英伟达的方式,而是首先关注推理。

我认为英伟达在训练方面不会长期处于劣势。它的问题可能是芯片成本高,但在训练方面,客户会买单。此外,在推理方面,英伟达的Xavier是一款令人印象深刻的芯片。

寒武纪大爆发有益于可编程性

让我们回到寒武纪大爆发的观点。英伟达正确地指出,我们正处于算法研究和实验的早期阶段。一个在处理方面做得很好的ASIC(比如用于图像处理的卷积神经网络)可能(而且几乎肯定会)在处理方面做得很糟糕(例如,GAN、RNN或尚待发明的神经网络)。这里是GPU可编程性与英伟达的研究人员生态系统相结合的地方,如果英伟达能够解决即将出现的内存问题,那么GPU可以相当快地适应一种新的神经网络处理方式。通过使用NVLink创建一个由8个GPU和256 GB高带宽(HBM)内存组成的网状结构,英伟达已经以高昂的代价显著降低了内存容量问题。我们将不得不等待它的下一代GPU来了解它是否以及如何解决延迟和带宽问题,这些问题需要的内存大约是HBM的10倍。

推理战争

正如我在本系列的第1部分中所写的那样,对于推理领域,现在不存在巨无霸,边缘和数据中心推理市场是多样化的,并准备快速增长,但我不得不怀疑,从利润率的角度来看,大规模推理市场是否会是一个特别有吸引力的市场。毕竟,在未来的大宗商品市场上,由于许多公司都在争夺注意力和销量,利润率可能相当微薄。有些推理很简单,有些则非常困难。后一个市场将保持较高的利润率,因为只有配备了CPU、Nervana、GPU、DSP和ASIC等并行处理引擎的复杂SOC才能提供自动驾驶所需的性能。英特尔的Naveen Rao最近在twitter上发布消息称,Nervana推理处理器实际上将是一个采用Ice Lake CPU内核的10nm SOC。英伟达已经率先将Xavier SOC用于自动驾驶,而赛灵思也将在今年晚些时候采用类似的方法把Versal芯片用于自动驾驶。任何走在这条道路上的创业公司都需要有以下两点:a)非常好的“性能/瓦特”值,b)创新路线图,使他们保持领先于大宗商品。

结论

总之,我要重申以下几点:

1、AI的未来是由专用芯片实现的,专用芯片的市场将变得巨大。

2、全球最大的几家芯片公司打算在未来的人工智能芯片战争中获胜。虽然英特尔正在追赶,但不要低估它的能力。

3、有许多资金充足的初创企业,其中一些将会成功。如果你想投资一家风投支持的公司,请确保他们不会轻视英伟达的实力。

4、未来5年,中国将在很大程度上摆脱对美国人工智能技术的依赖。

5、英伟达拥有超过1万名工程师,其下一代用于人工智能的高端GPU可能会让我们所有人大吃一惊。

6、推理市场将迅速增长,并将有许多特定于应用的器件的空间。FPGA可能在这里发挥重要作用,特别是赛灵思的下一代FPGA。

显然,关于这个主题有很多内容要介绍,而我只是触及了皮毛!感谢您花时间阅读本系列文章,我希望它具有启发性和知识性。

Comments