這是一個系列文章,從各個角度來評估一個問題:「我的業務要不要用 AI ?能不能用 AI?」

本期評估角度——黑箱

系列文章列表:

黑箱是人工智能的缺點

並非所有人工智能都是黑箱的,大家說的黑箱主要指當下最熱門、效果也最好的「深度學習」。

在我之前寫的《一文看懂深度學習》中,舉過一個水龍頭的例子,從那個例子就可以看出:深度學習的工作原理不是講邏輯(基於規則),而是大力出奇蹟(基於統計)。

大力出奇蹟會導致幾個結果:

- 深度學習只能告訴你「是什麼」,但是不能告訴你「為什麼」

- 沒人能預知在什麼情況下會出現錯誤

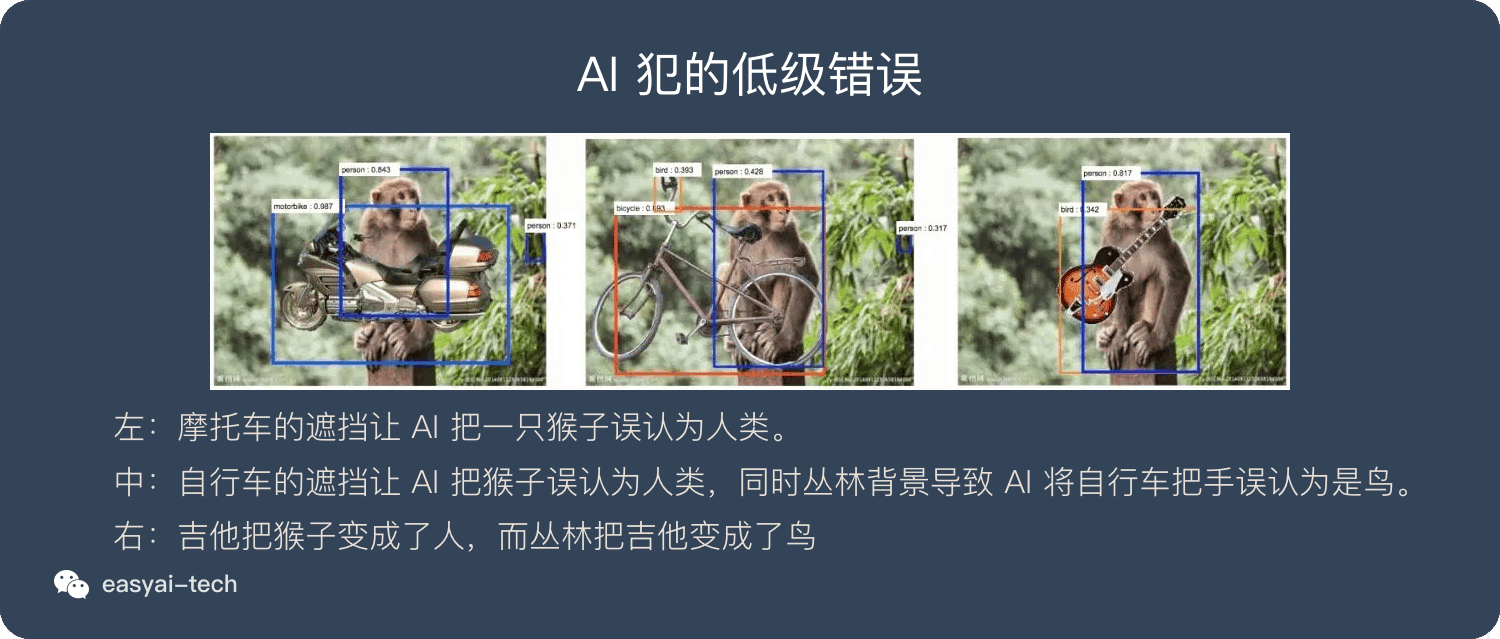

下面的圖片就會展示一些人工智能所犯下的「低級錯誤」。

而最可怕的是:當我們發現問題時,並不能針對具體問題來對症下藥。

我們過去的計算機科學大部分是基於規則的,很像一台汽車,我們很清楚的知道這台車是如何組裝起來的,所以發現螺絲鬆了就檸緊,哪個零件老化了就換一個。完全可以做到對症下藥。

而深度學習則完全不一樣,當我們發現問題時,不能做到對症下藥,只能全局優化(比如灌更多的數據)。

擴展閱讀:

《深度 | Nature:我們能打開人工智能的「黑箱」嗎?》

哪些問題不適合「依賴」 AI ?

由於深度學習的黑箱特性,並非所有問題都適合用深度學習來解決。

我們評估哪些問題適合,哪些問題不適合的時候,可以從2個角度來評估:

- 是否需要解釋

- 錯誤容忍度

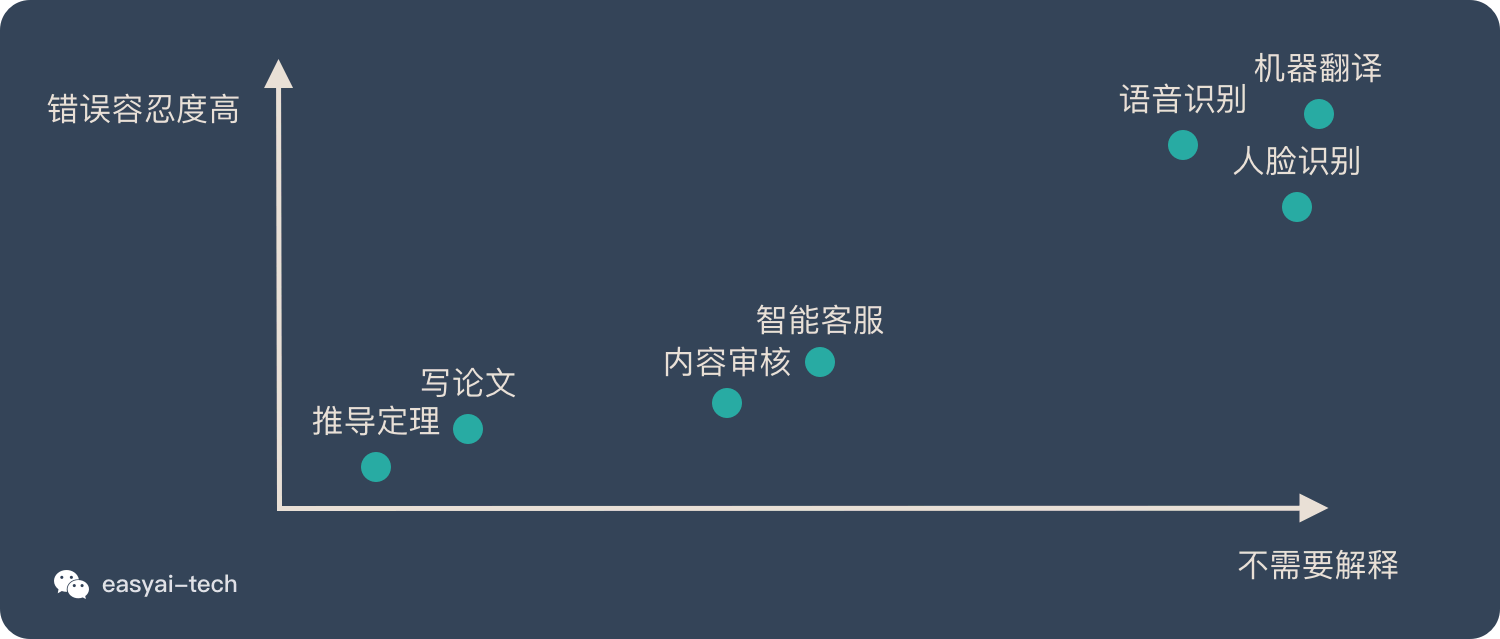

我們先從這2個角度來看看普及率較高的AI應用:

| 案例 | 是否需要解釋 | 錯誤容忍度 |

|---|---|---|

| 語音識別 | 用戶只關心效果好不好,並不關心背後的原理是什麼 | 偶爾出現一些錯誤並不影響對整句話的理解。少量出錯是可以接受的。 |

| 人臉識別 | 同上 | 相比語音識別,用戶對出錯的容忍度要低一些,因為需要重新刷臉。 |

| 機器翻譯 | 同上 | 跟語音識別類似,只要大面上準確,並不影響整體的理解。 |

我們再看一些 AI 和人力結合的具體應用:

| 案例 | 是否需要解釋 | 錯誤容忍度 |

|---|---|---|

| 智能客服 | 用戶不關心是人工服務還是機器服務,只要能解決我的問題就行 | 如果機器客服不能理解我的意圖,無法幫我解決問題,用戶會很不滿意。所以當機器搞不定 的時候需要人工來補位 |

| 內容審核 | 對於審核不通過的內容,需要解釋原因。通過的內容不需要解釋為什麼。 | 有一種職業叫「鑒黃師」,目前正在逐步被機器替代,但是並沒有完全替代,因為有時候機器會拿不準,這個時候人工來複審 |

最後看一些不適合AI落地的場景:

| 案例 | 是否需要解釋 | 錯誤容忍度 |

|---|---|---|

| 推導定理 | 科學是絕對嚴謹的,一定是從邏輯上推導出來的,而不是統計出來的。 | 如果有例外就不能稱作定理,一定是絕對正確沒有錯誤的。 |

| 寫論文 | 人工智能已經可以寫小說,詩歌,散文。但是論文這種文體要求非常嚴謹的上下文邏輯。 | 論文里是不允許有錯誤的,全文的邏輯要非常清晰,哪怕一個細節出現了邏輯問題,也會造成整篇論文沒有價值。 |

如果我們把上面提到的案例全部放在象限中,大致如下:

所以,在評估的時候有3條原則:

- 解決方案越需要解釋背後的原因,越不適合用深度學習

- 對錯誤的容忍度越低,越不適合使用深度學習

- 上面2條並非絕對判斷標準,還需要看商業價值和性價比,自動駕駛和醫療就是反例。

案例分析:醫療

人工智能在醫療行業的應用被大家廣泛看好,因為醫療行業有很多痛點:

- 醫療資源不足,尤其是優質的醫生

- 醫療資源的分配極度不均衡,中國很多疾病只有北京能治

- 其實醫生的誤診率也很高(惡性腫瘤誤診率40%,器官異位誤診率60%)

目前的人工智能已經可以幫助人類做診斷並提供治療手段。

奇怪的是:無論是從可解釋性還是從錯誤的容忍度上來講,醫療診斷都不適合用人工智能。

但當我們將人工智能作為一種輔助,最終還是靠人類來做判斷和下決定時。人類和機器可以形成很好的互補。

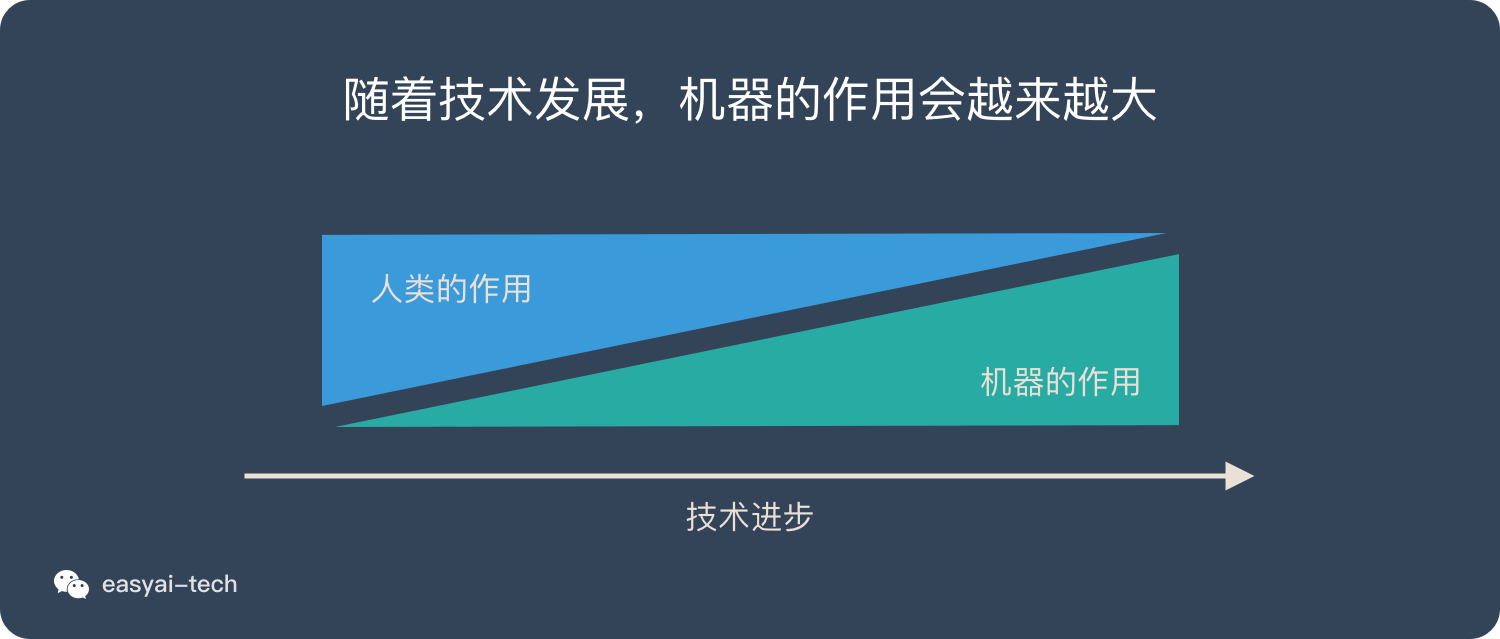

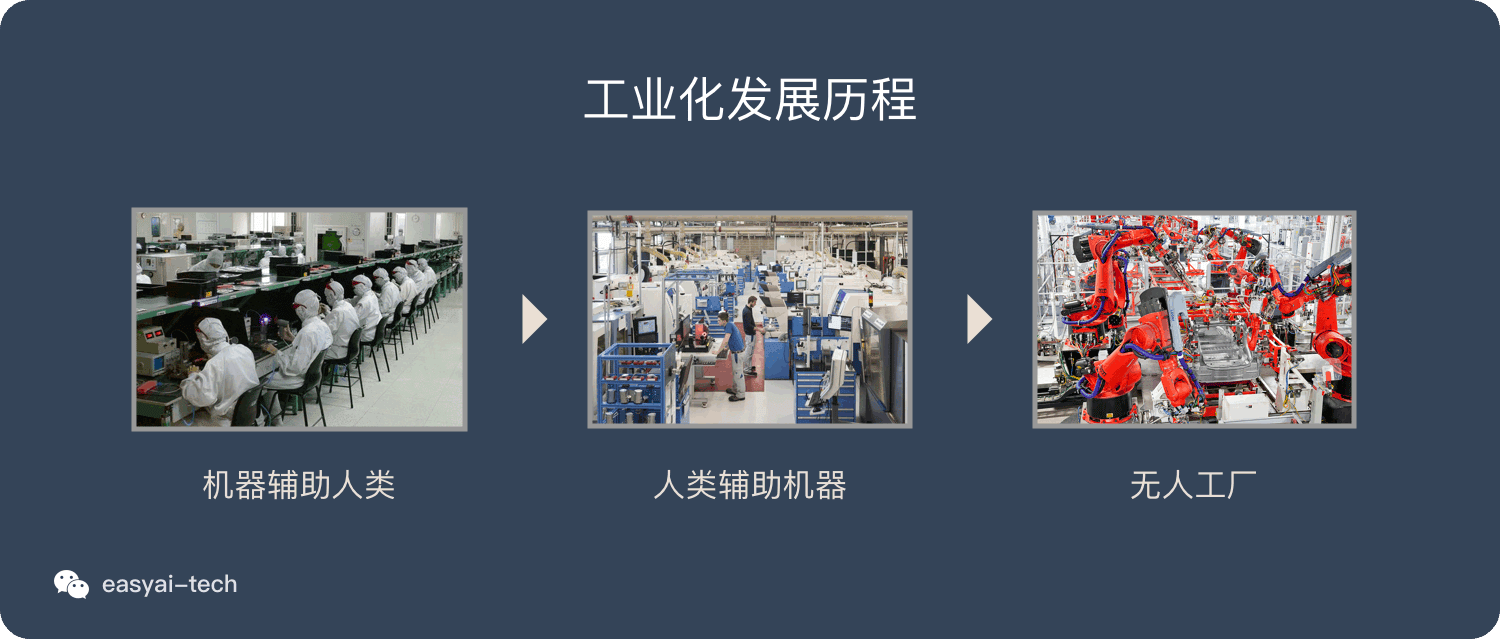

工廠的發展也是類似的路徑:

- 一開始機器只做輔助,人力是最重要的

- 機械化和自動化的程度越來越高,機器的作用越來越大

- 最終實現無人工廠(已經實現)

所以從「可解釋性」和「錯誤容忍度」上可以評估出來哪些問題不適合「完全依賴人工智能」。

但只要商業價值足夠大,還是有解決方案的——人類和機器相互配合,共同解決問題。並且隨着技術的進步,不斷減少對人力的需求。

擴展閱讀:

我的博客即將同步至騰訊雲+社區,邀請大家一同入駐:https://cloud.tencent.com/developer/support-plan?invite_code=33ax06m8ysao4

Comments