这是一个系列文章,从各个角度来评估一个问题:“我的业务要不要用 AI ?能不能用 AI?”

本期评估角度——黑箱

系列文章列表:

黑箱是人工智能的缺点

并非所有人工智能都是黑箱的,大家说的黑箱主要指当下最热门、效果也最好的“深度学习”。

在我之前写的《一文看懂深度学习》中,举过一个水龙头的例子,从那个例子就可以看出:深度学习的工作原理不是讲逻辑(基于规则),而是大力出奇迹(基于统计)。

大力出奇迹会导致几个结果:

- 深度学习只能告诉你“是什么”,但是不能告诉你“为什么”

- 没人能预知在什么情况下会出现错误

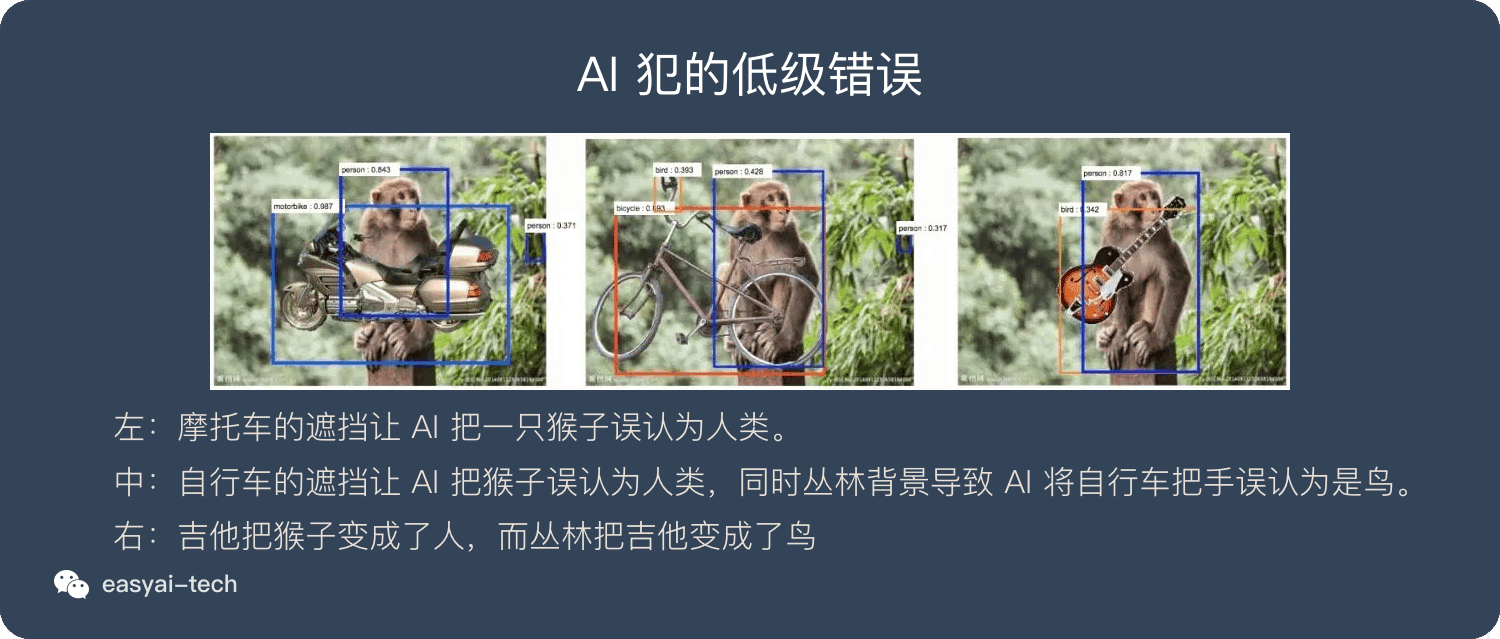

下面的图片就会展示一些人工智能所犯下的“低级错误”。

而最可怕的是:当我们发现问题时,并不能针对具体问题来对症下药。

我们过去的计算机科学大部分是基于规则的,很像一台汽车,我们很清楚的知道这台车是如何组装起来的,所以发现螺丝松了就柠紧,哪个零件老化了就换一个。完全可以做到对症下药。

而深度学习则完全不一样,当我们发现问题时,不能做到对症下药,只能全局优化(比如灌更多的数据)。

扩展阅读:

《深度 | Nature:我们能打开人工智能的“黑箱”吗?》

哪些问题不适合“依赖” AI ?

由于深度学习的黑箱特性,并非所有问题都适合用深度学习来解决。

我们评估哪些问题适合,哪些问题不适合的时候,可以从2个角度来评估:

- 是否需要解释

- 错误容忍度

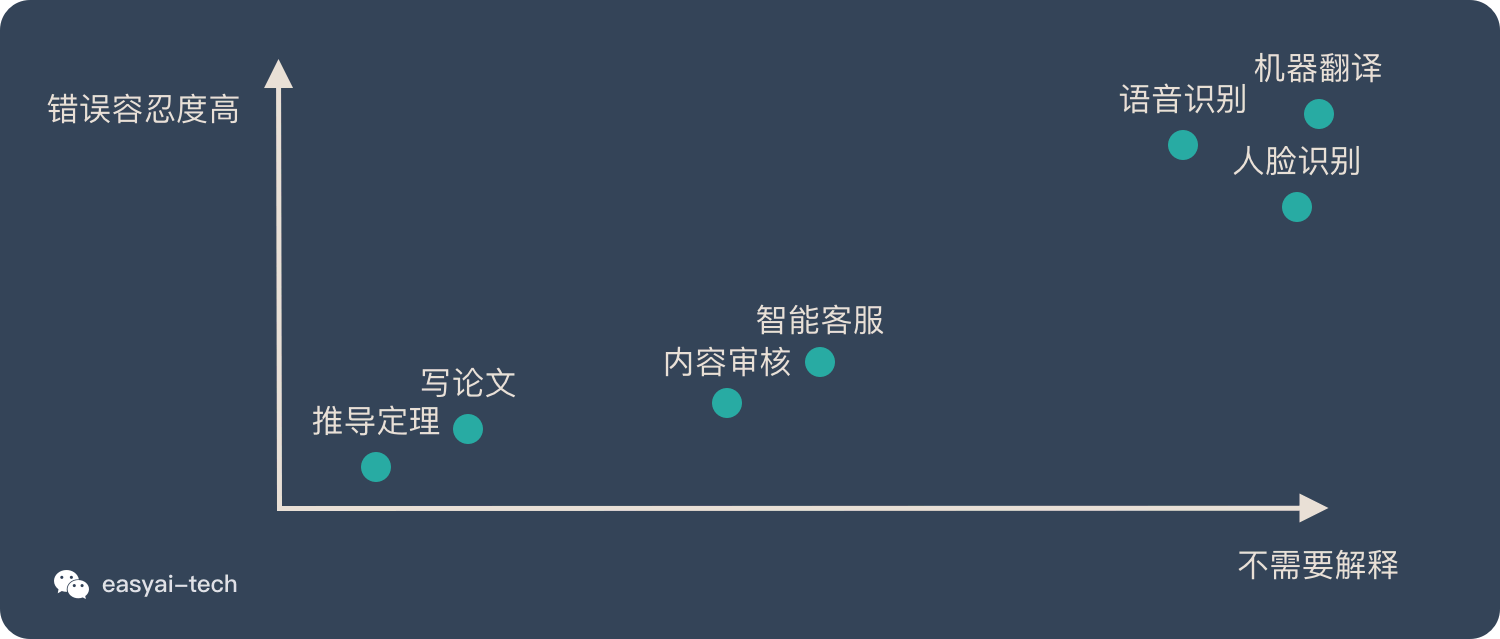

我们先从这2个角度来看看普及率较高的AI应用:

| 案例 | 是否需要解释 | 错误容忍度 |

|---|---|---|

| 语音识别 | 用户只关心效果好不好,并不关心背后的原理是什么 | 偶尔出现一些错误并不影响对整句话的理解。少量出错是可以接受的。 |

| 人脸识别 | 同上 | 相比语音识别,用户对出错的容忍度要低一些,因为需要重新刷脸。 |

| 机器翻译 | 同上 | 跟语音识别类似,只要大面上准确,并不影响整体的理解。 |

我们再看一些 AI 和人力结合的具体应用:

| 案例 | 是否需要解释 | 错误容忍度 |

|---|---|---|

| 智能客服 | 用户不关心是人工服务还是机器服务,只要能解决我的问题就行 | 如果机器客服不能理解我的意图,无法帮我解决问题,用户会很不满意。所以当机器搞不定 的时候需要人工来补位 |

| 内容审核 | 对于审核不通过的内容,需要解释原因。通过的内容不需要解释为什么。 | 有一种职业叫“鉴黄师”,目前正在逐步被机器替代,但是并没有完全替代,因为有时候机器会拿不准,这个时候人工来复审 |

最后看一些不适合AI落地的场景:

| 案例 | 是否需要解释 | 错误容忍度 |

|---|---|---|

| 推导定理 | 科学是绝对严谨的,一定是从逻辑上推导出来的,而不是统计出来的。 | 如果有例外就不能称作定理,一定是绝对正确没有错误的。 |

| 写论文 | 人工智能已经可以写小说,诗歌,散文。但是论文这种文体要求非常严谨的上下文逻辑。 | 论文里是不允许有错误的,全文的逻辑要非常清晰,哪怕一个细节出现了逻辑问题,也会造成整篇论文没有价值。 |

如果我们把上面提到的案例全部放在象限中,大致如下:

所以,在评估的时候有3条原则:

- 解决方案越需要解释背后的原因,越不适合用深度学习

- 对错误的容忍度越低,越不适合使用深度学习

- 上面2条并非绝对判断标准,还需要看商业价值和性价比,自动驾驶和医疗就是反例。

案例分析:医疗

人工智能在医疗行业的应用被大家广泛看好,因为医疗行业有很多痛点:

- 医疗资源不足,尤其是优质的医生

- 医疗资源的分配极度不均衡,中国很多疾病只有北京能治

- 其实医生的误诊率也很高(恶性肿瘤误诊率40%,器官异位误诊率60%)

目前的人工智能已经可以帮助人类做诊断并提供治疗手段。

奇怪的是:无论是从可解释性还是从错误的容忍度上来讲,医疗诊断都不适合用人工智能。

但当我们将人工智能作为一种辅助,最终还是靠人类来做判断和下决定时。人类和机器可以形成很好的互补。

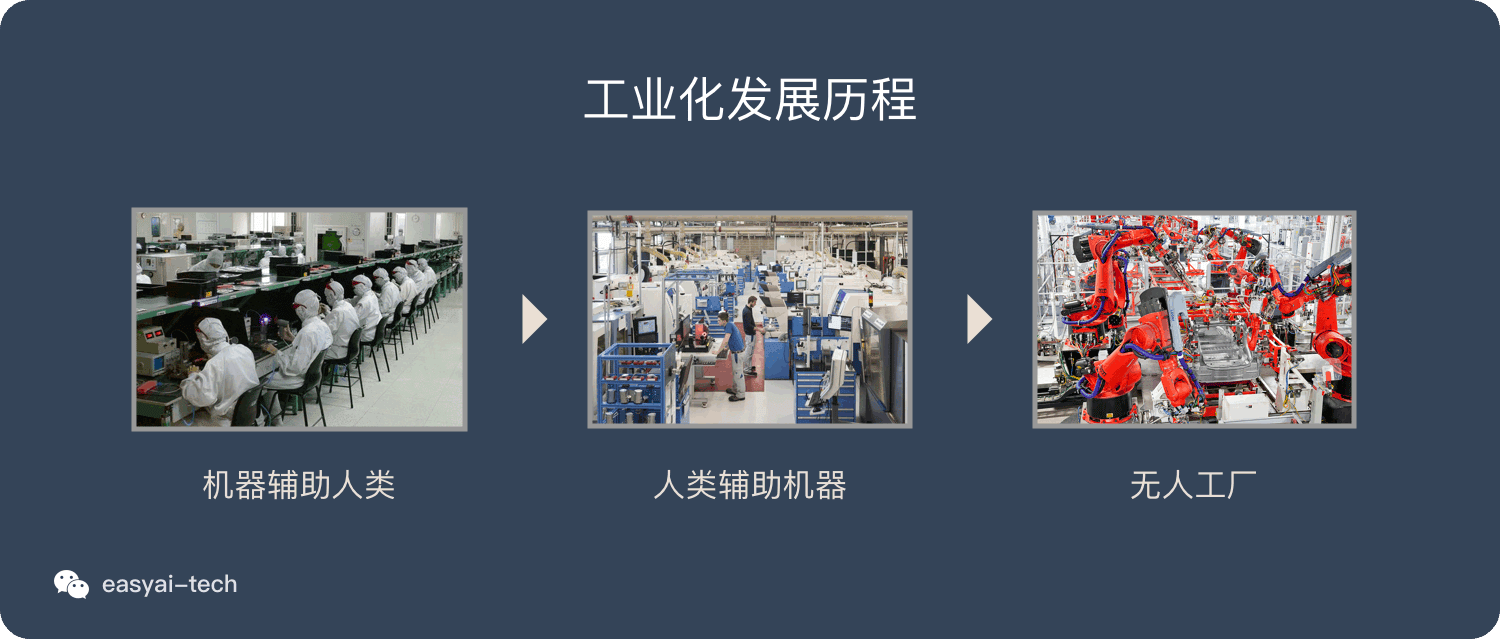

工厂的发展也是类似的路径:

- 一开始机器只做辅助,人力是最重要的

- 机械化和自动化的程度越来越高,机器的作用越来越大

- 最终实现无人工厂(已经实现)

所以从“可解释性”和“错误容忍度”上可以评估出来哪些问题不适合“完全依赖人工智能”。

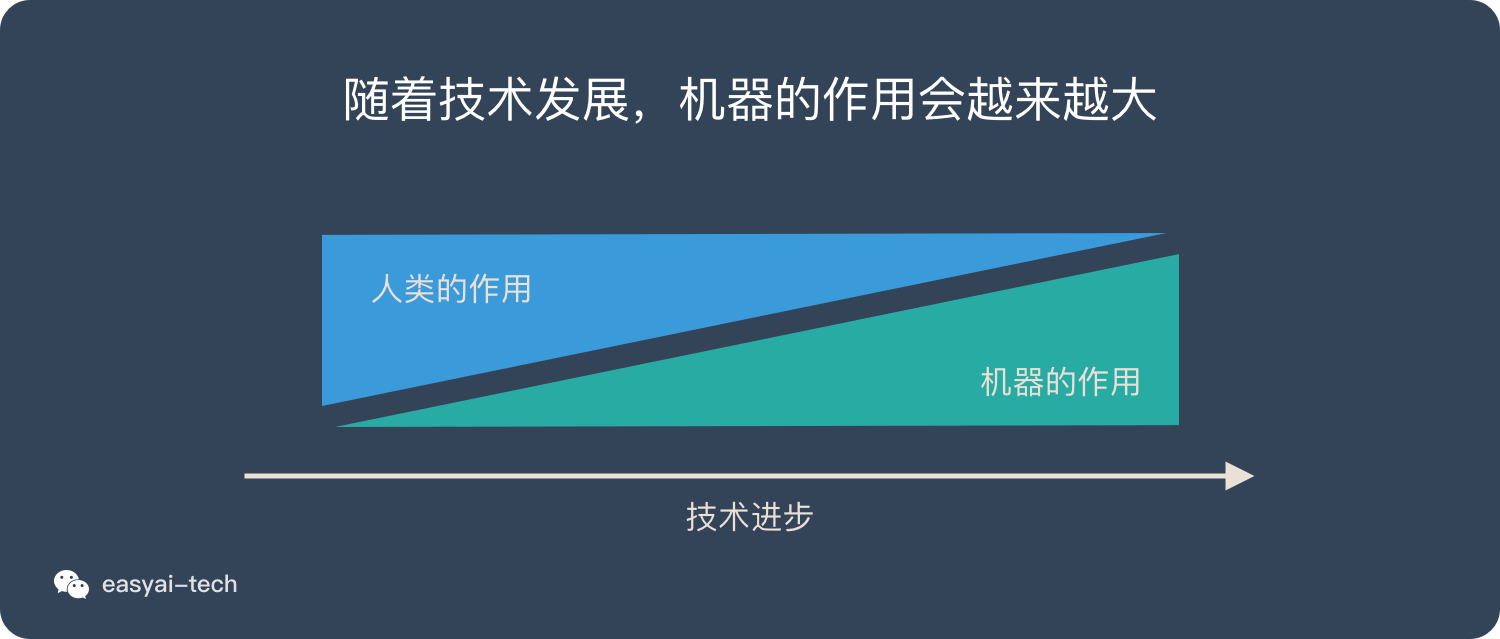

但只要商业价值足够大,还是有解决方案的——人类和机器相互配合,共同解决问题。并且随着技术的进步,不断减少对人力的需求。

扩展阅读:

我的博客即将同步至腾讯云+社区,邀请大家一同入驻:https://cloud.tencent.com/developer/support-plan?invite_code=33ax06m8ysao4

Comments