該協會為計算語言學第57屆年會(ACL 2019)將於本周開始在意大利的佛羅倫薩。我們藉此機會回顧了動畫NLP空間的主要研究趨勢,並從業務角度闡述了一些含義。這篇文章得到了統計數據的支持 – 猜測 – 過去20年來基於NLP的ACL論文分析。

1.動機

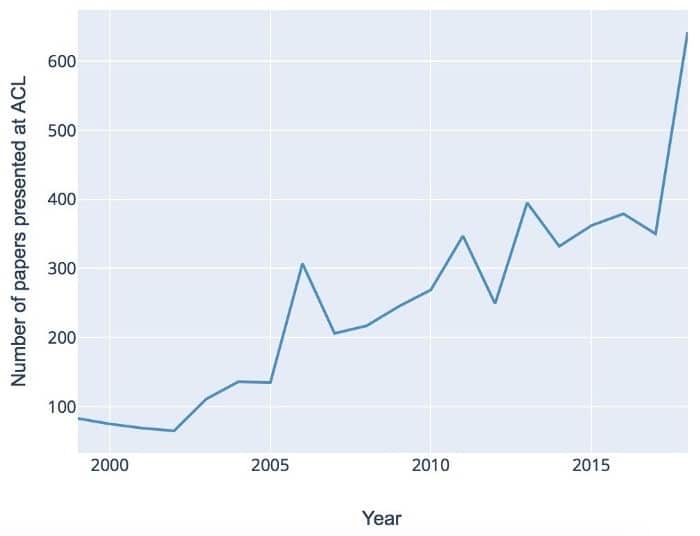

與其他物種相比,自然語言是人類思維的主要USP之一。NLP是當今技術討論的一個主要流行語,涉及計算機如何理解和生成語言。NLP在過去幾十年的崛起得到了幾個全球發展的支持 – 圍繞AI的普遍炒作,深度學習領域的指數級進展以及不斷增加的可用文本數據量。但是嗡嗡聲背後的實質是什麼?事實上,NLP是一個高度複雜的跨學科領域,由語言學,數學和計算機科學的高質量基礎研究不斷提供。ACL會議將這些不同的角度結合在一起。如下圖所示,過去幾年的研究活動蓬勃發展:

在下文中,我們總結了數據策略,算法,任務以及多語言NLP方面的一些核心趨勢。該分析基於自1998年以來發表的ACL論文,該論文使用針對NLP和機器學習領域的領域特定本體進行處理。

2.數據:解決瓶頸問題

免費提供的文本數據量呈指數級增長,這主要是由於Web內容的大量生成。但是,這大量數據帶來了一些關鍵挑戰。首先,大數據本質上是嘈雜的。想想石油和金屬等自然資源 – 在最終產品中使用之前,需要進行精鍊和凈化處理。數據也是如此。一般來說,生產渠道越「民主」,數據越臟 – 這意味着必須花更多的精力來清理它。例如,來自社交媒體的數據將需要更長的清潔管道。除此之外,你還需要處理像表情符號和不規則標點符號這樣的自我表達的浪漫,這些通常在科學論文或法律合同等更正式的環境中不存在。

另一個主要挑戰是標記數據瓶頸:嚴格來說,大多數最先進的算法都受到監督。他們不僅需要標記數據 – 他們需要大標籤數據。這與深度學習系列的高級複雜算法特別相關。就像孩子的大腦首先需要最大的輸入才能學習它的母語一樣,要「深入」,算法首先需要大量的數據才能在整個複雜性中包含語言。

傳統上,小規模的訓練數據已經手動注釋。但是,大型數據集的專用手動注釋帶來了效率權衡,這種權衡很少被接受,尤其是在業務環境中。

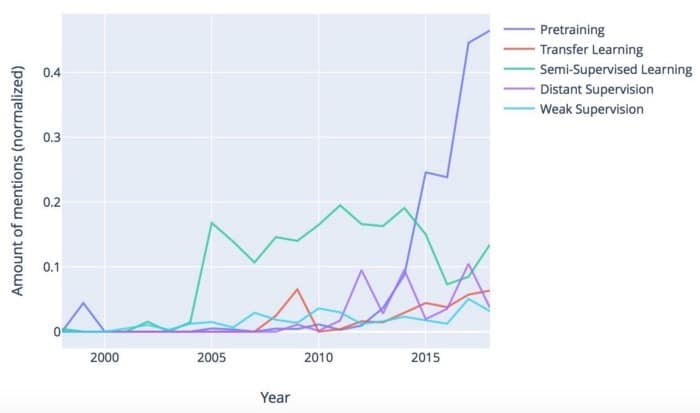

有哪些可能的解決方案?一方面,管理方面有一些改進,包括。眾包和培訓數據即服務(TDaaS)。另一方面,機器學習社區也提出了一系列用於創建帶注釋數據集的自動變通方法。下圖顯示了一些趨勢:

顯然,預訓練在過去五年中增幅最大。在預訓練中,模型首先在大型通用數據集上進行訓練,然後根據任務特定數據和目標進行調整。它的受歡迎程度很大程度上是因為Google和Facebook等公司正在為開源社區提供開箱即用的大型模型。特別是預訓練的單詞嵌入,如Word2Vec,FastText和BERT,使NLP開發人員能夠跳到更高的水平。轉移學習是在不同任務中重用模型的另一種方法。如果現有模型的重用不是一種選擇,那麼可以利用少量標記數據自動標記更大量的數據,如在遠程和監管不力 – 但請注意,這些方法通常會導致標籤精度下降。

3.算法:深度學習中的一系列中斷

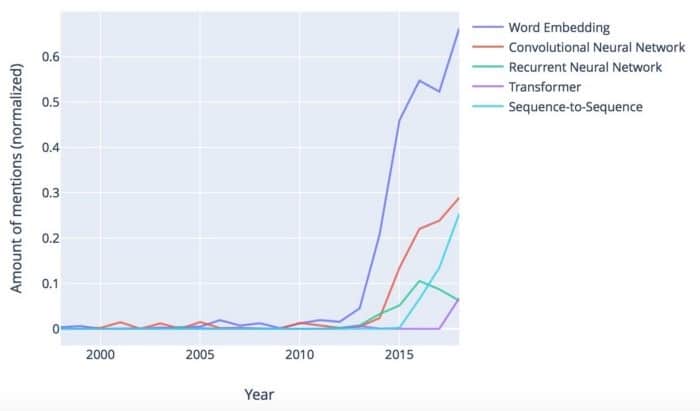

在算法方面,近年來的研究主要集中在深度學習系列:

Word嵌入顯然正在佔據上風。在其基本形式中,Mikolov等人引入了嵌入詞。(2013年)。單詞嵌入背後的通用語言原則是分佈相似性:一個單詞可以通過其出現的上下文來表徵。因此,作為人類,我們通常可以用「交易」或「合同」等合適的詞語完成句子「客戶在今天簽署___」這一句子。Word嵌入允許自動執行此操作,因此非常強大,可以解決上下文感知問題的核心問題。

雖然word2vec(原始嵌入算法)是統計的,並不考慮生活的複雜性,如模糊性,語境敏感性和語言結構,後續方法豐富了包含各種語言信息的詞嵌入。而且,順便說一下,你不僅可以嵌入單詞,還可以嵌入其他東西,如感官,句子和整個文檔。

神經網絡是深度學習的主力(參見Goldberg和Hirst(2017),介紹了NLP環境中的基本架構)。卷積神經網絡在過去幾年中有所增加,而傳統的遞歸神經網絡(RNN)的普及正在下降。一方面,這要歸功於更高效的基於RNN的架構,如LSTM和GRU。另一方面,序列到序列中引入了一種新的,相當破壞性的順序處理機制 – 注意力Sutskever等人的(seq2seq)模型。(2014)。如果你使用谷歌翻譯,你可能已經注意到幾年前翻譯質量的超越 – seq2seq是罪魁禍首。雖然seq2seq仍然依賴於管道中的RNN,但變壓器架構是2017年的另一個重大進步,最終擺脫了複發並完全依賴於注意機制(Vaswani等人2017)。

深度學習是一個充滿活力和迷人的領域,但從應用程序的角度來看,它也可能非常令人生畏。如果確實如此,請記住,大多數開發都是通過提高大數據規模的效率,上下文感知以及針對不同任務和語言的可擴展性來實現的。對於數學介紹,Young等人。(2018)提供了對最先進算法的出色概述。

4.整合各種NLP任務

當我們查看特定的NLP任務(例如情緒分析和命名實體識別)時,庫存比基礎算法更穩定。多年來,從預處理任務(如句法解析和信息提取)到語義導向任務(如情感/情感分析和語義分析)的梯度演變。這對應於Cambria等人描述的三種「全局」NLP發展曲線 – 語法,語義和語境感知。(2014)。正如我們在上一節中看到的那樣,第三條曲線 – 對更大背景的認識 – 已經成為新的深度學習算法背後的主要驅動因素之一。

從更一般的角度來看,任務不可知的研究有一個有趣的趨勢。在第2節中,我們看到了現代數學方法的泛化能力如何在轉移學習和預訓練等場景中得到充分利用。實際上,現代算法正在開發出驚人的多任務處理能力 – 因此,手頭特定任務的相關性會降低。下圖顯示自2006年以來對特定NLP任務的討論總體下降:

5.關於多語言研究的說明

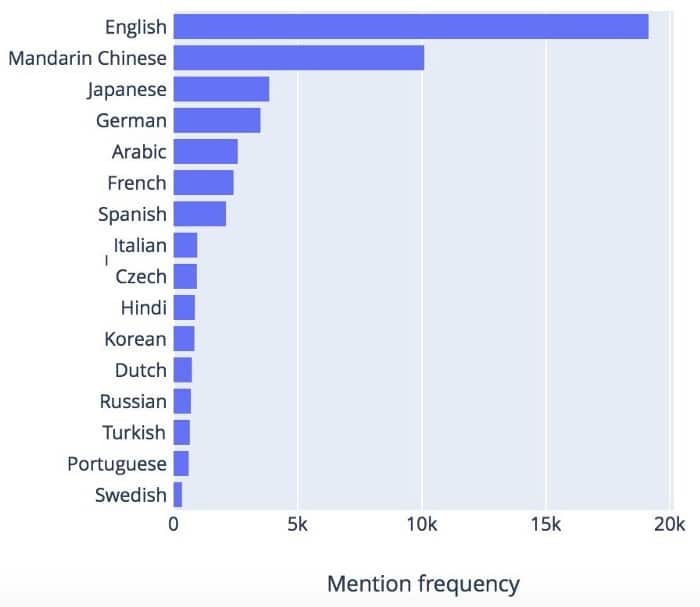

隨着全球化,走向國際成為業務增長的必要條件。傳統上,英語是大多數NLP研究的起點,但近年來對可擴展多語言NLP系統的需求也在增加。這種需求如何反映在研究界?將不同的語言視為不同的鏡頭,通過它們我們可以看到同一個世界 – 它們共享許多屬性,這一事實完全被現代學習算法所支持,並且具有越來越強大的抽象和泛化能力。儘管如此,特別是在預處理階段,必須徹底解決特定於語言的功能。如下圖所示,ACL研究中所涉及的語言多樣性不斷增加:

然而,正如上一節中針對NLP任務所看到的那樣,一旦語言特定的差異被中和到下一波算法中,我們就可以期待合併。圖6總結了最流行的語言。

對於其中一些語言,研究興趣符合商業吸引力:英語,中文和西班牙語等語言彙集了大量可用數據,龐大的母語人口和相應地理區域的巨大經濟潛力。然而,豐富的「較小」語言也表明NLP領域通常朝着多語言和跨語言概括的理論上合理的方式發展。

總結

在全球人工智能炒作的刺激下,NLP領域正在爆發新方法和顛覆性改進。模型意義和背景依賴性正在轉變,可能是人類語言中最普遍和最具挑戰性的事實。現代算法的泛化能力允許跨不同任務,語言和數據集進行有效擴展,從而顯着加快NLP開發的ROI周期,並允許將NLP靈活有效地集成到各個業務場景中。

本文轉自towardsdatascience,原文地址

Comments