什麼是標量

標量只有大小概念,沒有方向的概念。通過一個具體的數值就能表達完整。

比如:重量、溫度、長度、提及、時間、熱量等都數據標量。

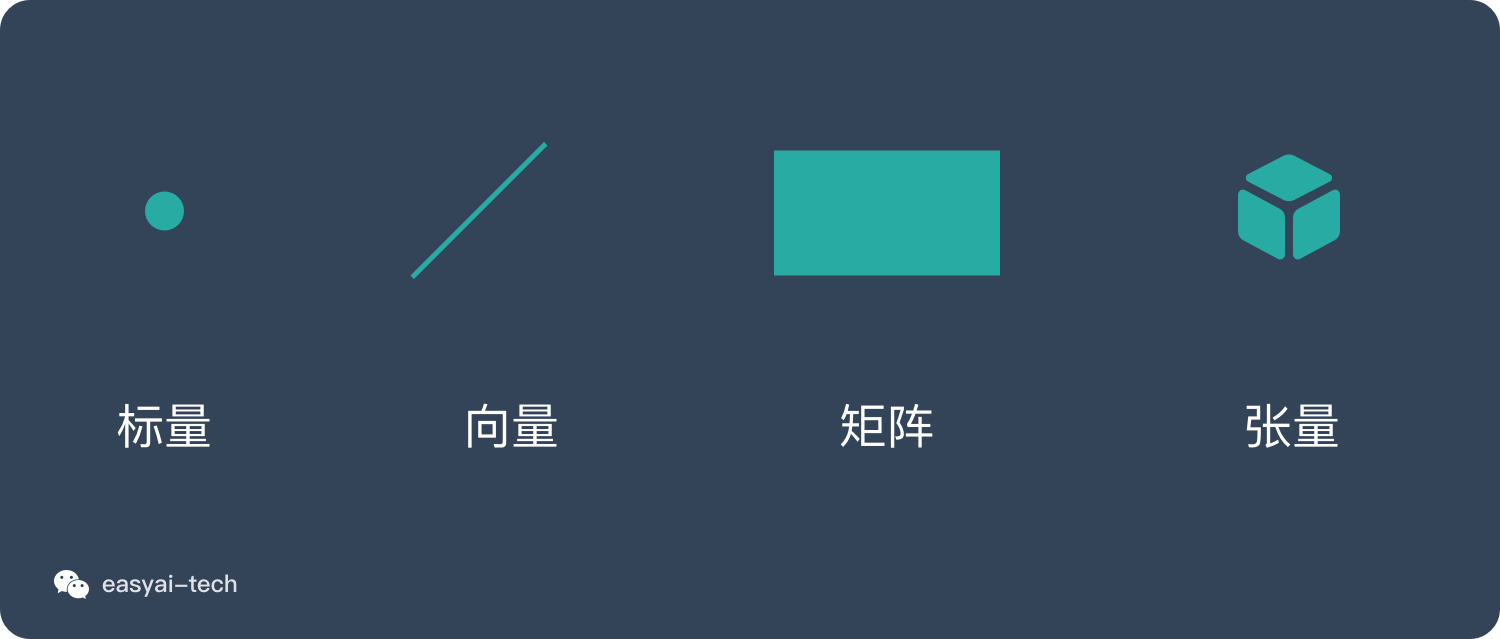

標量、向量、矩陣、張量的關係

這4個概念是維度不斷上升的,我們用點線面體的概念來比喻解釋會更加容易理解:

感興趣的可以通過下面的內容了解詳情:

《一文看懂標量》

《一文看懂向量》

《一文看懂矩陣》

《一文看懂張量》

百度百科和維基百科

標量(scalar),亦稱「無向量」。有些物理量,只具有數值大小,而沒有方向,部分有正負之分。物理學中,標量(或作純量)指在坐標變換下保持不變的物理量。用通俗的說法,標量是只有大小,沒有方向的量。

標量是一個的元素欄位,其用於定義一個向量空間。由多個標量描述的量,例如具有方向和幅度,被稱為矢量。在線性代數,實數或場的其它元素被稱為標量,並涉及到在載體通過的操作的向量空間標量乘法,其中載體可以由多個以產生另一矢量相乘。更一般地,可以通過使用任何欄位而不是實數來定義向量空間,例如複數。然後該向量空間的標量將成為相關欄位的元素。