在效率提高的推动下,这些新公司使用AI来自动化和优化其业务的核心流程。例如,根据BenchSci的最新更新,至少有148家初创企业的目标是实现制药行业非常昂贵的药物开发过程的自动化。

Author Archive

将人工智能战略落地的秘密

人工智能战略建模与创建传统业务战略不同。本文旨在指导从业人员制定有针对性的人工智能战略。这些见解基于我的个人经验以及对大众汽车,谷歌,人工智能基金等公司的全球人工智能领导者的专家访谈。

词干提取 – Stemming | 词形还原 – Lemmatisation

词干提取和词形还原是英文语料预处理中的重要环节。虽然他们的目的一致,但是两者还是存在一些差异。

本文将介绍他们的概念、异同、实现算法等。

想要了解更多 NLP 相关的内容,请访问 NLP专题 ,免费提供59页的NLP文档下载。

访问 NLP 专题,下载 59 页免费 PDF

词干提取和词形还原在 NLP 中在什么位置?

词干提取是英文语料预处理的一个步骤(中文并不需要),而语料预处理是 NLP 的第一步,下面这张图将让大家知道词干提取在这个知识结构中的位置。

什么是词干提取和词形还原?

词干提取 – Stemming

词干提取是去除单词的前后缀得到词根的过程。

大家常见的前后词缀有「名词的复数」、「进行式」、「过去分词」…

词形还原 – Lemmatisation

词形还原是基于词典,将单词的复杂形态转变成最基础的形态。

词形还原不是简单地将前后缀去掉,而是会根据词典将单词进行转换。比如「drove」会转换为「drive」。

为什么要做词干提取和词形还原?

比如当我搜索「play basketball」时,Bob is playing basketball 也符合我的要求,,但是 play 和 playing 对于计算机来说是 2 种完全不同的东西,所以我们需要将 playing 转换成 play。

词干提取和词形还原的目的就是将长相不同,但是含义相同的词统一起来,这样方便后续的处理和分析。

词干提取和词形还原的 4 个相似点

- 目标一致。词干提取和词形还原的目标均为将词的屈折形态或派生形态简化或归并为词干(stem)或原形的基础形式,都是一种对词的不同形态的统一归并的过程。

- 结果部分交叉。词干提取和词形还原不是互斥关系,其结果是有部分交叉的。一部分词利用这两类方法都能达到相同的词形转换效果。如“dogs”的词干为“dog”,其原形也为“dog”。

- 主流实现方法类似。目前实现词干提取和词形还原的主流实现方法均是利用语言中存在的规则或利用词典映射提取词干或获得词的原形。

- 应用领域相似。主要应用于信息检索和文本、自然语言处理等方面,二者均是这些应用的基本步骤。

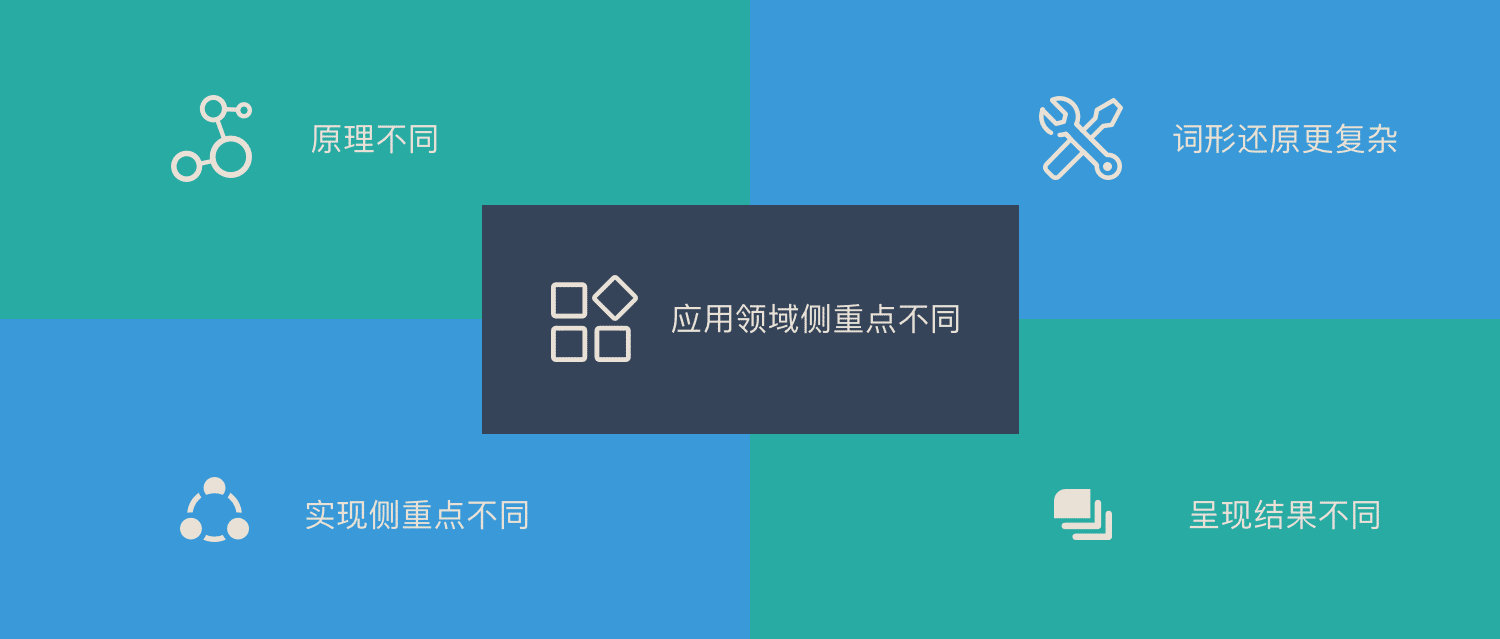

词干提取和词形还原的 5 个不同点

- 在原理上,词干提取主要是采用“缩减”的方法,将词转换为词干,如将“cats”处理为“cat”,将“effective”处理为“effect”。而词形还原主要采用“转变”的方法,将词转变为其原形,如将“drove”处理为“drive”,将“driving”处理为“drive”。

- 在复杂性上,词干提取方法相对简单,词形还原则需要返回词的原形,需要对词形进行分析,不仅要进行词缀的转化,还要进行词性识别,区分相同词形但原形不同的词的差别。词性标注的准确率也直接影响词形还原的准确率,因此,词形还原更为复杂。

- 在实现方法上,虽然词干提取和词形还原实现的主流方法类似,但二者在具体实现上各有侧重。词干提取的实现方法主要利用规则变化进行词缀的去除和缩减,从而达到词的简化效果。词形还原则相对较复杂,有复杂的形态变化,单纯依据规则无法很好地完成。其更依赖于词典,进行词形变化和原形的映射,生成词典中的有效词。

- 在结果上,词干提取和词形还原也有部分区别。词干提取的结果可能并不是完整的、具有意义的词,而只是词的一部分,如“revival”词干提取的结果为“reviv”,“ailiner”词干提取的结果为“airlin”。而经词形还原处理后获得的结果是具有一定意义的、完整的词,一般为词典中的有效词。

- 在应用领域上,同样各有侧重。虽然二者均被应用于信息检索和文本处理中,但侧重不同。词干提取更多被应用于信息检索领域,如Solr、Lucene等,用于扩展检索,粒度较粗。词形还原更主要被应用于文本挖掘、自然语言处理,用于更细粒度、更为准确的文本分析和表达

3 种主流的词干提取算法

Porter

这种词干算法比较旧。它是从20世纪80年代开始的,其主要关注点是删除单词的共同结尾,以便将它们解析为通用形式。它不是太复杂,它的开发停止了。

通常情况下,它是一个很好的起始基本词干分析器,但并不建议将它用于复杂的应用。相反,它在研究中作为一种很好的基本词干算法,可以保证重复性。与其他算法相比,它也是一种非常温和的词干算法。

「推荐」Snowball

种算法也称为 Porter2 词干算法。它几乎被普遍认为比 Porter 更好,甚至发明 Porter 的开发者也这么认为。Snowball 在 Porter 的基础上加了很多优化。Snowball 与 Porter 相比差异约为5%。

Lancaster

Lancaster 的算法比较激进,有时候会处理成一些比较奇怪的单词。如果在 NLTK 中使用词干分析器,则可以非常轻松地将自己的自定义规则添加到此算法中。

词形还原的实践方法

词形还原是基于词典的,每种语言都需要经过语义分析、词性标注来建立完整的词库,目前英文词库是很完善的。

Python 中的 NLTK 库包含英语单词的词汇数据库。这些单词基于它们的语义关系链接在一起。链接取决于单词的含义。特别是,我们可以利用 WordNet。

import nltk

from nltk.stem import WordNetLemmatizer

lemmatizer = WordNetLemmatizer()

print(lemmatizer.lemmatize("blogs"))

#Returns blogimport nltk

from nltk.stem import WordNetLemmatizer

lemmatizer = WordNetLemmatizer()

print(lemmatizer.lemmatize("blogs"))

#Returns blog

总结

词干提取和词形还原都是将长相不同,但是含义相同的词统一起来,这样方便后续的处理和分析。

他们是英文语料预处理中的一个环节。

词干提取和词形还原的 4 个相似点:

- 目标一致

- 部分结果一致

- 主流实现方式类似

- 应用领域相似

词干提取和词形还原的 5 个不同点:

- 原理上不同

- 词形还原更加复杂

- 具体实现方式的侧重点不同

- 呈现结果有区别

- 应用领域上,侧重点不完全一致

3 种词干提取的主流算法:

- Porter

- Snowball

- Lancaster

英文的词形还原可以直接使用 Python 中的 NLTK 库,它包含英语单词的词汇数据库。

百度百科+维基百科

词干提取

在词法学和信息检索里,词干提取是去除词缀得到词根的过程(得到单词最一般的写法)。对于一个词的形态词根,词干并不需要完全相同;相关的词映射到同一个词干一般能得到满意的结果,即使该词干不是词的有效根。从1968年开始在计算机科学领域出现了词干提取的相应算法。很多搜索引擎在处理词汇时,对同义词采用相同的词干作为查询拓展,该过程叫做归并。词干提取项目一般涉及到词干提取算法或词干提取器。

在语言形态学和信息检索中,词干化是将变形(或有时衍生)词语减少到词干,词根或词形的过程 – 通常是书面形式。茎不必与该词的形态根相同; 通常,相关的单词映射到同一个词干就足够了,即使这个词干本身并不是一个有效的词根。自20世纪60年代以来,已经在计算机科学中研究了词干化的算法。许多搜索引擎将具有相同词干的单词视为同义词作为一种查询扩展,一个叫做混淆的过程。

词形还原

语言学中的Lemmatisation(或 词形还原)是将单词的变形形式组合在一起的过程,因此它们可以作为单个项目进行分析,由单词的引理或字典形式标识。

在计算语言学中,lemmatisation是基于其预期含义确定单词的引理的算法过程。与词干化不同,词汇化取决于正确识别句子中的预期词性和词语的含义,以及围绕该句子的较大语境,例如邻近句子甚至整个文档。因此,开发有效的lemmatisation算法是一个开放的研究领域。

2019 年,机器学习给制造业带来的 10 大革命

机器学习将计划外机器停机时间减少了15-30%,生产量提高了20%,维护成本降低了30%,质量提高了35%。

了解分类任务的评估指标

我将演示我们的分类模型如何衡量绩效。在决定如何衡量绩效时存在细微差别。但首先,让我们创建一个0和1的数据帧。

机器学习的5大局限性

在本文中,我的目的是让读者相信,有时机器学习是正确的解决方案,有时候它是错误的解决方案。

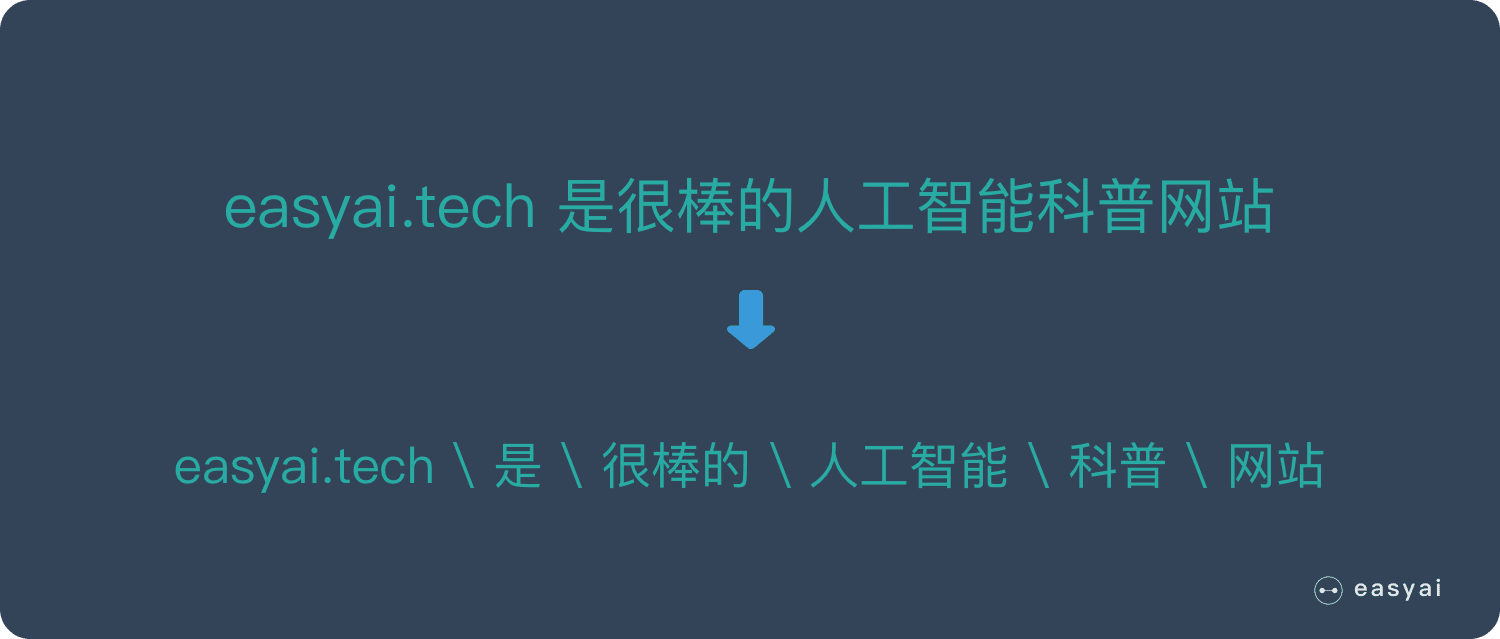

分词 – Tokenization

分词是 NLP 的基础任务,将句子,段落分解为字词单位,方便后续的处理的分析。

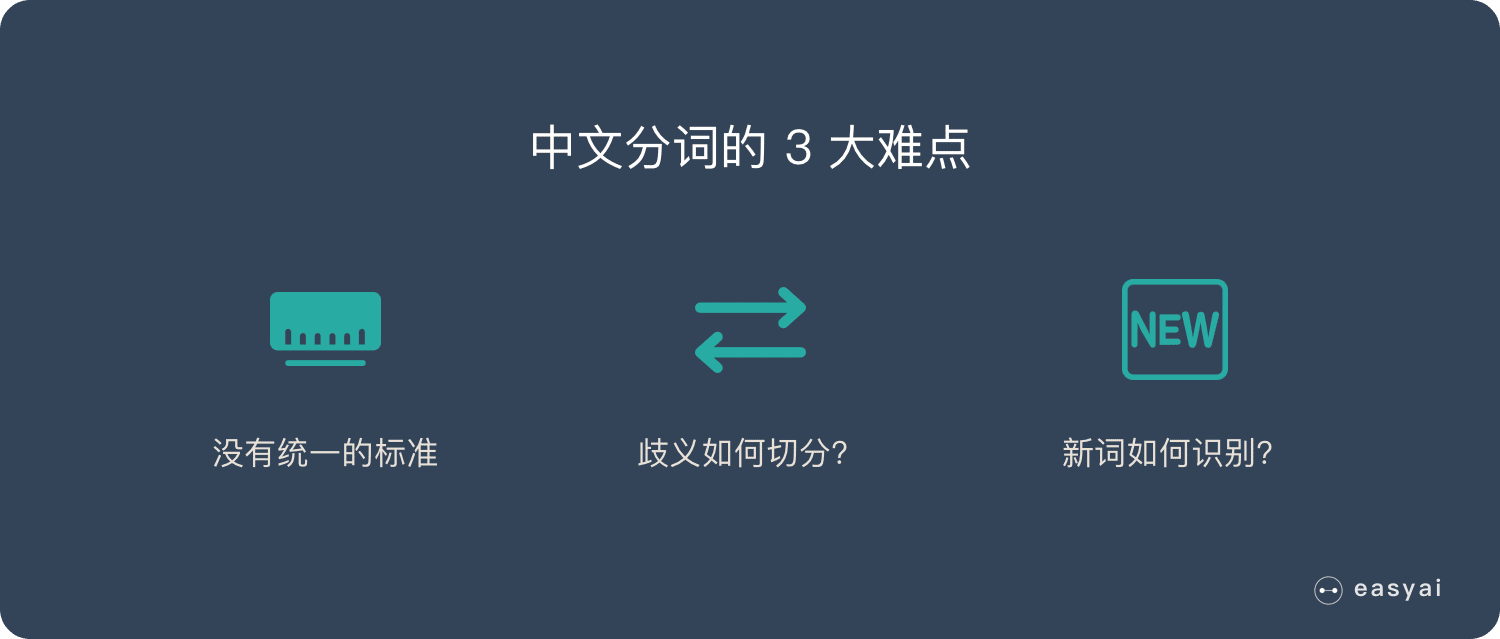

本文将介绍分词的原因,中英文分词的3个区别,中文分词的3大难点,分词的3种典型方法。最后将介绍中文分词和英文分词常用的工具。

想要了解更多 NLP 相关的内容,请访问 NLP专题 ,免费提供59页的NLP文档下载。

访问 NLP 专题,下载 59 页免费 PDF

什么是分词?

分词是 自然语言理解 – NLP 的重要步骤。

分词就是将句子、段落、文章这种长文本,分解为以字词为单位的数据结构,方便后续的处理分析工作。

为什么要分词?

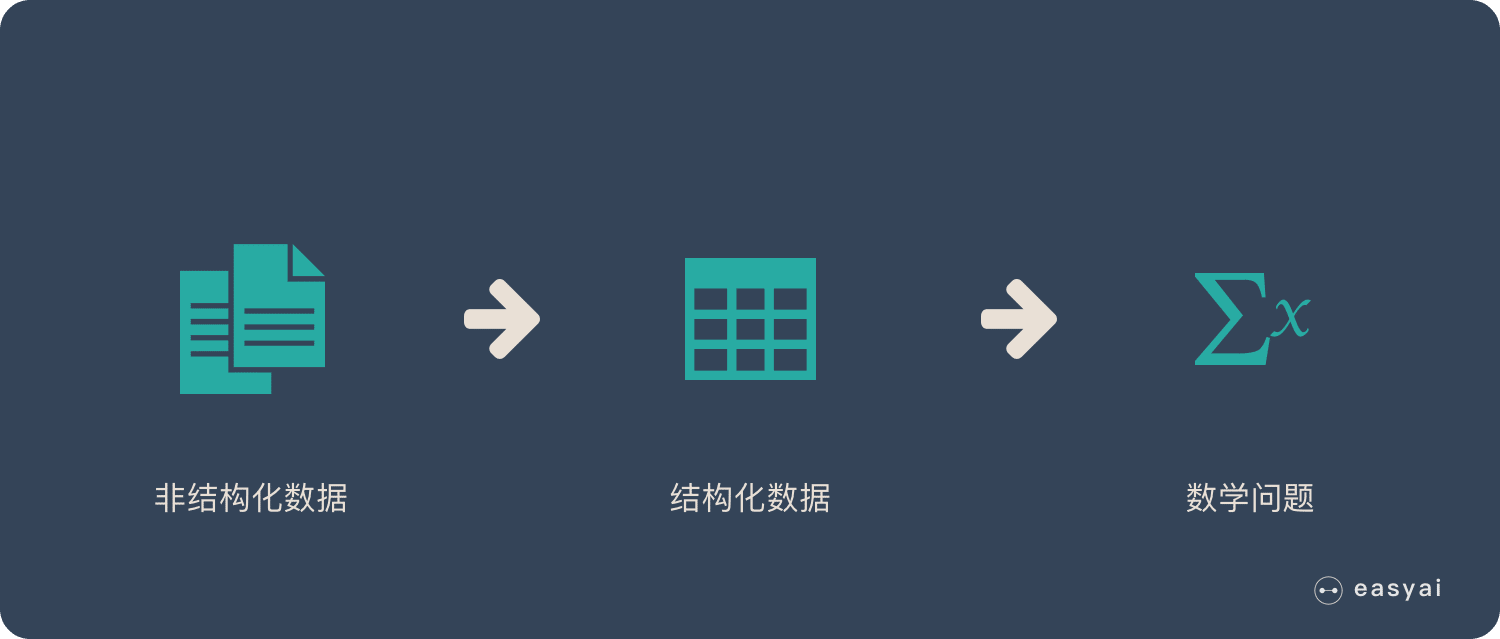

1.将复杂问题转化为数学问题

在 机器学习的文章 中讲过,机器学习之所以看上去可以解决很多复杂的问题,是因为它把这些问题都转化为了数学问题。

而 NLP 也是相同的思路,文本都是一些「非结构化数据」,我们需要先将这些数据转化为「结构化数据」,结构化数据就可以转化为数学问题了,而分词就是转化的第一步。

2.词是一个比较合适的粒度

词是表达完整含义的最小单位。

字的粒度太小,无法表达完整含义,比如”鼠“可以是”老鼠“,也可以是”鼠标“。

而句子的粒度太大,承载的信息量多,很难复用。比如”传统方法要分词,一个重要原因是传统方法对远距离依赖的建模能力较弱。”

3. 深度学习时代,部分任务中也可以「分字」

深度学习时代,随着数据量和算力的爆炸式增长,很多传统的方法被颠覆。

分词一直是 NLP 的基础,但是现在也不一定了,感兴趣的可以看看这篇论文:《Is Word Segmentation Necessary for Deep Learning of Chinese Representations?》。

不过在一些特定任务中,分词还是必要的。如:关键词提取、命名实体识别等。

中英文分词的3个典型区别

区别1:分词方式不同,中文更难

英文有天然的空格作为分隔符,但是中文没有。所以如何切分是一个难点,再加上中文里一词多意的情况非常多,导致很容易出现歧义。下文中难点部分会详细说明。

区别2:英文单词有多种形态

英文单词存在丰富的变形变换。为了应对这些复杂的变换,英文NLP相比中文存在一些独特的处理步骤,我们称为词形还原(Lemmatization)和词干提取(Stemming)。中文则不需要

词性还原:does,done,doing,did 需要通过词性还原恢复成 do。

词干提取:cities,children,teeth 这些词,需要转换为 city,child,tooth”这些基本形态

区别3:中文分词需要考虑粒度问题

例如「中国科学技术大学」就有很多种分法:

- 中国科学技术大学

- 中国 \ 科学技术 \ 大学

- 中国 \ 科学 \ 技术 \ 大学

粒度越大,表达的意思就越准确,但是也会导致召回比较少。所以中文需要不同的场景和要求选择不同的粒度。这个在英文中是没有的。

中文分词的3大难点

难点 1:没有统一的标准

目前中文分词没有统一的标准,也没有公认的规范。不同的公司和组织各有各的方法和规则。

难点 2:歧义词如何切分

例如「兵乓球拍卖完了」就有2种分词方式表达了2种不同的含义:

- 乒乓球 \ 拍卖 \ 完了

- 乒乓 \ 球拍 \ 卖 \ 完了

难点 3:新词的识别

信息爆炸的时代,三天两头就会冒出来一堆新词,如何快速的识别出这些新词是一大难点。比如当年「蓝瘦香菇」大火,就需要快速识别。

3种典型的分词方法

分词的方法大致分为 3 类:

- 基于词典匹配

- 基于统计

- 基于深度学习

给予词典匹配的分词方式

优点:速度快、成本低

缺点:适应性不强,不同领域效果差异大

基本思想是基于词典匹配,将待分词的中文文本根据一定规则切分和调整,然后跟词典中的词语进行匹配,匹配成功则按照词典的词分词,匹配失败通过调整或者重新选择,如此反复循环即可。代表方法有基于正向最大匹配和基于逆向最大匹配及双向匹配法。

基于统计的分词方法

优点:适应性较强

缺点:成本较高,速度较慢

这类目前常用的是算法是HMM、CRF、SVM、深度学习等算法,比如stanford、Hanlp分词工具是基于CRF算法。以CRF为例,基本思路是对汉字进行标注训练,不仅考虑了词语出现的频率,还考虑上下文,具备较好的学习能力,因此其对歧义词和未登录词的识别都具有良好的效果。

基于深度学习

优点:准确率高、适应性强

缺点:成本高,速度慢

例如有人员尝试使用双向LSTM+CRF实现分词器,其本质上是序列标注,所以有通用性,命名实体识别等都可以使用该模型,据报道其分词器字符准确率可高达97.5%。

常见的分词器都是使用机器学习算法和词典相结合,一方面能够提高分词准确率,另一方面能够改善领域适应性。

中文分词工具

下面排名根据 GitHub 上的 star 数排名:

英文分词工具

总结

分词就是将句子、段落、文章这种长文本,分解为以字词为单位的数据结构,方便后续的处理分析工作。

分词的原因:

- 将复杂问题转化为数学问题

- 词是一个比较合适的粒度

- 深度学习时代,部分任务中也可以「分字」

中英文分词的3个典型区别:

- 分词方式不同,中文更难

- 英文单词有多种形态,需要词性还原和词干提取

- 中文分词需要考虑粒度问题

中文分词的3大难点

- 没有统一的标准

- 歧义词如何切分

- 新词的识别

3个典型的分词方式:

- 基于词典匹配

- 基于统计

- 基于深度学习

百度百科+维基百科

中文分词就是将连续的字序列按照一定的规范重新组合成词序列的过程。我们知道,在英文的行文中,单词之间是以空格作为自然分界符的,而中文只是字、句和段能通过明显的分界符来简单划界,唯独词没有一个形式上的分界符,虽然英文也同样存在短语的划分问题,不过在词这一层上,中文比之英文要复杂得多、困难得多。

分词是对一串输入字符的部分进行划分和可能分类的过程。然后将得到的标记传递给某种其他形式的处理。该过程可以被认为是解析输入的子任务。

「65页PDF」让 PM 全面理解深度学习

本文汇总了深度学习相关的重要知识点,通过长图和 PDF 的方式呈现给大家,欢迎各位 PM 下载。

回顾过去20年 NLP 的发展趋势

通过 ACL 的论文来看看过去20年,NLP 的发展趋势。

「多图」图解10大CNN架构

本文是10种常见 CNN架构的可视化,帮助你全面了解 CNN 架构的进化过程。