背景

本文是關於產品經理如何將機器學習融入其產品的更大型獨立研究(見下文)中的一部分。它由Ryan Dingler和我自己在加州大學伯克利分校的MBA學習,在Vince Law的幫助下擔任我們的指導老師。

該研究旨在了解產品經理如何設計,規劃和構建支持ML的產品。為了達到這種理解,我們採訪了各個技術公司的15位產品開發專家。在代表的15家公司中,14家公司的市值超過10億美元,11家公開上市,6家是B2C,9家是B2B。

產品經理指導ML系列:

在開始機器學習之前

在確定機器學習(ML)可能有助於解決的問題之後,在與團隊進行模型開發之前採取一些步驟是至關重要的。

根據我們的研究,大多數產品團隊都遵循框架和評估ML問題的結構化流程。在這篇文章中,我們分享了這些學習中最重要的四個。

第1步:編寫機器學習假設

有時,產品團隊只是對他們期望實現的目標有一般意義,就可以開始他們的ML項目。這種非結構化方法的問題在於您將學習更少,並且不會為將來的用例創建框架。

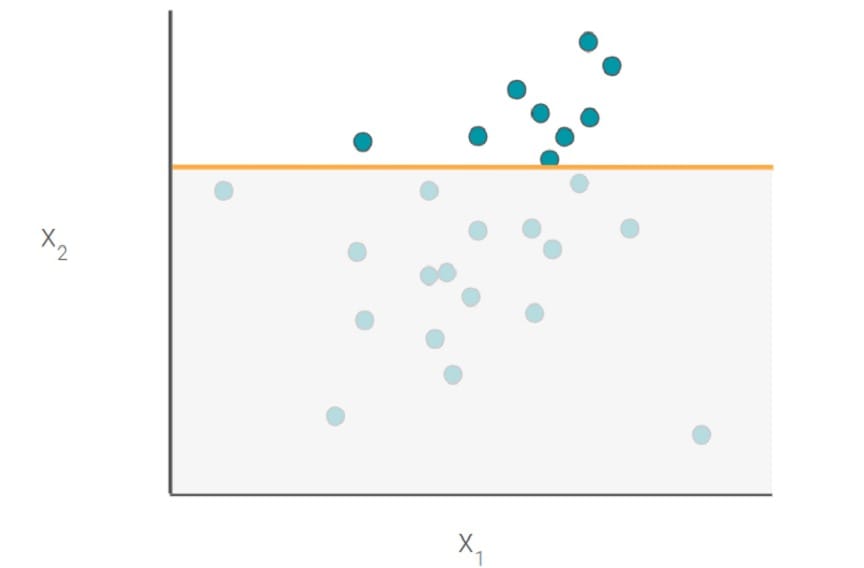

如果沒有一個確定的假設,你也會冒險增加風險(特別是對於較小的數據集),找到一個與你的目標變量相關的隨機特徵。這種相關性可能導致錯誤地認為隨機特徵在您的模型中是相關的,這可能導致模型在生產中概括不足。

一個合理的假設將包含以下所有部分:

- 改變你正在測試

- 期望的結果(高級別)

- 成功指標

- 型號輸出(數字,標籤,簇等)

- 目標

- 預測因子(高級)

例子假設

用ML改善Dropbox中的搜索排名[1。CHANGE]將允許用戶找到正確的文件[2。結果]減少15%的時間[3。METRIC]。該模型將對每個可能的文件進行評分[4。MODEL OUTPUT]使用最近與用戶共享的文件和最近查看的文件[6。PREDICTORS]預測用戶最終選擇的文件[5。TARGET]。

注意:如果跳過假設步驟,請務必小心。我們採訪了一些沒有事先建立實體假設的團隊。他們的假設經常是:「X競爭對手已經這樣做了。為什麼我們不能?「即使您的競爭對手已經這樣做了,我們仍然建議使用上述框架創建一個簡單的假設。

第2步:我需要什麼數據?

一般來說,您的數據需要提供信息並且與要解決的問題有關,但對於ML,數據也需要豐富。一個簡單的經驗法則是為線性模型提供至少數千行數據,為神經網絡提供數十萬行數據。如果您沒有數據,請考慮獲取正確數據的方法或堅持基於啟發式的方法。

假設有足夠的數據,數據仍然必須有一些模式。算法從這些模式中學習。在開始之前你不必知道精確的模式,但是你應該能夠定性地表達它或者有一種直覺。

在Dropbox搜索示例中,產品團隊可能直覺感覺最近與用戶最終選擇的文件相關的文件共享。但是,團隊在開始項目之前不需要知道確切的關係或模式。

最後,請記住,即使數據量很大,也不是所有問題都可以解決。正如我們採訪的一位社交媒體總理所說:「擁有數據並從中獲取價值並不是一回事。」

關鍵點

- 數據需要幫助回答您的假設並具有一些假設模式。

- 即使使用正確的數據,您也可能最終得不到工作模型。

第3步:從啟發式開始

ML模型需要大量數據,複雜,並且在準備好生產之前可能需要很長時間才能開發和測試。因此,在嘗試ML之前,通常最好從一組簡單的啟發式開始。啟發式規則提供了解決難題的捷徑。

啟發式構建速度快,實現起來相對簡單,易於理解。這些規則也可以作為測試您的假設的捷徑,而無需花費大量時間來完善模型。在某種程度上,啟發式算法可以在構建全功能的ML模型之前充當原型工具。

在策劃一個簡單的新聞源時,如果您的假設的期望結果是增加用戶參與度,那麼這可以通過啟發式來實現,該啟發式表達用戶的基本內容。例如,任何一小時超過五個的帖子都會出現在新聞源上。當然,這對於病毒式傳播不是一個非常準確的代理,因此您可能希望在注釋或共享的數量中包含額外的啟發式方法。

在許多情況下,項目可能會停止一組簡單的啟發式(不需要ML)。通常,如果數據不足以滿足ML,或者啟發式方法簡單,性能良好且易於維護,則情況就是如此。我們採訪過的許多公司在他們的啟發式過於複雜之後才開始考慮ML。當您嘗試構建越來越多的相互依賴,重疊和個性化的啟發式時,可能會發生併發症。

關鍵點

- 啟發式掃描可以成為測試您的假設的一個很好的捷徑。

- 如果您的啟發式方法變得太複雜而無法維持或性能滯後,請考慮ML。

第4步:風險管理策略

從圖像識別算法標記不恰當的東西到聊天機械人學習變得文化不合適,有很多ML模型出錯的例子。我們採訪過的許多公司都敏銳地意識到這些問題,並且他們使用風險管理技術來幫助減輕(而不是解決)這些問題。

黑名單

許多公司為可能被視為不良行為者的單詞,短語,群組或組織維護黑名單。

如果您開始在Google搜索中輸入「What fu」,自動填充結果可能是:「什麼是Funk!樂隊,「」什麼是軟糖,「和」未來是什麼。「這個ML模型中沒有四個字母的單詞。Google不會在公司自動填充政策中填寫被視為不當的字詞或短語。另一個例子是Pinterest通過將搜索中的反疫苗接種相關帖子列入黑名單來製作新聞。

機器學習中的偏見

數據收集和解釋的過程通常是有偏見的。許多公司使用內部數據培訓他們的初始模型。這種方法很方便,但它存在問題。

例如,在費用報告中,您公司的人員收集的收據可能不代表您的客戶在全球範圍內收集的收據。這種數據收集偏差會降低您的模型的概括能力,並對類似於您的公司產生偏見。

排除與偏見相關的變量不是答案。許多產品團隊都認為最好從模型中排除種族,性別或其他變量。亞馬遜通過其自動化的簡歷篩選ML模型嘗試了這一點,導致該算法偏向於女性。在許多數據集中,還有其他種族或性別代理。「有了足夠豐富的數據,類成員資格將不可避免地被編碼為其他功能。」 -

處理這種偏見沒有靈丹妙藥。首先,在模型中加入類成員(性別,種族等)等功能,以幫助您衡量確實存在的偏見。一旦測量了偏差,您的解決方案可能取決於用例。在重新訓練模型時,使用緩解技術,在訓練後抵消偏差,甚至改變用戶界面可能是有意義的。

關鍵點

本文轉自 medium,原文地址

Comments