虽然卷积神经网络(CNN)和递归神经网络(RNN)因其在计算机视觉(CV)和自然语言处理(NLP)中的应用而变得越来越重要,而强化学习(RL)作为计算神经科学的框架模型决策过程似乎被低估了。此外,似乎很少有资源详细说明RL如何应用于不同的行业。尽管对RL的弱点提出了批评,但鉴于其在协助决策方面的巨大潜力,RL在企业研究领域绝不应该被忽视。正如Deepmind的研究主管Koray Kavukcuoglu在一次会议上所说的那样,“如果我们在这里工作的目标之一是人工智能,那么它就是核心。强化学习是学习顺序决策任务的一个非常通用的框架。另一方面,深度学习当然是我们必须学习表示的最佳算法集。到目前为止,这两种不同模型的组合是最好的答案,我们在学习非常好的状态表示方面非常具有挑战性的任务,这些任务不仅仅是解决玩具领域,而且实际上是解决具有挑战性的现实世界问题。“

因此,本文旨在1)研究现实世界中RL应用的广度和深度; 2)从不同方面看RL; 3)说服决策者和研究人员加大研究力度。

本文的其余部分组织如下。第一节是一般性介绍。第二节介绍了RL在不同领域的应用,以及如何应用RL的简要说明。第三节总结了应用RL所需要的东西。第四部分是来自其他学科的直觉,第五部分是关于RL如何在将来有用。第六节是结论。

强化学习简介

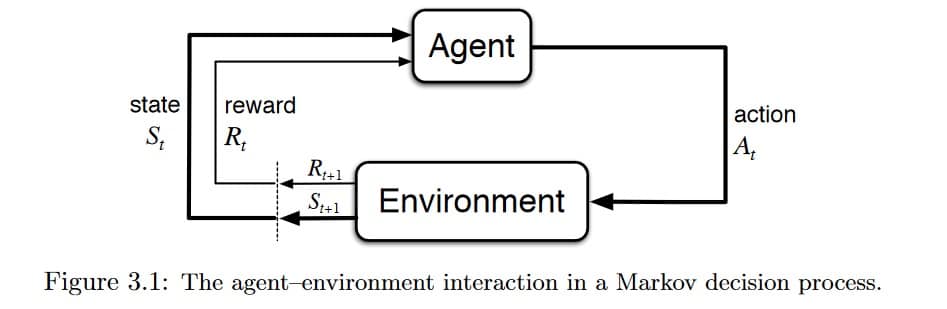

RL,被称为机器学习中的半监督学习模型,是一种允许代理采取行动并与环境交互以最大化总奖励的技术。RL通常被建模为马尔可夫决策过程(MDP)。

想象一下,在您的家中(环境)为婴儿提供电视遥控器。简单来说,婴儿(代理人)将首先观察并构建他/她自己的环境(状态)表示。然后好奇的宝宝将采取某些行动,如击中遥控器(动作)并观察电视如何响应(下一个状态)。由于没有回应的电视很乏味,宝宝不喜欢它(接受负面奖励)并且会采取较少的行动来导致这样的结果(更新政策),反之亦然。婴儿将重复该过程,直到他/她找到他/她满意的政策(在不同情况下该做什么)(最大化(打折)总奖励)。

RL的研究是建立一个解决问题的数学框架。例如,为了找到一个好的策略,我们可以使用基于价值的方法(如Q-learning)来衡量一个特定状态下的行为有多好,或者使用基于策略的方法来直接找出在不同状态下要采取的行动,而不知道有多好行动是。

然而,我们在现实世界中面临的问题可能以许多不同的方式极其复杂,因此典型的RL算法无法解决。例如,在GO的游戏中,状态空间非常大,在扑克游戏中无法完全观察到环境,并且在现实世界中有许多代理彼此交互。研究人员发明了通过使用深度神经网络来模拟所需策略,价值函数甚至过渡模型来解决一些问题的方法,因此称为深度强化学习。本文不区分RL和Deep RL。

有很多关于RL在线和有兴趣的读者可以访问好东西的真棒-RL,argmin和dennybritz。

强化学习的应用

本部分是为一般读者编写的。同时,对于具有RL知识的读者来说,它将具有更大的价值。

计算机集群中的资源管理

设计用于将有限资源分配给不同任务的算法具有挑战性,并且需要人工生成的启发式算法。文章“深度强化学习的资源管理” [2]展示了如何使用RL自动学习分配和安排计算机资源到等待工作,目的是最小化平均工作减速。

国家空间被制定为当前的资源分配和就业资源概况。对于动作空间,他们使用技巧允许代理在每个时间步骤选择多个动作。奖励是系统中所有作业的(-1 /作业持续时间)的总和。然后,他们将REINFORCE算法和基线值结合起来计算政策梯度,并找到最佳政策参数,这些参数给出了最小化目标的行动概率分布。单击此处查看Github上的代码。

交通灯控制

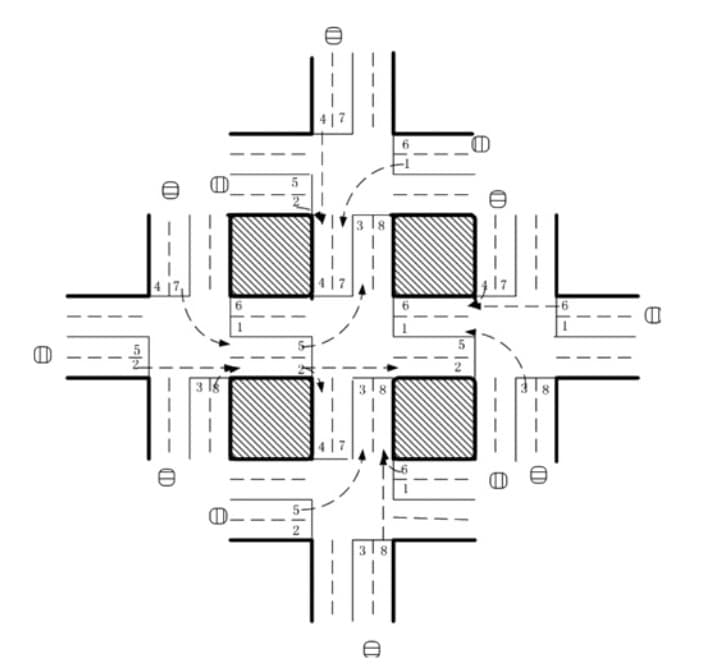

在论文“基于强化学习的网络交通信号控制多智能体系统” [3]中,研究人员试图设计一种交通灯控制器来解决拥堵问题。虽然仅在模拟环境中进行了测试,但它们的方法比传统方法显示出更好的结果,并阐明了多智能体RL在设计交通系统中的潜在用途。

在五个交叉口的交通网络中放置了五个代理,在中央交叉口有一个RL代理来控制交通信号。该状态被定义为八维向量,每个元素代表每个通道的相对交通流量。代理可以使用八种选择,每种选择代表相位组合,并且奖励函数被定义为与先前时间步长相比的延迟减少。作者使用DQN来学习{state,action}对的Q值。

机器人

在机器人技术中应用RL有很多工作要做。有关机器人技术中RL的调查,读者可参考[10]。特别是,[11]训练机器人学习将原始视频图像映射到机器人动作的策略。RGB图像被馈送到CNN并且输出是电机转矩。RL组件是引导策略搜索,用于生成来自其自身状态分布的训练数据。

Web系统配置

Web系统中有超过100个可配置参数,调整参数的过程需要熟练的操作员和大量的跟踪和错误测试。文章“在线Web系统自动配置的强化学习方法” [5]展示了该领域中第一次尝试如何在基于VM的动态环境中对多层Web系统中的参数进行自动重新配置。

重新配置过程可以表示为有限MDP。状态空间是系统配置,每个参数的动作空间是{增加,减少,保持},奖励被定义为给定的目标响应时间和测量的响应时间之间的差异。作者使用无模型Q学习算法来完成任务。

尽管作者使用了一些其他技术,如策略初始化来弥补问题的大状态空间和计算复杂性,而不是RL和神经网络的潜在组合,但相信这一开创性工作为该领域的未来研究铺平了道路。 。

化学

RL也可用于优化化学反应。[4]表明他们的模型优于最先进的算法,并在“利用深度强化学习优化化学反应”一文中推广到不同的潜在机制。

结合LSTM对政策函数进行建模,RL代理使用以{S,A,P,R}为特征的马尔可夫决策过程(MDP)优化化学反应,其中S是一组实验条件(如温度,pH,等等,A是设置所有可能改变实验条件的动作,P是从当前实验条件到下一个条件的转移概率,R是作为状态函数的奖励。

该应用程序非常适合演示RL如何在相对稳定的环境中减少耗时和反复试验的工作。

个性化建议

以前的新闻推荐工作面临着一些挑战,包括新闻动态的快速变化,用户容易感到厌倦,点击率不能反映用户的保留率。关杰等。已经在新闻推荐系统中将RL应用于题为“DRN:新增推荐的深度强化学习框架”的论文中,以解决这些问题[1]。

在实践中,他们构建了四类特征,即A)用户特征和B)上下文特征作为环境的状态特征,以及C)用户新闻特征和D)新闻特征作为动作特征。将四个特征输入到深度Q网络(DQN)以计算Q值。根据Q值选择推荐新闻列表,用户点击新闻是RL代理收到的奖励的一部分。

作者还采用其他技术来解决其他具有挑战性的问题,包括记忆重放,生存模型,决斗强盗梯度下降等。请参阅论文了解详情。

招标和广告

阿里巴巴集团的研究人员发表了一篇论文“在展示广告中实现多代理强化学习的实时招标” [6]并声称他们的基于分布式集群的多智能体代理解决方案(DCMAB)取得了很好的成果,因此他们计划进行在淘宝平台上进行现场测试。

实施细节留待用户调查。一般来说,淘宝广告平台是商家出价以便向顾客展示广告的地方。这可能是一个多代理问题,因为商家互相竞价,他们的行为是相互关联的。在本文中,商家和客户被聚集到不同的组中以降低计算复杂性。代理商的状态空间表示代理商的成本收入状态,行动空间是投标(连续),奖励是客户集群造成的收入。

其他问题,包括不同奖励设置(自利与协调)对代理商收入的影响,也在本文中进行了研究。

游戏

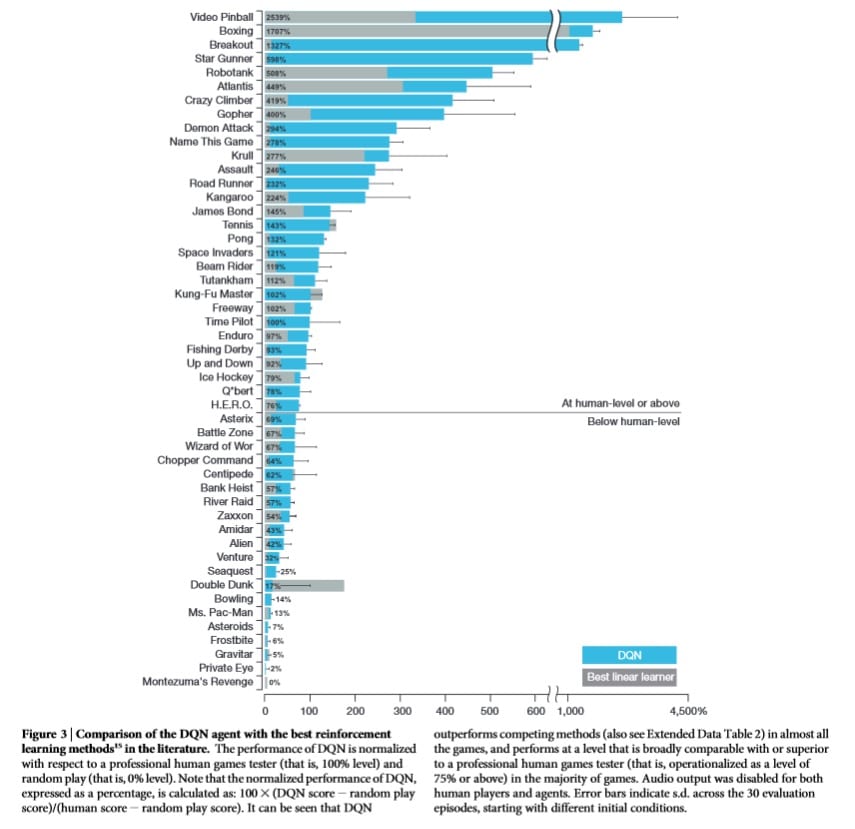

RL现在如此知名,因为它是用于解决不同游戏并有时实现超人类表现的主流算法。

最着名的一个必须是AlphaGo [12]和AlphaGo Zero [13]。AlphaGo受到无数人类游戏的训练,通过在其政策网络中使用价值网络和蒙特卡罗树搜索(MCTS),已经实现了超人类的表现。然而,研究人员后来回想起并尝试了一种更纯粹的RL方法 – 从头开始训练它。研究人员让新的代理商AlphaGo Zero与自己一起玩,最终以100-0击败AlphaGo。

深度学习

最近可以看到越来越多的尝试结合RL和其他深度学习架构,它们显示出令人印象深刻的结果。

RL中最有影响力的工作之一是Deepmind将CNN与RL相结合的开创性工作[7]。通过这样做,代理人能够通过高维感觉“看到”环境,然后学习与之交互。

RL和RNN是人们用来尝试新想法的另一种组合。RNN是一种具有“记忆”的神经网络。当与RL结合使用时,RNN赋予代理记忆事物的能力。例如,[8]将LSTM与RL结合起来创建深度循环Q网络(DRQN)以播放Atari 2600游戏。[4]也使用RNN和RL来解决化学反应优化问题。

Deepmind展示了[9]如何使用生成模型和RL来生成程序。在模型中,受过对侧训练的代理使用信号作为奖励来改善动作,而不是像在GAN训练中那样将梯度传播到输入空间。

在将RL应用于您的问题之前您需要了解的内容

在应用RL之前需要做几件事:

- 理解你的问题:你不一定需要在你的问题中使用RL,有时你也不能使用RL。在决定使用RL之前,您可能想要检查您的问题是否具有以下某些特征:a)反复试验(可以通过接收来自环境的反馈来学习如何做得更好); b)延迟奖励; c)可以建模为MDP; d)你的问题是一个控制问题。

- 模拟环境:在RL算法工作之前需要大量迭代。我相信你不希望看到RL代理人在高速公路上的自动驾驶汽车中尝试不同的事情,对吧?因此,需要能够正确反映现实世界的模拟环境。

- MDP:您的世界需要将您的问题制定为MDP。你需要设计状态空间,动作空间,奖励功能等。您的代理人将在限制条件下完成奖励。如果您以不同的方式设计内容,则可能无法获得所需的结果。

- 算法:您可以选择不同的RL算法和问题。您想直接找出政策还是想学习价值功能?您想要无模型还是基于模型?您是否需要结合其他类型的深层神经网络或方法来解决您的问题?

为了保持客观公正,你也会被告知RL的缺点,这里有一篇很棒的帖子。

来自其他学科的直觉

RL与心理学,生物学和神经科学有着非常密切的关系。如果你考虑一下,RL代理所做的只是反复试验:它根据从环境中获得的回报来了解它的行为有多好或多坏。这正是人类学会做出决定的方式。此外,探索和开发问题,信用分配问题,环境建模尝试也是我们日常生活中所面临的问题。

经济学理论也可以阐明RL。特别是,可以从博弈论的角度理解多智能体强化学习(MARL)的分析,博弈论是约翰纳什开发的一个研究领域,用于理解系统中代理人的相互作用。除了博弈论,MARL,部分可观察马尔可夫决策过程(POMDP)也可用于理解其他经济主题,如市场结构(例如垄断,寡头垄断等),外部性和信息不对称。

强化学习可能在未来实现什么

RL仍有很多问题,不能轻易使用。然而,只要更多努力解决问题,RL将在以下方面具有影响力和影响力:

- 协助人类:也许说RL有朝一日可以演变成人工智能(AGI)太过分了,但RL肯定有可能协助和与人合作。想象一下机器人或虚拟助手与您一起工作并将您的行动纳入考虑范围,以便采取行动以实现共同目标。不是很棒吗?

- 了解不同策略的后果:生活是如此惊人,因为时间不会回归,事情只会发生一次。然而,如果我采取不同的行动,有时候我们想知道事情会有什么不同(至少在短期内)?或者,如果教练采用另一种策略,克罗地亚是否有更大的机会赢得2018年世界杯?当然,要实现这一目标,我们需要对环境,转换函数等进行完美建模,并分析代理之间的交互,这在目前似乎是不可能的。

结论

本文仅展示了各行业中强化学习应用的一些示例。它们不应该限制您的RL用例,并且一如既往,您应该使用第一原则来理解RL的性质和您的问题。

如果您是公司的决策者,我希望这篇文章足以说服您重新思考您的业务,看看是否可以使用RL。如果你是一名研究员,我希望你会同意我的看法,虽然RL仍然有不同的缺点,但这也意味着它有很大的潜力可以改善,并有很多研究机会。

你的想法是什么?你能想到RL可以解决的任何问题吗?

Comments