人工智能正在接管我們的生活 – 而且,似乎是我們的音樂製作。讓我們插入黑客帝國,深入了解……

顧名思義,機器學習是AI的一種形式,計算機算法隨時間分析和存儲數據,然後使用這些數據做出決策並預測未來的結果。深度學習是下一步的演變:算法可以自動使用類似於人類大腦的「神經網絡」,而不需要人類「監督」。簡而言之,計算機代碼行現在可以在某種程度上編程為自己學習,然後使用這些學習在遠遠超過人類能力的範圍內執行複雜的操作。

被認為是過去幾年中軟件開發的最大進步,這項技術得益於計算能力和數據存儲的革命性進步,現在已經成為日常生活中不可或缺的一部分,就像Siri或Alexa智能存儲一樣用於預測未來行動的數據。曾經想知道為什麼Facebook的「你可能會認識的人」以及社交媒體上那些討厭的建議廣告總是如此準確?怪異的,對吧?在我們甚至提到人臉識別軟件,垃圾郵件過濾,圖像分類,欺詐檢測之前……

是的,機器學習算法無處不在,音樂領域也不例外。對於我們在2019年的日常音樂聽眾來說,流媒體服務的算法驅動這些建議列表,幫助您搜索您從未正常發現的新歌曲和藝術家。去年,谷歌的Magenta研究部門開發了開源的NSynth Super,這是一種由NSynth算法驅動的合成器,旨在通過學習現有聲音質量來創造全新的聲音。

與此同時,自從Brian Eno的Koan驅動的Generative Music 1於1990年在軟盤上發佈以來,計算機輔助合成一直存在.Amper Music將這一概念帶入了21世紀:它是一項使用深度學習自動組成計算機的服務 – 根據用戶對「風格」或「情緒」的選擇,為一段媒體生成音樂。內容創作者Taryn Southern以Amper Music的人工智能為基礎,創作了一個完整的曲目,並且自此以後在YouTube上積累了近200萬個劇本。

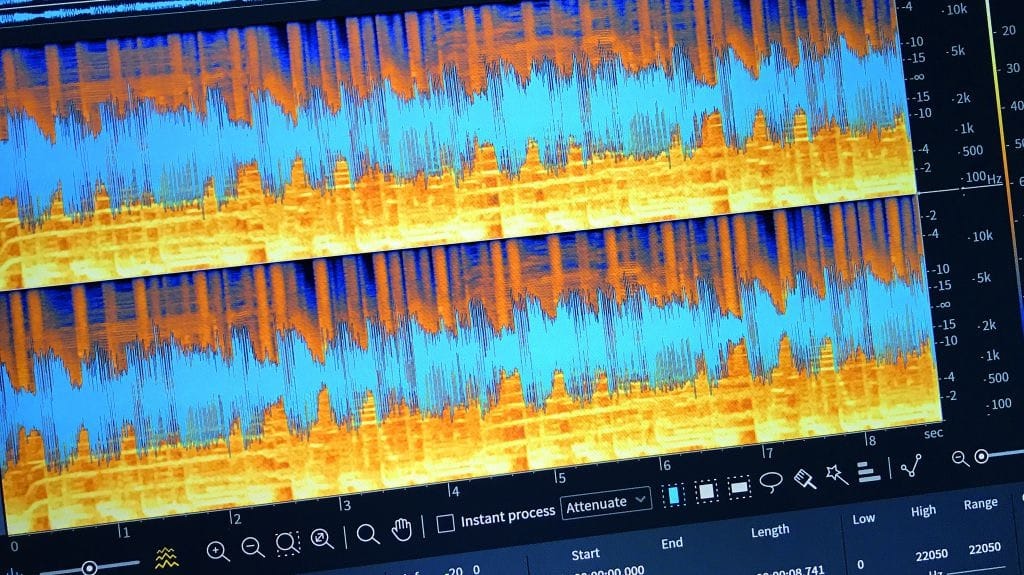

此外,這項技術正在被用來為音樂製作人和表演者提供幫助。Audionamix的Xtrax Stems 2使用基於雲的機器學習輔助將完全混合的立體聲軌道解構為三個組成子詞幹(聲樂,鼓和音樂),然後可用於現場混音和DJ混搭。

無論你認為這些機器是否會接管我們的工作室,很明顯人工智能技術仍然存在,我們正在見證音樂科技革命的開始。

機械人有音樂夢嗎?

軟件製造商iZotope在新版Ozone,Neutron和Nectar上使用了機器學習技術。它的首席技術官Jonathan Bailey讓我們感到……

這些天,「機器學習」和「深度學習」這兩個術語被廣泛使用。他們究竟是什麼意思,用外行人的話來說?

「機器學習是指更廣泛的AI領域內的特定技術,它允許系統在大量數據中查找模式,或者根據以前看不見的數據做出決策。一個常見的例子是面部識別技術。手機上的軟件顯然從未見過您的照片 – 因為它們在您拍攝之前不存在 – 但它可以識別(’分類’)面孔和組(’群集’)它們。

「機器學習技術已經存在了幾十年,主要集中在神經網絡的使用上。神經網絡是連接的統計模型,其靈感來自大腦中的神經元作為連接節點系統的方式。

「在過去十年中,兩種力量相結合,允許機器學習技術的使用取得突破:數字數據的爆炸式增長,以及計算資源的廉價可用性(由於亞馬遜網絡服務等雲計算解決方案)。這就是深度學習的用武之地。深度學習是指使用高度複雜的神經網絡模型,這些模型使用多層節點,以複雜的配置連接,需要強大的計算機來訓練大型數據集並進行操作。

攝影應該殺死繪畫。它沒有。我相信我們發明新想法的能力。

機器/深度學習如何幫助改進音樂家和音頻專業人員的軟件工具?

「過去幾年,iZotope在這些技術上投入了大量資金。來自Neutron的一個例子,我們的智能通道條,使用深度學習來識別(’分類’)音樂會話中任何給定音軌中的音頻表示哪種樂器,並基於該分類,以及我們在其中分析的一些額外的聲學特性音頻,我們建議應用哪種動態,均衡器和/或激勵器設置來為您的混音準備音軌。

「我們現在正在使用深度學習,不僅要分析音頻內容,還要處理它。在我們最近發佈的RX 7中,音樂重新平衡功能使用深度學習將音樂混合物「混合」成單個詞幹,可以重新平衡或單獨處理。我們正在探索將來如何使用深度學習來合成內容。「

有什麼大的利弊?

「深度學習解決了我們過去難以解決的一些問題。例如,我們的許多客戶要求我們採用一種方法來消除記錄中的領夾式麥克風沙沙聲,即使使用我們強大的光譜分析和處理技術也難以解決。

「對於有興趣開發此功能的公司來說,使用深度學習技術變得越來越容易,但它仍然不那麼容易。實施深度學習解決方案的主要挑戰之一是獲得良好的培訓數據。對於傳統上專註於算法開發的公司而言,這是一種新的領域。用於創建神經網絡的軟件是免費提供的,商品技術(Google TensorFlow是一個常見的例子)。正如我所說,對於一定規模的公司來說,獲得大量計算能力是合理的。數據已成為一個巨大的瓶頸,並提出了一個有趣的問題。谷歌提供他們的軟件,並為他們的雲計算服務收取便士,但他們密切保護他們的數據。

「那就是說,深度學習不是靈丹妙藥。我們仍然非常依賴來自數字信號處理規範的知識。學習如何有效地使用和訓練深度神經網絡變得越來越容易,但是尖端的研究仍然由高技能的科學家(通常是博士)完成。神經網絡可能很難調試,有時它們會起到一種「黑匣子」的作用 – 你並不完全知道內部發生了什麼。它們也是計算和資源密集型的,因此使它們在某些實時應用程序(如合成器或音頻插件)中工作非常具有挑戰性。

「深度學習是一個令人興奮的故事,但最終,我們希望客戶得到的結果不是魔法,而是她如何到達那裡。」

音樂家如何在保留創造力的同時利用這項技術?

「有幾個不同的研究營地。一個來自音樂學世界,專註於算法音樂作品。在這個領域,您擁有Amper Music,他們的產品可以為您的內容創建生成音樂示例,例如您的YouTube視頻或廣告。其他人專註於自動伴奏等應用。因此,一些團體正試圖自動化創造力,而其他團體則試圖加強創造力。

「這是一個非常微妙的平衡,但iZotope堅定地在增強創造力的陣營。我非常欽佩Google Magenta這樣的研究團隊,他們的目的是利用機器學習創造藝術 – 但這不是iZotope的理念或策略。我們希望使用深度學習來幫助您創作藝術。我們目前更專註於技術應用,但我確實看到我們進入更具創意的領域,只要我們堅持我們的創意目標。我們不是要取代人類的創造力。「

那麼軟件最終會為我們編寫和混合我們的音樂嗎?

「在某些情況下,它已經是。如果你是一個偉大的創作型歌手,但你從未在生活中開闢過DAW,深度學習將能夠幫助你獲得一個聽起來很棒的錄音,而無需了解壓縮機是什麼。如果您整天在DAW工作,它將了解您喜歡和不喜歡的效果,完成工作所需的視覺和聽覺信息,並讓您專註於音樂本身。

「攝影應該會扼殺繪畫。它沒有。我相信我們發明新想法的能力。」

本文轉自musicradar,原文地址

Comments