在這篇文章中,我們將幫助你更好的理解監督學習、非監督學習和強化學習的定義的內涵,並從更廣闊的視角中闡述它們與機器學習之間的聯繫。深入理解它們的內涵不僅有助於你在這一領域的文獻中盡情的徜徉,更能引導你敏銳地捕捉到AI領域的發展和技術進步的氣息。

Author Archive

不平凡的2018 | 機械人十大年度進展全回顧

在過去的2018年,各個領域的技術都有了巨大的進步,機械人領域同樣如此。Science近日挑選了10款從實驗室的原型研究到推動各領域進步的商業機械人,濃縮了過去一年機械人領域值得回顧的重要進展。

如何構建多快好省的「知識圖譜即服務」?

知識圖譜作為一種特殊的圖數據,不僅人類可以識別且對機器友好。信息檢索、問答系統、推薦系統、電子商務、金融風控,這些生活中常見的應用場景都離不開知識圖譜的支持。如何構建一個「多快好省」的知識服務系統?微軟亞洲研究院機器學習組的研究員們基於自己的經驗,給出了他們的建議

文本挖掘 – Text mining

網絡上存在大量的數字化文本,通過文本挖掘我們可以獲得很多有價值的信息。

本文將告訴大家什麼是文本挖掘,以及他的處理步驟和常用的處理方法。

想要了解更多 NLP 相關的內容,請訪問 NLP專題 ,免費提供59頁的NLP文檔下載。

訪問 NLP 專題,下載 59 頁免費 PDF

什麼是文本挖掘?

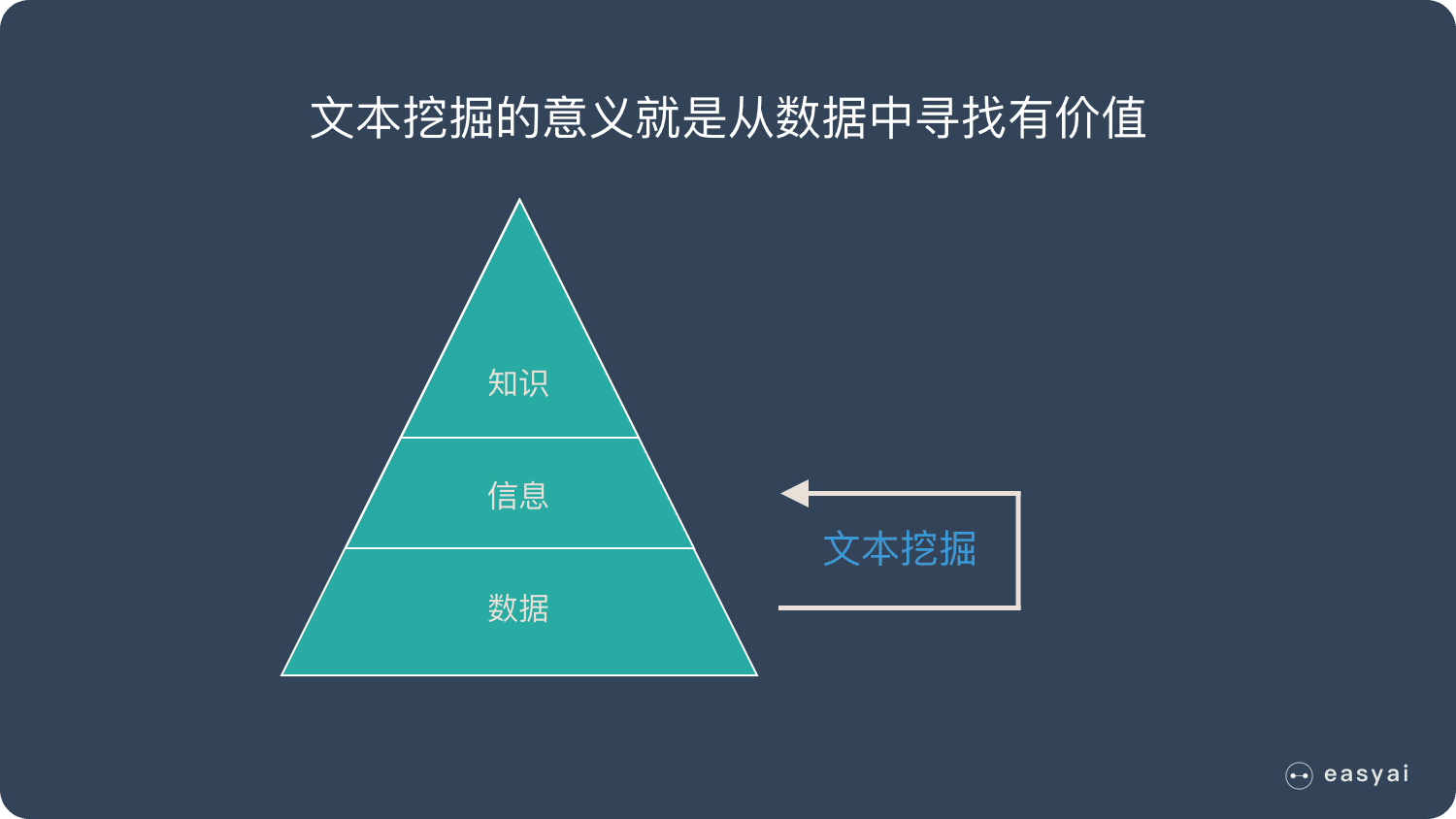

每到春節期間,買火車票和機票離開一線城市的人暴增——這是數據

再匹配這些人的身份證信息,發現這些人都是從一線城市回到自己的老家——這是信息

回老家跟家人團聚,一起過春節是中國的習俗——這是知識

上面的例子是顯而易見的,但是在實際業務中,有很多不是那麼顯而易見的信息,比如:

- 每周末流量會有規律性的上升或者下降,這是為什麼?

- 國慶長假,使用 iPad 購物比例比平時要高,這時為什麼?

- ……

而文本挖掘的意義就是從數據中尋找有價值的信息,來發現或者解決一些實際問題。

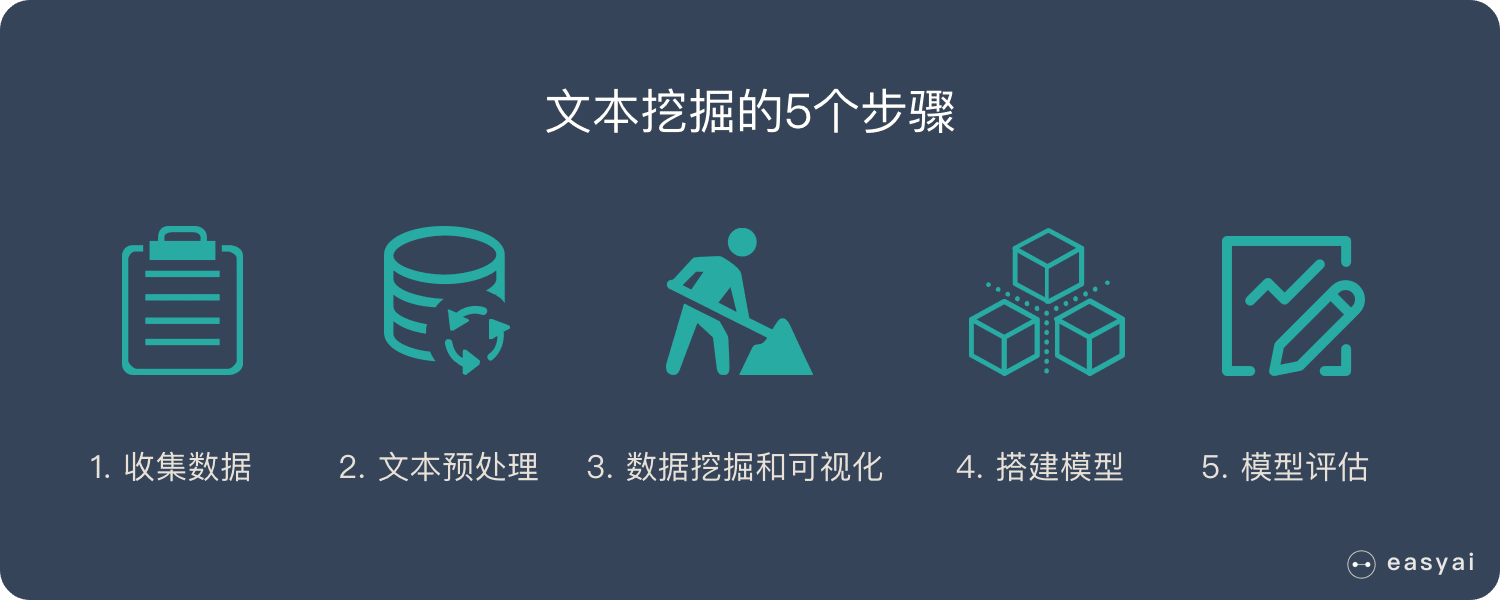

文本挖掘的5個步驟

文本挖掘大致分為以下5個重要的步驟。

文本挖掘的5個步驟:

- 數據收集

- 文本預處理

- 數據挖掘和可視化

- 搭建模型

- 模型評估

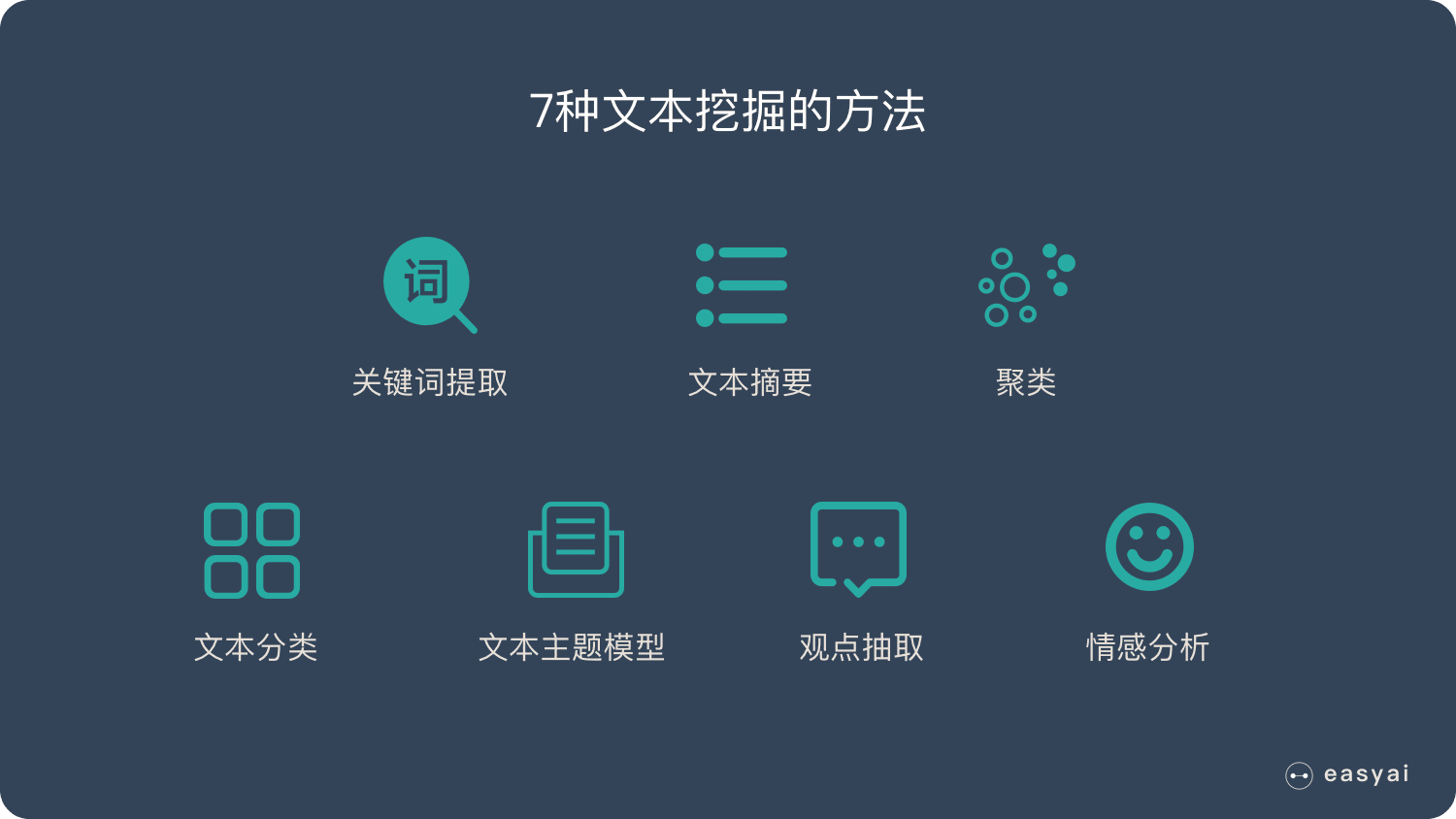

7種文本挖掘的方法

關鍵詞提取:對長文本的內容進行分析,輸出能夠反映文本關鍵信息的關鍵詞。

文本摘要:許多文本挖掘應用程序需要總結文本文檔,以便對大型文檔或某一主題的文檔集合做出簡要概述。

聚類:聚類是未標註文本中獲取隱藏數據結構的技術,常見的有 K均值聚類和層次聚類。更多見 無監督學習

文本分類:文本分類使用監督學習的方法,以對未知數據的分類進行預測的機器學習方法。

文本主題模型 LDA:LDA(Latent Dirichlet Allocation)是一種文檔主題生成模型,也稱為一個三層貝葉斯概率模型,包含詞、主題和文檔三層結構。

觀點抽取:對文本(主要針對評論)進行分析,抽取出核心觀點,並判斷極性(正負面),主要用於電商、美食、酒店、汽車等評論進行分析。

情感分析:對文本進行情感傾向判斷,將文本情感分為正向、負向、中性。用於口碑分析、話題監控、輿情分析。

維基百科版本

文本挖掘,也稱為文本數據挖掘,大致相當於文本分析,是從文本中獲取高質量信息的過程。高質量信息通常是通過統計模式學習等手段設計模式和趨勢而得出的。文本挖掘通常涉及構造輸入文本的過程(通常解析,添加一些派生的語言特徵和刪除其他特徵,然後插入到數據庫中),在結構化數據中導出模式,最後評估和解釋輸出。文本挖掘中的「高質量」通常是指相關性,新穎性和興趣的某種組合。典型的文本挖掘任務包括文本分類,文本聚類,概念/實體提取,粒度分類法的生成,情感分析,文檔摘要和實體關係建模(即,命名實體之間的學習關係)。

文本分析涉及信息檢索,詞彙分析以研究詞頻分佈,模式識別,標記 / 注釋,信息提取,數據挖掘技術,包括鏈接和關聯分析,可視化和預測分析。最重要的目標是通過應用自然語言處理(NLP)和分析方法將文本轉換為數據進行分析。 典型的應用是掃描以自然語言編寫的一組文檔,並為文檔集建模以用於預測分類目的,或者用提取的信息填充數據庫或搜索索引。

擴展閱讀

2018年10大機器學習開源項目

本期將為大家推薦 10 個機器學習開源項目,統計了過去一個月中 250 個機器學習開源項目,並從中選取了本期的 Top10。平均 1483 Stars。

BERT | Bidirectional Encoder Representation from Transformers

想要了解更多 NLP 相關的內容,請訪問 NLP專題 ,免費提供59頁的NLP文檔下載。

訪問 NLP 專題,下載 59 頁免費 PDF

什麼是 BERT?

BERT的全稱是Bidirectional Encoder Representation from Transformers,即雙向Transformer的Encoder,因為decoder是不能獲要預測的信息的。模型的主要創新點都在pre-train方法上,即用了Masked LM和Next Sentence Prediction兩種方法分別捕捉詞語和句子級別的representation。

從現在的大趨勢來看,使用某種模型預訓練一個語言模型看起來是一種比較靠譜的方法。從之前AI2的 ELMo,到 OpenAI的fine-tune transformer,再到Google的這個BERT,全都是對預訓練的語言模型的應用。BERT這個模型與其它兩個不同的是

- 它在訓練雙向語言模型時以減小的概率把少量的詞替成了Mask或者另一個隨機的詞。我個人感覺這個目的在於使模型被迫增加對上下文的記憶。至於這個概率,我猜是Jacob拍腦袋隨便設的。

- 增加了一個預測下一句的loss。這個看起來就比較新奇了。

BERT模型具有以下兩個特點:

- 是這個模型非常的深,12層,並不寬(wide),中間層只有1024,而之前的Transformer模型中間層有2048。這似乎又印證了計算機圖像處理的一個觀點——深而窄 比 淺而寬 的模型更好。

- MLM(Masked Language Model),同時利用左側和右側的詞語,這個在ELMo上已經出現了,絕對不是原創。其次,對於Mask(遮擋)在語言模型上的應用,已經被Ziang Xie提出了(我很有幸的也參與到了這篇論文中):[1703.02573] Data Noising as Smoothing in Neural Network Language Models。這也是篇巨星雲集的論文:Sida Wang,Jiwei Li(香儂科技的創始人兼CEO兼史上發文最多的NLP學者),Andrew Ng,Dan Jurafsky都是Coauthor。但很可惜的是他們沒有關注到這篇論文。用這篇論文的方法去做Masking,相信BRET的能力說不定還會有提升。

內容來自:【NLP】Google BERT詳解 | [NLP自然語言處理]谷歌BERT模型深度解析

擴展閱讀

當訓練數據和測試數據不同時怎麼辦?

為了建立性能良好的機器學習(ML)模型,必須在來自相同目標分佈的數據上訓練模型並進行測試。然而,有時我們只能從目標分佈中收集到有限數量的數據。這些數據可能不足以構建所需的訓練/開發/測試集。

2種簡單的方式緩解RNN的優化問題

在上一節(如何理解RNN?(理論篇))的課程我們介紹了循環神經網絡的基本結構,同時這樣的循環結構也會給優化帶來一定的困難,本文主要介紹兩種較為簡單的方式來緩解RNN的優化問題

如何理解RNN?(理論篇)

帶有循環結構的網絡都可以被叫做循環神經網絡(recurrent neural network),RNN可以非常有效的解決這個問題,從簡單的理論上來說,它可以處理任意長度的序列,並且不需要提前將N固定住,靈活性更高。